NAS 2023 - Hardware

-

Ich bastel gerne und baue auch gerne mein Setup zu Hause gerne mal komplett um. Es war mal wieder so weit. Warum? Ich hatte das Zima-Board ausprobiert. Dabei kam ich wieder mit dieser richtig geilen Software Proxmox in Berührung. Nach ein paar Tagen war ich wieder so weit, es musste passende Hardware dafür her

Mal die Auflistung der Hardwarekomponenten

- Gehäuse: Sharkoon QB One https://de.sharkoon.com/product/16433#desc

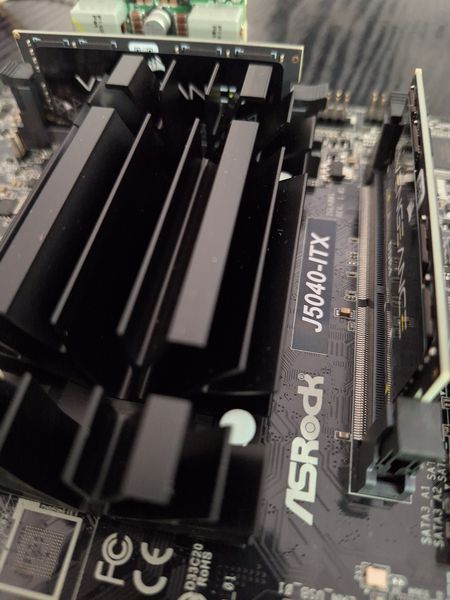

- Mainboard: ASRock J5040-ITX https://www.asrock.com/MB/Intel/J5040-ITX/index.de.asp#Overview

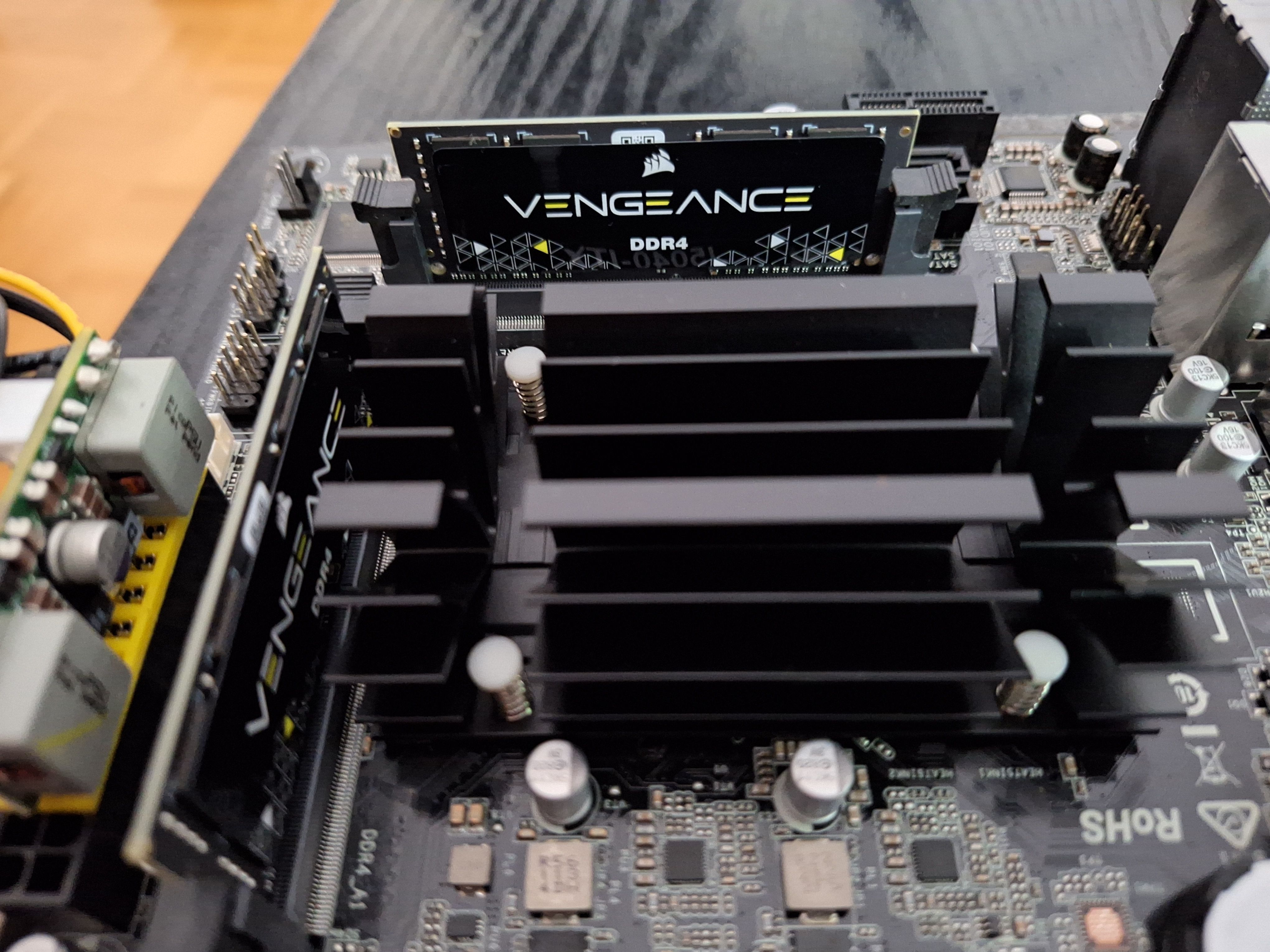

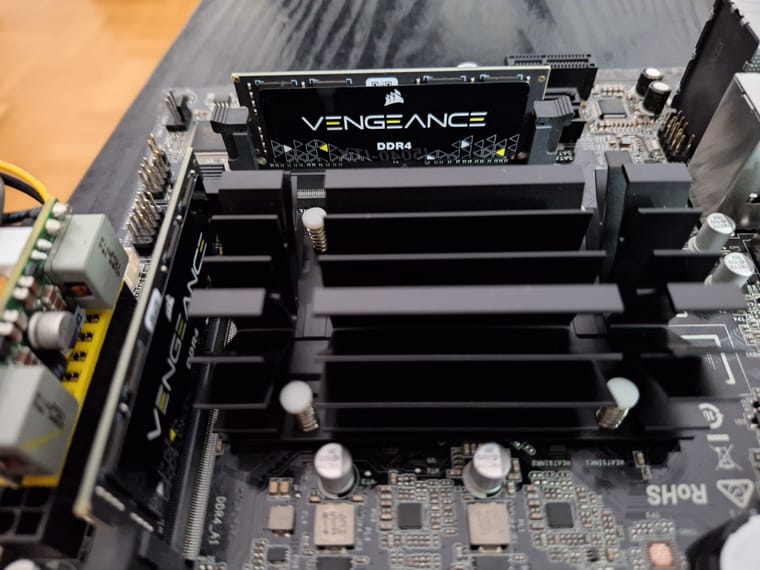

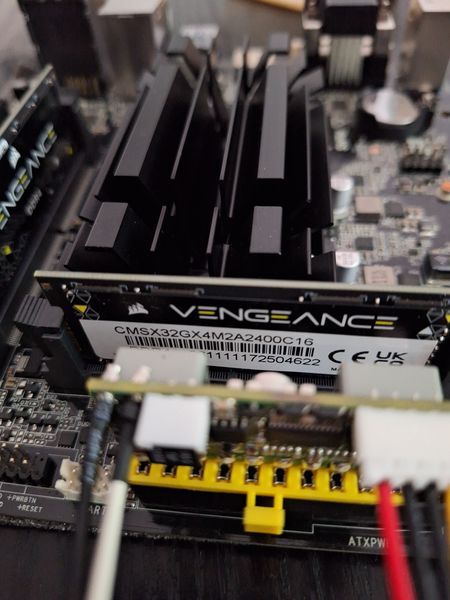

- RAM: Corsair Vengeance SODIMM 32GB (2x16GB) DDR4 2400MHz CL16 https://www.corsair.com/de/de/Kategorien/Produkte/Arbeitsspeicher/VENGEANCE-DDR4-SODIMM/p/CMSX32GX4M2A2400C16

- PicoPSU-80 12V-DC/DC-ATX-Netzteil (Lüfterlos, 80W)

- LEICKE 60 W-Netzteil

- Delock USB 3.0 Pinhead auf 2X Adapter 65324 2-Fach USB 3.0

- Adapter USB3 → NVMe

Kosten OHNE Laufwerke ca. 350€

Als Speicher sind zwei dieser Module verbaut. Macht 32GB RAM

Das ASRock Board J5040-ITX ist passiv gekühlt

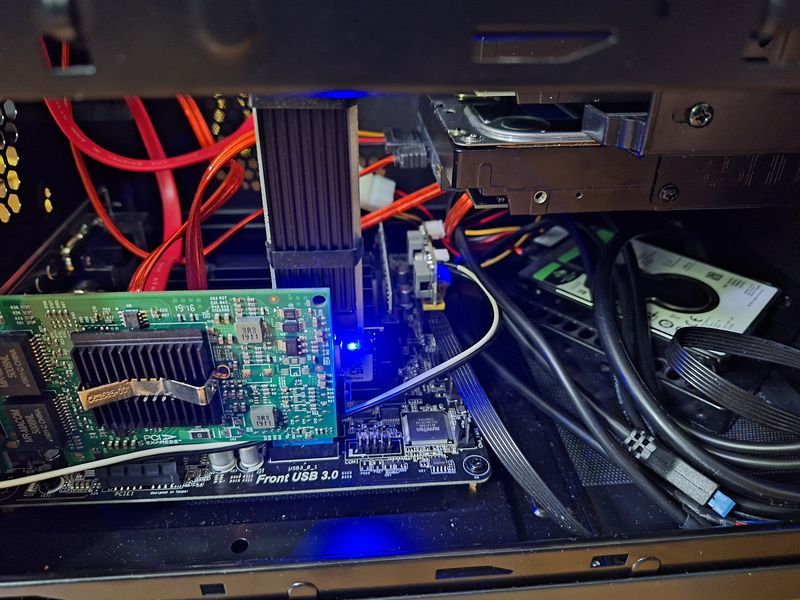

Der NVMe Riegel für das Betriebssystem steckt mit passendem Adapter im Board Anschluss für den Front USB 3.0 Anschluss.

Blick auf die PCIe Netzwerkkarte mit zwei 1GB LAN Schnittstellen

Der zweite Teil wird sich dann mit der Softwarekonfiguration beschäftigen.

Hier mal der Stromverbrauch, gemessen mit einem Voltcraft SEM6000. Die Messung ist mit einem 90W Netzteil, das wird gegen ein 60W Netzteil ausgetauscht. Ich reiche eine neue Messung nach.

Achso, für den Tippfehler in Voltcraft kann ich nichts

Ich werde das gelegentlich ergänzen, wenn mir noch was einfällt

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM verschob dieses Thema von Privat am

F FrankM verschob dieses Thema von Privat am

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

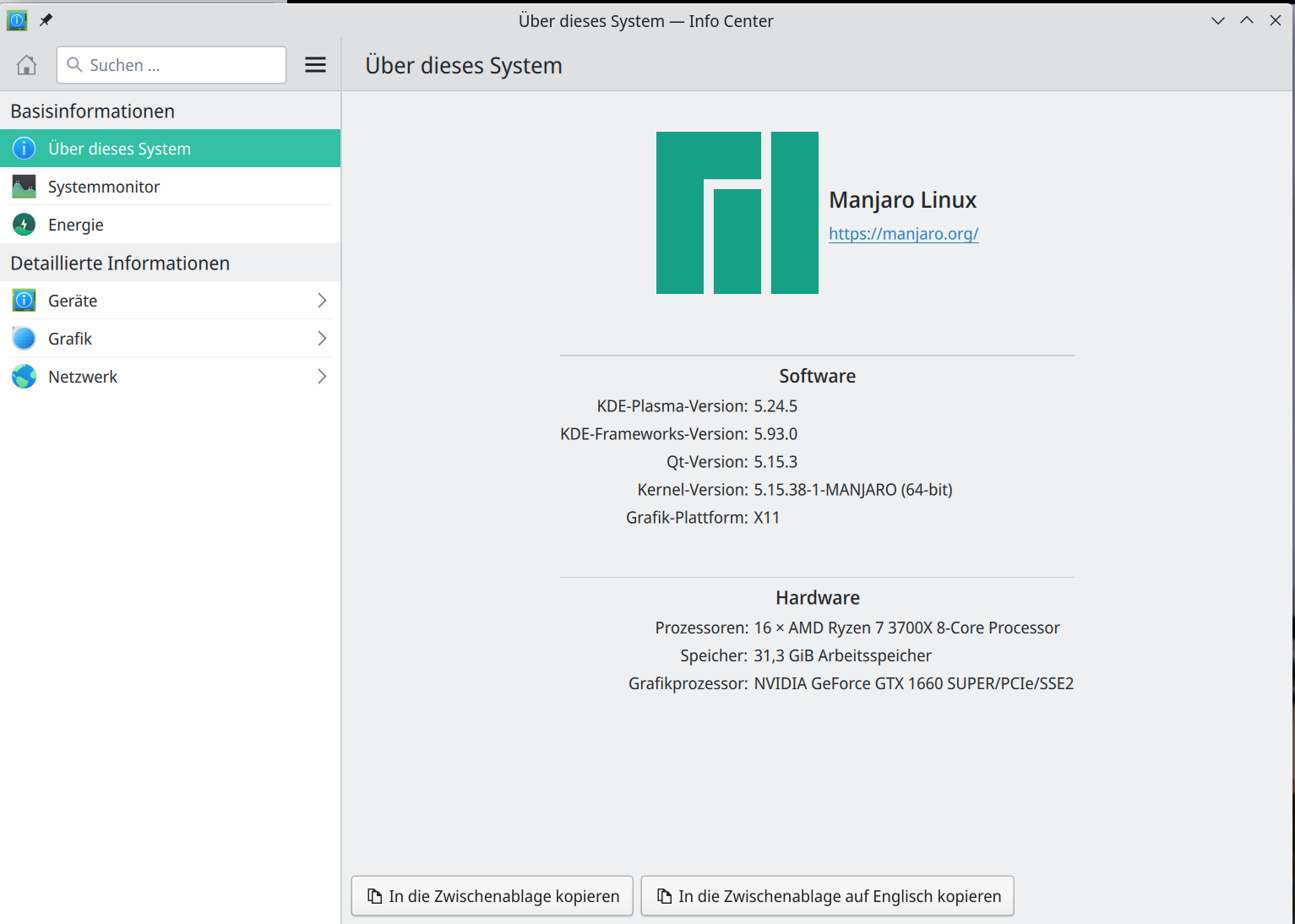

Ich hatte mit Proxmox und dem Kernel 5.15 immer das Problem, das die CPU auf volle Pulle lief. Also, in etwas so

root@pve:~# cat /sys/devices/system/cpu/cpu*/cpufreq/scaling_cur_freq 2995200 2995200 2995200 31634673,2GHz ist ja der Maximaltakt. Ich konnte aber nie beobachten, das sich da etwas geändert hat. Umschalten von Hand konnte ich das. Also mit

echo "powersave" | tee /sys/devices/system/cpu/cpu*/cpufreq/scaling_governorAber, das war ja irgendwie nicht die Lösung. Dann heute im Proxmox-Forum darüber gestolpert, das es einen 6.2er Kernel gibt. Versuch macht klug....

Ok, installiert

apt update apt install pve-kernel-6.2 rebootDanach habe ich einen 6.2er Kernel

root@pve:~# uname -a Linux pve 6.2.11-2-pve #1 SMP PREEMPT_DYNAMIC PVE 6.2.11-2 (2023-05-10T09:13Z) x86_64 GNU/LinuxUnd siehe da, nun habe ich auch vernünftige Prozessor Taktraten. Das ist aktuell im Idle, wenn die pfSense und mein NAS keine Arbeit haben.

root@pve:~# cat /sys/devices/system/cpu/cpu*/cpufreq/scaling_cur_freq 1098220 1098240 1098233 1098240Problem gelöst. Jetzt zicken die Platten noch was rum, die ich gerne abschalten würde

-

Ich war nicht so ganz zufrieden

Die zwei 4TB 5 1/4 Zoll HDDs müssen jetzt mal weichen.

Die zwei 4TB 5 1/4 Zoll HDDs müssen jetzt mal weichen.

Ich habe jetzt wieder einen Proxmox Backup Server im Einsatz, da brauche ich nicht mehr so viel Speicherplatz im NAS. Kleiner, aber wichtiger Nebeneffekt ist der, das ich jetzt ca. 7W eingespart habe. In Zeiten wie diesen, rechnet sich das. Nein, die Investitionskosten rechnen wir jetzt nicht dagegen

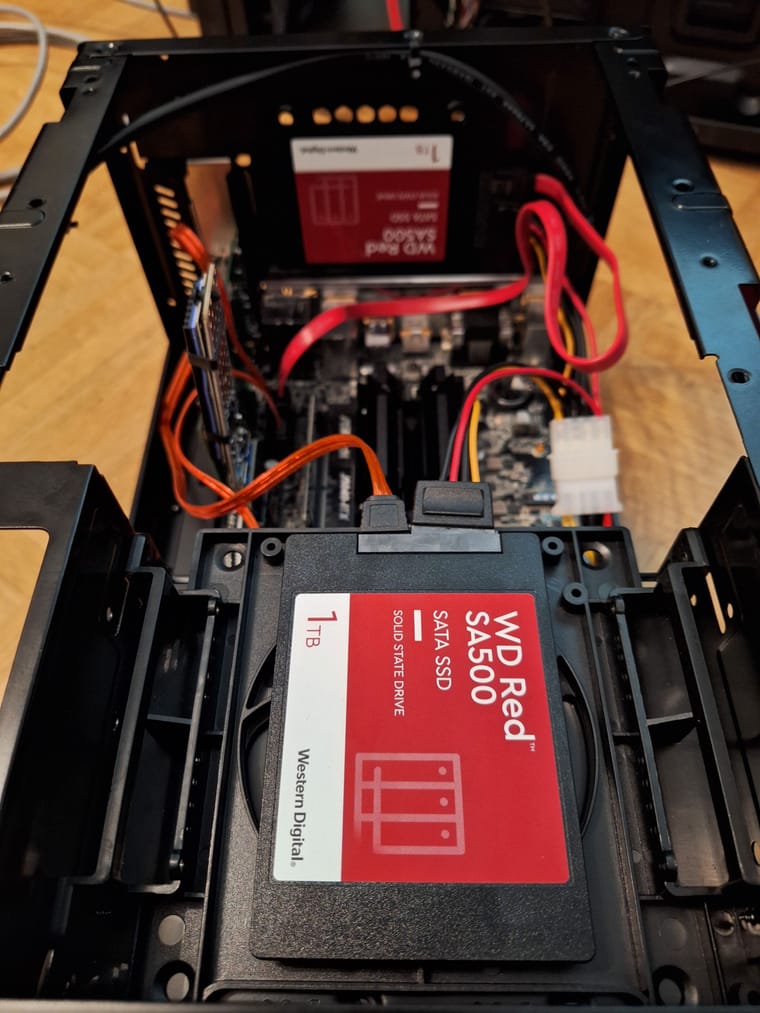

Aktuelle Platten Ausstattung

- 1 TB NVMe SSD (Proxmox Systemplatte)

- 2 * 2,5 Zoll 1TB SSD WD Red (ZFS Pool für mein NAS)

- 1 * 2,5 Zoll HDD 2TB für Datensicherung

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat dieses Thema am angepinnt

F FrankM hat dieses Thema am angepinnt

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

-

-

-

-

-

-

-

Restic - Ein Backupkonzept

Angeheftet Restic