NAS 2023 - Software Teil 1

-

Kommen wir zum schwierigen Teil. Man kann ja auch alles mit einem Debian Server machen, aber ich hatte mich mal wieder für einen Proxmox entschieden. Habe ja schon öfter einen gehabt und finde ihn immer wieder sehr praktisch.

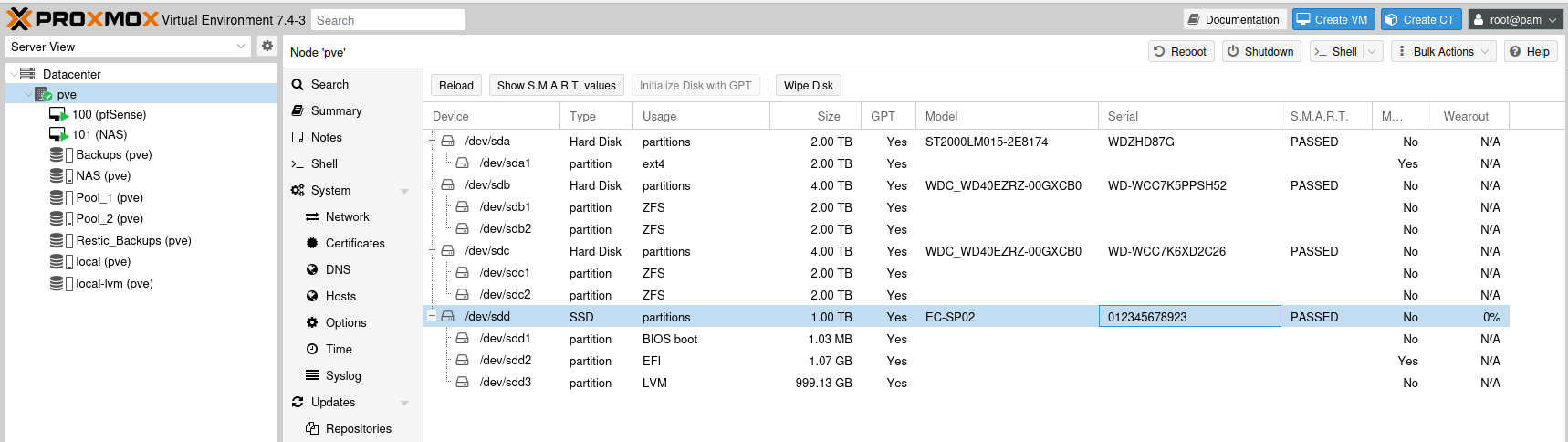

Auf dem NVMe SSD Riegel habe ich eine Standardinstallation mit dem ISO Image von Proxmox durchgeführt. Das kennt man ja so weit schon.

Kleiner Tipp, macht die Installation immer schon am richtigen Netzwerk (falls mehrere vorhanden sind), das hinterher zu ändern ist immer unnötige Arbeit.

Ich hatte einige Probleme ein verschlüsseltes RIADs einzurichten bzw. überhaupt RAIDs. Die waren immer wieder nach einem Reboot weg!? Ich habe das dann mal für mich auf den fehlenden GRUB geschoben!??

Device Start End Sectors Size Type /dev/sdd1 34 2047 2014 1007K BIOS boot /dev/sdd2 2048 2099199 2097152 1G EFI System /dev/sdd3 2099200 1953525134 1951425935 930.5G Linux LVMIch habe es dann mit den Möglichkeiten von Proxmox (GUI) realisiert. Dazu bietet Proxmox ja ZFS an und ich hatte das schon mal länger hier im Einsatz. Na dann halt jetzt auch wieder.

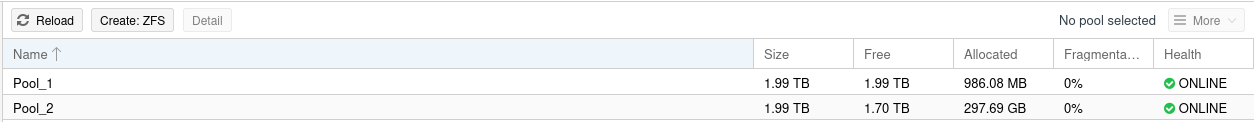

Also, die zwei 4TB-Platten geteilt und zwei ZFS Pools angelegt.

Jetzt konnte ich aber immer noch nicht das machen, was ich wollte. Die Pools konnten nur Disk Image & Container enthalten!?

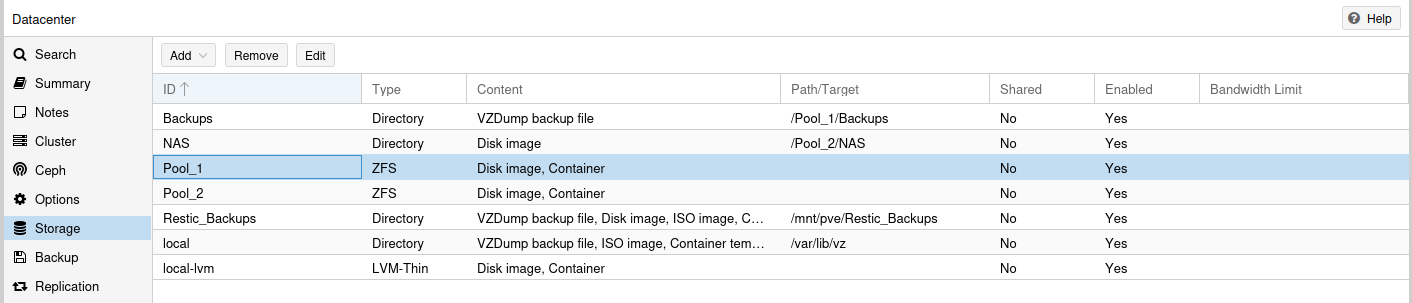

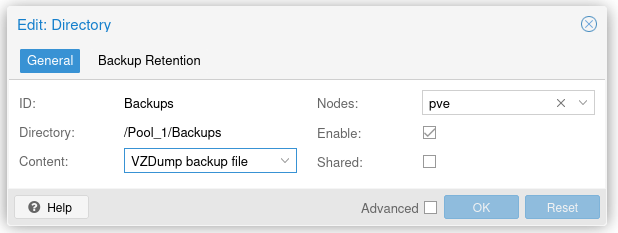

Man kann aber unter Datacenter - Storage -Add ein Directory anlegen. Das bekommt irgendeinen Namen und als Pfad folgendes übergeben

/Pool_1/BackupsDas sieht dann so aus.

Was macht das im Hintergrund, es legt ein Volume auf dem ZFS-Pool an.

root@pve:~# zfs list NAME USED AVAIL REFER MOUNTPOINT Pool_1 940M 1.76T 96K /Pool_1 Pool_1/Backups 939M 1.76T 939M /Pool_1/Backups Pool_2 277G 1.49T 96K /Pool_2 Pool_2/NAS 277G 1.49T 277G /Pool_2/NASUnd jetzt bin ich in der Lage, dem Volume zuzuweisen, was ich dort speichern möchte.

Jetzt was Wichtiges. Der Teil mit ZFS kann Fehler enthalten, wer es besser weiß, ich freue mich immer über Verbesserungen und Korrekturen.

Jetzt habe ich das so, wie ich das haben möchte. Ein Pool kümmert sich um Datensicherungen usw. Der ander Pool dient meinem NAS als Datenspeicher.

Nächster Teil wird sich dann mit der Einrichtung der pfSense VM beschäftigen.

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM verschob dieses Thema von Privat am

F FrankM verschob dieses Thema von Privat am

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat dieses Thema am angepinnt

F FrankM hat dieses Thema am angepinnt