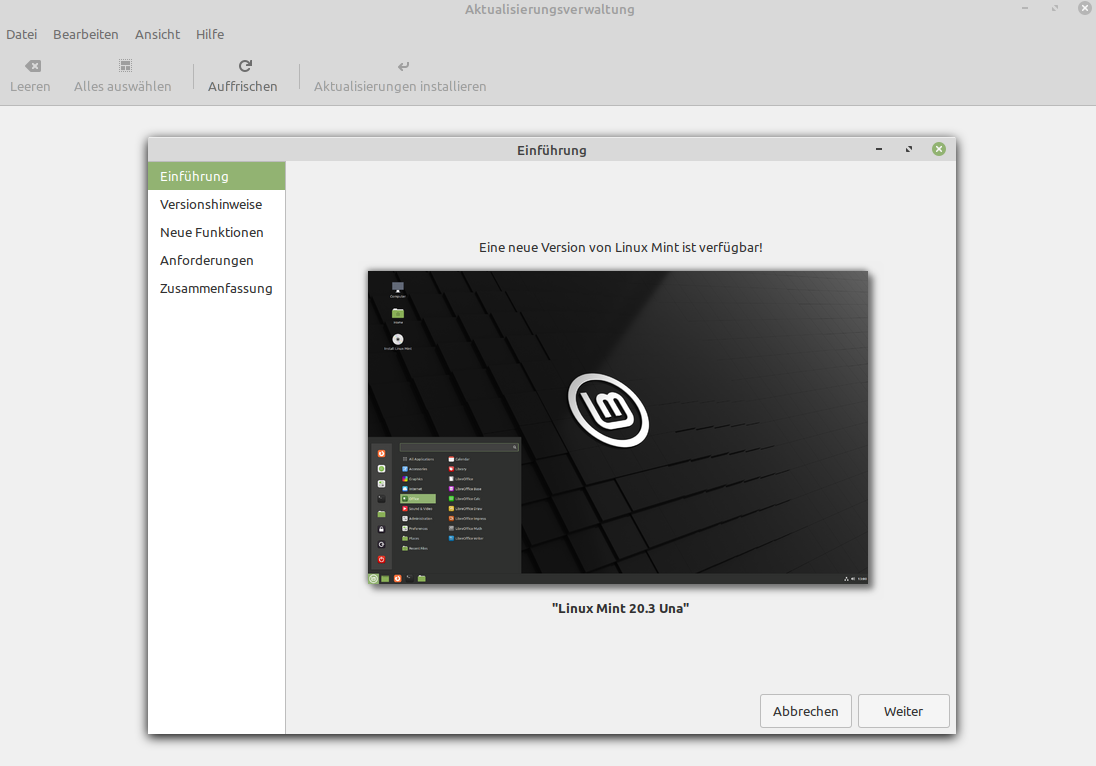

Linux Mint "Una" Cinnamon 20.3

-

schrieb am 6. Jan. 2022, 21:36 zuletzt editiert von FrankM

So, da sind die Images

Es gibt die Desktops

- Cinnamon

- Mate

- Xfce

Sollte also für fast jeden was dabei sein.

-

schrieb am 7. Jan. 2022, 04:50 zuletzt editiert von

-

schrieb am 9. Jan. 2022, 20:05 zuletzt editiert von

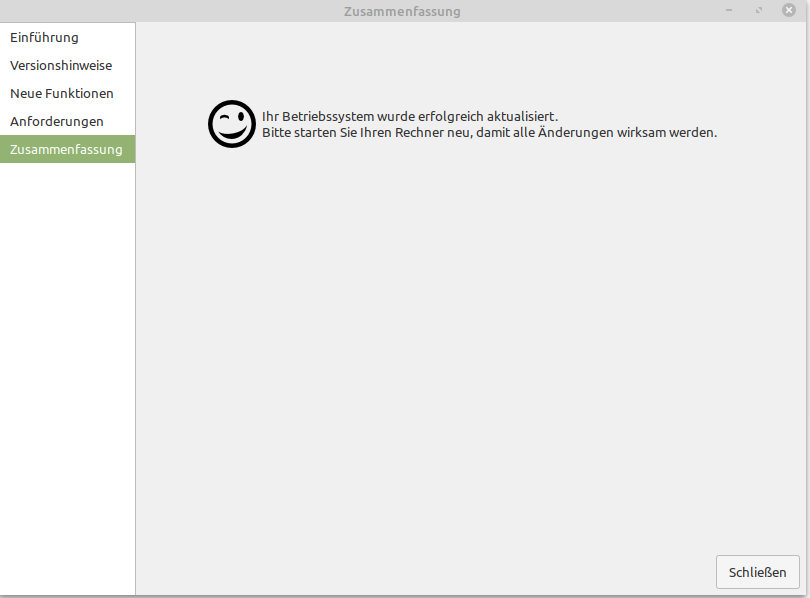

Am WE mal kurz die Installation auf 20.3 gebracht, war völlig schmerzfrei

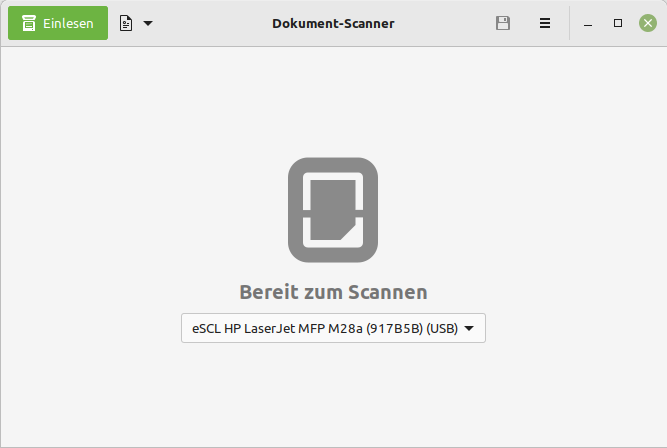

Nur ein Problem hat mich mal wieder eingeholt, der liebe Drucker bzw. Scanner. Das Scannen funktioniert mal wieder nicht. Damit scheidet die Fa. HP als Lieferant für meinen nächsten Drucker aus.

Für die Neuigkeiten schaut ihr bitte auf der Linux Mint Webseite nach.

Und dran denken, Open Source Software lebt nicht nur von Luft und Liebe

-

schrieb am 9. Jan. 2022, 21:35 zuletzt editiert von

Manche Dinge lassen einem ja keine Ruhe.....

Drucker und Scanner laufen

Anleitung hilft manchmal.....

Printing and Scanning improvements

HPLIP was upgraded to version 3.21.8 to bring the latest support for HP printers and scanner.

The latest versions of ipp-usb and sane-airscan were also backported and are available in the Linux Mint 20.3 repositories. Try them out if you can't get your printer or scanner to work with software drivers.

Ok, der Drucker ließ sich mittels CUPS Webinterface hinzufügen. HP hat so viele Drucker, das ich ein Suchfeld vermisst habe. Nach 4 Minuten scrollen, hatte ich ihn dann irgendwann gefunden.

Der Scanner wurde mit der Nachinstallation

apt install sane-airscanzum Laufen überreden.

Problem erledigt, bis zum nächsten großen Linux Mint Update habe ich ja jetzt Ruhe..

-

schrieb am 14. Jan. 2022, 16:48 zuletzt editiert von FrankM

Wie der Maintainer Clément Lefèbvre von Linux Mint verkündet hatte, arbeitet man jetzt enger mit Mozilla zusammen um aktuellere Firefox Versionen in Linux Mint Cinnamon bereitzustellen. Blog Beitrag

Die Version 96.0 kam am 11. Januar 2022 raus. Siehe hier

Infolge dessen, kam es zu einem Problem.Und heute ist bei mir der FF 96.0 gelandet, das ist jetzt nicht so schlecht. Das Ganze jetzt bitte noch für den Thunderbird, weil der ist in LM Cinnamon auch "uralt". Linux Mint Forum

-

schrieb am 22. Jan. 2022, 08:39 zuletzt editiert von

-

schrieb am 24. Jan. 2022, 16:49 zuletzt editiert von