MongoDB - Erste Erfahrungen

-

Ich nutze jetzt schon sehr lange Redis, vor allen Dingen wegen meinen Foren. NodeBB unterstützt Redis und MongoDB. Ich hatte damals bei der Installation Redis ausgewählt und bin damit bis heute auch sehr zufrieden. Benutze Redis auch als Cache für meine Nextcloud Installation. Auch Redis Replication wird gerne benutzt usw. Also ein zufriedener Redis Nutzer

Redis ändert das Lizenz Modell

Jetzt hat sich da ja was verändert, der einen dazu bringt mal Dinge zu überdenken oder auch einfach mal Neues auszuprobieren. Da ich für meine kleinen Python Projekte auch Redis einsetze, habe ich mir mal gedacht, testen wir doch mal MongoDB. Ja, mir ist das Lizenzmodell bekannt!

Da man das auch gut mit NodeBB einsetzen kann, ist es ja auch mal an der Zeit sich das anzuschauen

Eines meiner kleinen Python Projekte ist Portfolio, ein Tool um Aktien und seine Kurse zu verwalten. Also nichts besonderes. Ich speichere damit meine Aktienbestände und kann die aktuellen Kurswerte von einer Webseite abholen. Das alles speichere ich dann in der Redis DB.

Zuerst wollte ich das modular aufbauen, also mit Redis & MongoDB. Das war aber mit meinen Kenntnissen eine Nummer zu groß, so dass ich schnell entschied das nicht so zu machen. Ich habe das Projekt dann kopiert und Redis komplett entfernt und alles auf MongoDB umgebaut.

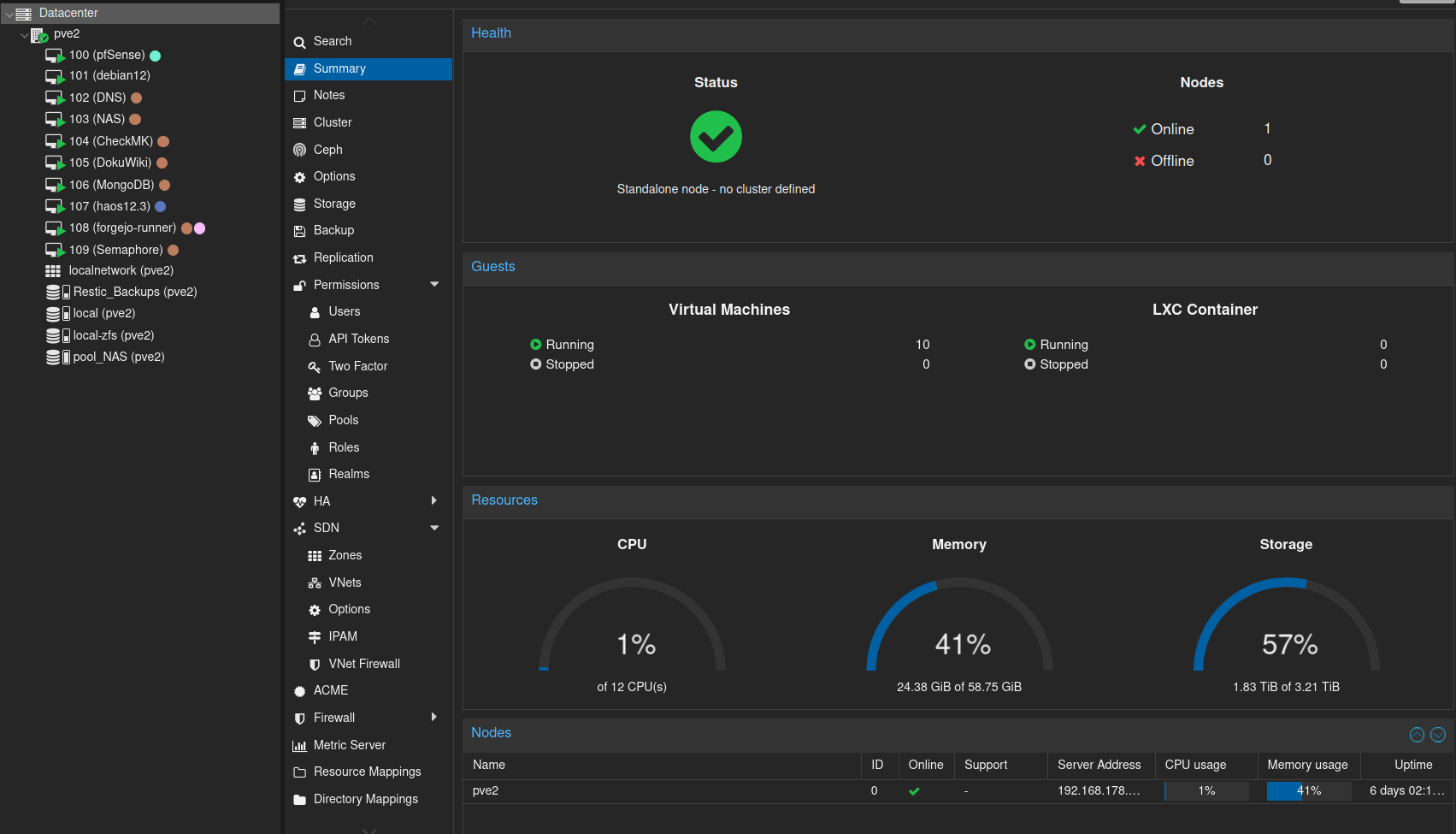

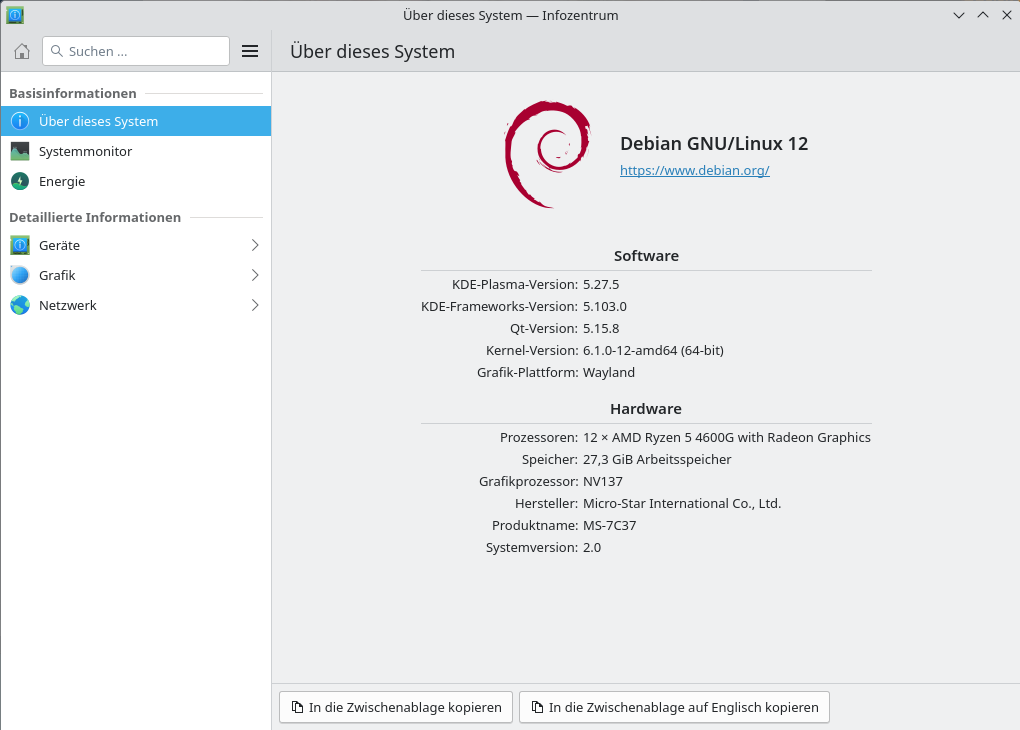

Da ich ja erst vor kurzem den Redis Server von einem Docker Dienst zu einer VM migriert hatte (Artikel), bot es sich an, den MongoDB Dienst auch dort laufen zu lassen.

Ok, nun mal an was Praktisches.

Installation

apt install mongodb-orgDanach kurz die ufw konfiguriert

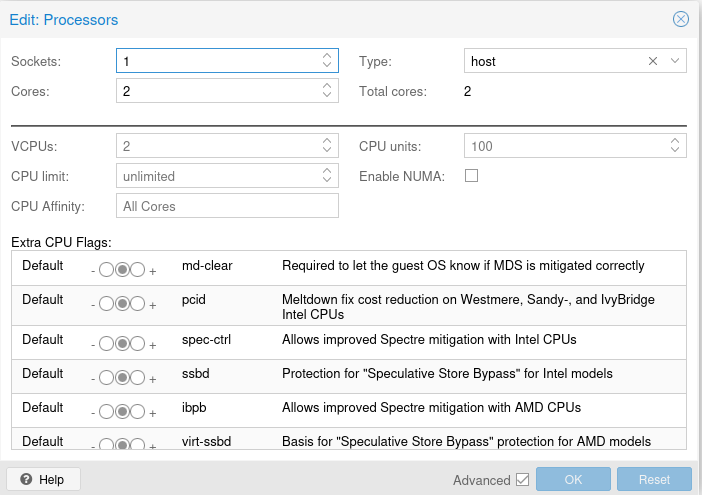

ufw allow mongod ufw allow 27017Mein erster Startversuch war kläglich gescheitert, weil irgendein CPU Protokoll nicht vorhanden war. Der Dienst läuft auf einem Proxmox. Erst nachdem ich den Type auf host eingestellt hatte lief es.

Konfiguration

MongoDB nutzt einen SystemD Dienst

root@redis-stack:~# systemctl status mongod ● mongod.service - MongoDB Database Server Loaded: loaded (/lib/systemd/system/mongod.service; enabled; vendor preset: enabled) Active: active (running) since Mon 2024-04-01 08:56:43 CEST; 1h 54min ago Docs: https://docs.mongodb.org/manual Main PID: 20919 (mongod) Memory: 224.4M CPU: 26.040s CGroup: /system.slice/mongod.service └─20919 /usr/bin/mongod --config /etc/mongod.confHier sieht man, welche Konfigurations Datei geladen wird.

/etc/mongod.conf

# mongod.conf # for documentation of all options, see: # http://docs.mongodb.org/manual/reference/configuration-options/ # Where and how to store data. storage: dbPath: /var/lib/mongodb # engine: # wiredTiger: # where to write logging data. systemLog: destination: file logAppend: true path: /var/log/mongodb/mongod.log # network interfaces net: port: 27017 bindIp: 192.168.3.9 # how the process runs processManagement: timeZoneInfo: /usr/share/zoneinfo #security: security.authorization: enabled #operationProfiling: #replication: #sharding: ## Enterprise-Only Options: #auditLog:Die IP ist von der VM auf meinem Proxmox. Ich hatte erst ohne User & Passwort alles in Python auf die MongoDB umgestellt, dazu kommt ein separater Beitrag. Heute Morgen dann beim Kaffee, das Thema Security

Ihr wisst ja, Foren sind heute nicht mehr so in, ChatGPT hilft einem doch dabei, oder?

Ihr wisst ja, Foren sind heute nicht mehr so in, ChatGPT hilft einem doch dabei, oder?Ich sollte das hier machen

- Login DB

- DB auswählen

- User anlegen

Login DB

Da ich ja die MongoDB nur auf die IP 192.168.3.9 lauschen lasse, kann ich mich auf dem Rechner lokal nicht anmelden. Also muss man das so machen.

mongosh --host 192.168.3.9Danach sieht man ein CLI

root@redis-stack:~# mongosh --host 192.168.3.9 Current Mongosh Log ID: 660a5d31a731e65bddc00e7d Connecting to: mongodb://<credentials>@192.168.3.9:27017/?directConnection=true&appName=mongosh+2.2.1 Using MongoDB: 7.0.7 Using Mongosh: 2.2.1 mongosh 2.2.2 is available for download: https://www.mongodb.com/try/download/shell For mongosh info see: https://docs.mongodb.com/mongodb-shell/ test>Hier kann man jetzt die administrativen Befehle absetzen.

DB auswählen

Einfach

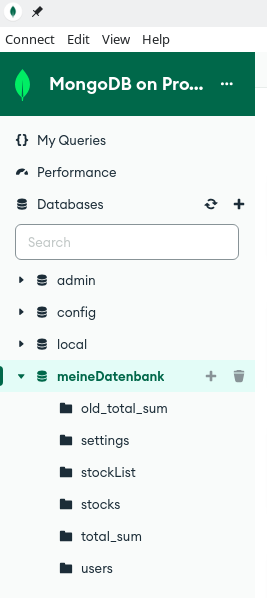

use adminInnerhalb der MongoDB gibt es mehrere vorkonfigurierten Datenbanken. Eine davon heißt admin

Der Screenshot ist von dem Programm MongoDB Compass, ein UI um die Datenbank zu verwalten usw.

admin, config und local sind voreingestellte Datenbanken, die bei der Installation automatisch angelegt werden.

User anlegen

Nun gab mir ChatGPT folgendes um den User anzulegen.

db.createUser({ user: "<name>", pwd: "<password>", roles: [ { role: "userAdminAnyDatabase", db: "admin" } ] })Danach in der Konfiguration das hier ergänzt

#security: security.authorization: enabledDann den Dienst neu starten

systemctl restart mongodIrgendwie klappte da aber gar nichts, erstes Problem sind Sonderzeichen im Passwort. DIe kann man auf Python Seite encoden und zwar so.

from urllib.parse import quote_plus encoded_password = quote_plus(MONGO_PASSWORD)Danach hatte ich irgendwann Zugang zur MongoDB, aber meine Datenbank war leer. Hilfe, alle meine Daten weg. Das wäre eine kleine Katastrophe. Ruhe bewahren

Nachdenken. Ok loggen wir uns mit dem User & Passwort mal ein.

root@redis-stack:~# mongosh -u <user> -p <password> --host 192.168.3.9Es kam folgendes

Current Mongosh Log ID: 660a5dab42ca150895c00e7d Connecting to: mongodb://<credentials>@192.168.3.9:27017/?directConnection=true&authSource=admin&appName=mongosh+2.2.1 Using MongoDB: 7.0.7 Using Mongosh: 2.2.1 mongosh 2.2.2 is available for download: https://www.mongodb.com/try/download/shell For mongosh info see: https://docs.mongodb.com/mongodb-shell/ test> use meineDatenbank switched to db meineDatenbank meineDatenbank> show collections MongoServerError[Unauthorized]: not authorized on meineDatenbank to execute command { listCollections: 1, filter: {}, cursor: {}, nameOnly: true, authorizedCollections: false, lsid: { id: UUID("e5a6716a-207c-4478-80de-xxxxxxxxxxxx") }, $db: "meineDatenbank" }Ich hatte also die DB ausgewählt

use meineDatenbank #dämlicher Nameund dann wollte ich mir Collections anzeigen lassen, weil vorher in meinem Python Projekt alles leer war.

show collections

Und dann kam der Fehler MongoServerError[Unauthorized] Ok, da stimmte was nicht mit den Zugriffsrechten nicht. ChatGPT meinte dann ganz trocken, ja wenn Du das möchtest musst Du auch die Rolle angeben. Jo, Fu.....

Also die Rechte angepasst.

admin> db.updateUser("frank", { ... roles: [ ... { role: "userAdminAnyDatabase", db: "admin" }, ... { role: "readWrite", db: "meineDatenbank" } ... ] ... }) { ok: 1 }Jetzt konnte ich auch die Datenbank lesen & schreiben

Und hier noch der Befehl um ein Passwort zu ändern.

db.updateUser("<USER>", { pwd: "<PASSWORD>" })Backup & Restore (ki-generiert)

Aktuell noch ungetestet, da ich aber finde das gehört hier irgendwie mit dazu habe ich das hier schon mal abgelegt.

To backup all databases

mongodump --uri="mongodb://username:password@localhost:27017" --out=/path/to/backupTo backup a specific database

mongodump --uri="mongodb://username:password@localhost:27017/databaseName" --out=/path/to/backupTo restore all databases from a backup directory:

mongorestore --uri="mongodb://username:password@localhost:27017" /path/to/backupTo restore a specific database:

mongorestore --uri="mongodb://username:password@localhost:27017" --nsInclude=databaseName.* /path/to/backup/databaseNameUnd wieder was gelernt...

-

So frisch von der MongoDB Front und wieder viel gelernt, weil beim Üben macht man Fehler

Oben war ja mongodump & mongorestore von der KI empfohlen. Hier das wie ich es gemacht habe.

mongodump

frank@redis-stack:~$ mongodump -u frank -p '<password>' --host 192.168.3.9 --authenticationDatabase admin -d portfolio -o mongodump/ 2024-04-06T09:29:25.174+0200 writing portfolio.stockList to mongodump/portfolio/stockList.bson 2024-04-06T09:29:25.175+0200 writing portfolio.users to mongodump/portfolio/users.bson 2024-04-06T09:29:25.175+0200 done dumping portfolio.stockList (8 documents) 2024-04-06T09:29:25.176+0200 writing portfolio.total_sum to mongodump/portfolio/total_sum.bson 2024-04-06T09:29:25.177+0200 done dumping portfolio.total_sum (1 document) 2024-04-06T09:29:25.177+0200 writing portfolio.old_total_sum to mongodump/portfolio/old_total_sum.bson 2024-04-06T09:29:25.177+0200 writing portfolio.stocks to mongodump/portfolio/stocks.bson 2024-04-06T09:29:25.177+0200 done dumping portfolio.users (4 documents) 2024-04-06T09:29:25.178+0200 writing portfolio.settings to mongodump/portfolio/settings.bson 2024-04-06T09:29:25.178+0200 done dumping portfolio.settings (1 document) 2024-04-06T09:29:25.179+0200 done dumping portfolio.old_total_sum (1 document) 2024-04-06T09:29:25.179+0200 done dumping portfolio.stocks (34 documents)mongorestore

mongorestore -u frank -p '<password>' --host 192.168.3.9 --authenticationDatabase admin -d portfolio mongodump/meineDatenbank/Hier wird die Datensicherung mongodump/meineDatenbank/ in die neue Datenbank portfolio transferiert.

Grund für das Ganze? Mich hatte der Datenbank Name meineDatenbank gestört.

Benutzerrechte

Jetzt der Teil wo man schnell was falsch machen kann

Ich hatte also die neue Datenbank, konnte sie aber nicht lesen. Fehlten halt die Rechte. Ich hatte dann so was hier gemacht.

Ich hatte also die neue Datenbank, konnte sie aber nicht lesen. Fehlten halt die Rechte. Ich hatte dann so was hier gemacht.db.updateUser("frank", { roles: [ { role: "readWrite", db: "meineDatenbank" }, { role: "readWrite", db: "portfolio" }]})Ging auch prima, kam ein ok zurück. Nun das Problem, ich hatte beim Einrichten, den User frank als admin benutzt. Durch den oben abgesetzten Befehl (frank ist ja admin), wurden die neuen Rechte gesetzt und die Rechte als Admin entzogen!! Das war jetzt nicht wirklich das was ich gebrauchen konnte. LOL

Ich hatte jetzt keine Kontrolle mehr über die DB. Das war aber nicht so wirklich kompliziert, das wieder zu ändern. Die Authentication temporär abstellen. Also /etc/mongod.conf editieren und

#security: security.authorization: enabledeben mal auskommentieren. Den Daemon neustarten und anmelden an der DB.

mongosh --host 192.168.3.9Danach neuen User anlegen

db.createUser({ user: "<name>", pwd: "<password>", roles: [ { role: "userAdminAnyDatabase", db: "admin" } ] })mongod.conf wieder ändern und neustarten. Danach hat man wieder eine DB mit Authentifizierung und einen neuen Admin. Ich bin diesmal, man lernt ja, anders vorgegangen. Es gibt nun einen Admin für die DB und einen User zum Benutzen der Datenbanken! So wie man es auch auf einem produktiven System auch machen würde. Wenn ich jetzt mal was an den Benutzerrechten des Users ändere, kann mir das mit dem Admin nicht mehr passieren. Hoffe ich

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen