Bitwarden_RS auf einem Debian Buster 10 Server installieren!

-

@hase567 Ich glaube Du verwechselst da was. Die Bitwarden_RS (vaultwarden) Version 1.24.0 ist aktuell und dani-garcia hat noch keine neue Version veröffentlicht. https://github.com/dani-garcia/vaultwarden/releases

Du meinst mit Version 2.28.0 das Original. Das wird dann vermutlich die Vorlage für das nächste Release vom dani-garcia.

Ich denke, da müssen wir uns noch etwas in Geduld üben.

-

Es gibt mal wieder ein Update - aber keine neue Version!

Was hat es damit auf sich?Das Paket "bitwarden-rs" ist jetzt nur noch ein Metapaket mit einer Abhängigkeit auf das neue Paket "vaultwarden". Beim nächsten Update ("apt update && apt upgrade") wird also Bitwarden_rs durch Vaultwarden ersetzt.

Die Konfiguration und das Datenverzeichnis werden dabei vollständig migriert.

Übrig bleiben lediglich die Verzeichnisse /etc/bitwarden_rs und /var/lib/bitwarden_rs, die nach erfolgreichem Test manuell gelöscht werden können.Neue Installationen (auch über das Paket "bitwarden-rs") installieren ab sofort immer Vaultwarden.

Die Ubuntu 22.04 Kompatibilität ist nicht gelöst und damit meine nächste Baustelle...

-

Es gibt mal wieder ein Update - aber keine neue Version!

Was hat es damit auf sich?Das Paket "bitwarden-rs" ist jetzt nur noch ein Metapaket mit einer Abhängigkeit auf das neue Paket "vaultwarden". Beim nächsten Update ("apt update && apt upgrade") wird also Bitwarden_rs durch Vaultwarden ersetzt.

Die Konfiguration und das Datenverzeichnis werden dabei vollständig migriert.

Übrig bleiben lediglich die Verzeichnisse /etc/bitwarden_rs und /var/lib/bitwarden_rs, die nach erfolgreichem Test manuell gelöscht werden können.Neue Installationen (auch über das Paket "bitwarden-rs") installieren ab sofort immer Vaultwarden.

Die Ubuntu 22.04 Kompatibilität ist nicht gelöst und damit meine nächste Baustelle...

@Nico sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

Es gibt mal wieder ein Update - aber keine neue Version!

Was hat es damit auf sich?Das Paket "bitwarden-rs" ist jetzt nur noch ein Metapaket mit einer Abhängigkeit auf das neue Paket "vaultwarden". Beim nächsten Update ("apt update && apt upgrade") wird also Bitwarden_rs durch Vaultwarden ersetzt.

Die Konfiguration und das Datenverzeichnis werden dabei vollständig migriert.

Übrig bleiben lediglich die Verzeichnisse /etc/bitwarden_rs und /var/lib/bitwarden_rs, die nach erfolgreichem Test manuell gelöscht werden können.Neue Installationen (auch über das Paket "bitwarden-rs") installieren ab sofort immer Vaultwarden.

Die Ubuntu 22.04 Kompatibilität ist nicht gelöst und damit meine nächste Baustelle...

Ich habe es dann eben mal ausprobiert und es lief einwandfrei. Danke dafür. Außerdem habe ich den Eingangsthread an Vaultwarden angepasst. Den Titel lass ich mal so, evt. bau ich da am WE was zu.

-

Die Version 1.25.0 ist ab sofort im Repository verfügbar!

Wurde die Migration von Bitwarden_rs zu Vaultwarden noch nicht mit Version 1.24 durchgeführt, kann es passieren, dass Vaultwarden 1.25 nicht startet.

Dieser Fehler kann durch Löschen der Datei "/etc/vaultwarden/Rocket.toml" behoben werden:rm /etc/vaultwarden/Rocket.tomlDie Rocket.toml wird nicht länger benötigt und kann gefahrlos entfernt werden.

Schönes Wochenende!

-

Die Version 1.25.0 ist ab sofort im Repository verfügbar!

Wurde die Migration von Bitwarden_rs zu Vaultwarden noch nicht mit Version 1.24 durchgeführt, kann es passieren, dass Vaultwarden 1.25 nicht startet.

Dieser Fehler kann durch Löschen der Datei "/etc/vaultwarden/Rocket.toml" behoben werden:rm /etc/vaultwarden/Rocket.tomlDie Rocket.toml wird nicht länger benötigt und kann gefahrlos entfernt werden.

Schönes Wochenende!

-

Hallo,

ich hatte eben einmal auf die neueste Version geupdatet und erhalte von meinem Reverseproxy den Fehler 500 und vom Vaultwarden Debian Server einen Server ist nicht erreichbar zurück.

Mein derzeitiges System ist ein Debian 11.3 mit Vaultwarden 1.24.0.

Wie gesagt nach dem Update bekomme ich keinen Seitenaufbau hin. Hat sich irgendetwas hinsichtlich des Webservers geändert? Ich habe auf dem Vaultwardenserver kein Nginx oder Apache laufen. Bisher hatte dies auch gut funktioniert.

Weiß langsam nicht mehr wo ich suchen soll. Vielleicht kann mir ja jemand helfen...

Grüße

jascha -

Hallo,

ich hatte eben einmal auf die neueste Version geupdatet und erhalte von meinem Reverseproxy den Fehler 500 und vom Vaultwarden Debian Server einen Server ist nicht erreichbar zurück.

Mein derzeitiges System ist ein Debian 11.3 mit Vaultwarden 1.24.0.

Wie gesagt nach dem Update bekomme ich keinen Seitenaufbau hin. Hat sich irgendetwas hinsichtlich des Webservers geändert? Ich habe auf dem Vaultwardenserver kein Nginx oder Apache laufen. Bisher hatte dies auch gut funktioniert.

Weiß langsam nicht mehr wo ich suchen soll. Vielleicht kann mir ja jemand helfen...

Grüße

jascha@skyacer Moin Jascha,

sorry für die späte Rückmeldung. Existiert das Problem noch?Wenn ja, poste doch bitte einmal den Output der folgenden Befehle:

ls -lha /etc/vaultwarden ps aux | grep warden netstat -tulpen | grep warden systemctl status vaultwarden.serviceDanke und beste Grüße!

-

Vaultwarden ist auf Version 1.25.2 aktualisiert. Danke @Nico

vaultwarden -v vaultwarden 1.25.2Release 1.25.2 · dani-garcia/vaultwarden

Unofficial Bitwarden compatible server written in Rust, formerly known as bitwarden_rs - Release 1.25.2 · dani-garcia/vaultwarden

GitHub (github.com)

-

Moin,

seit dem letzten Update hatte ich enorm viele Fehlermeldungen in den Logs. Nach etwas Recherche habe einen Hinweis gefunden.In der Nginx Vhost habe ich einen Eintrag hinzugefügt und somit waren die Fehlermeldungen verschwunden.

proxy_http_version 1.1;

Leider bin ich nicht der große Profi, vielleicht kann Nico oder jemand anderes das ganze mal anpassen!?

-

Moin,

seit dem letzten Update hatte ich enorm viele Fehlermeldungen in den Logs. Nach etwas Recherche habe einen Hinweis gefunden.In der Nginx Vhost habe ich einen Eintrag hinzugefügt und somit waren die Fehlermeldungen verschwunden.

proxy_http_version 1.1;

Leider bin ich nicht der große Profi, vielleicht kann Nico oder jemand anderes das ganze mal anpassen!?

-

@hase567 Moin,

wie lautete denn die Fehlermeldung? Kannst du die bitte mal posten?

Gab es dadurch auch funktionelle Einschränkungen oder bist du lediglich über das Log darauf gestoßen?

Beste Grüße und ein schönes Wochenende!

Nico -

@Nico

es gab keine funktionellen Einschränkungen, bin nur über die Logfiles drauf gestoßen.

Leider ist das Logfile nicht mehr vorhanden

Kann mich nur dran erinnern, das fast bei jedem Zugriff der Fehler aufgeführt wurde... -

Die letzten Wochen etwas viel mit Python & PyWebIO beschäftigt, fast vergessen das hier zu erwähnen.

Vaultwarden ist auf Version 1.26.0 aktualisiert. Danke @Nico

Release 1.26.0 · dani-garcia/vaultwarden

Unofficial Bitwarden compatible server written in Rust, formerly known as bitwarden_rs - Release 1.26.0 · dani-garcia/vaultwarden

GitHub (github.com)

:~# vaultwarden -v vaultwarden 1.26.0 -

Release 1.27.0 · dani-garcia/vaultwarden

Unofficial Bitwarden compatible server written in Rust, formerly known as bitwarden_rs - Release 1.27.0 · dani-garcia/vaultwarden

GitHub (github.com)

@Nico fleißig

root@:~# vaultwarden -v vaultwarden 1.27.0 -

Release 1.28.0 · dani-garcia/vaultwarden

Unofficial Bitwarden compatible server written in Rust, formerly known as bitwarden_rs - Release 1.28.0 · dani-garcia/vaultwarden

GitHub (github.com)

Danke @Nico

root :~# vaultwarden -v vaultwarden 1.28.0 -

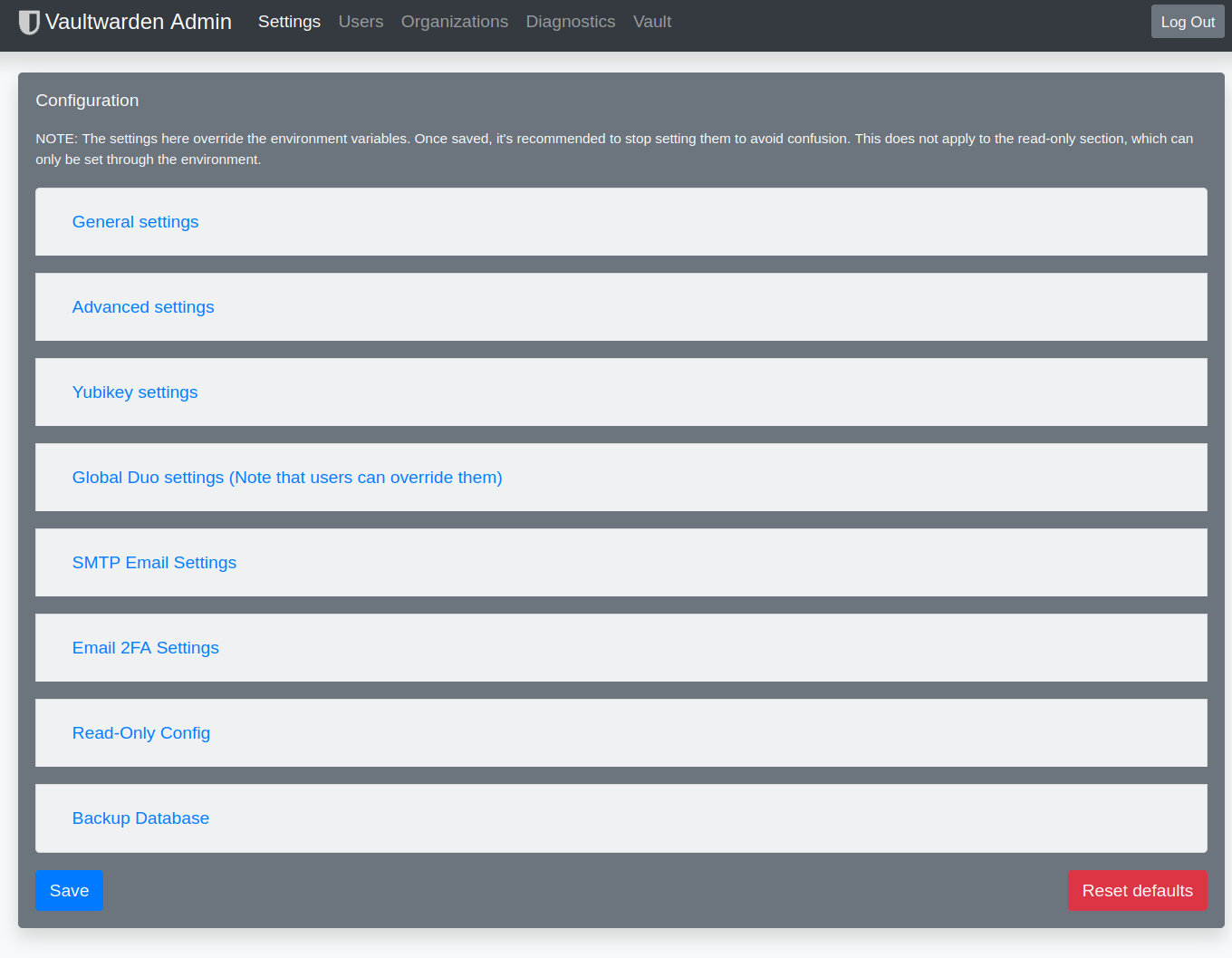

Ich hatte heute im Admininterface mal reingeschaut. Da stand die Version noch auf 1.27 und nicht auf 1.28. Ok, kein Problem, einmal neustarten und gut.

systemctl restart vaultwardenOk, danach startete er nicht mehr! Gar nicht!

Der Fehler

Mar 31 22:31:35 bitwarden vaultwarden[1614]: Error loading config: Mar 31 22:31:35 bitwarden vaultwarden[1614]: Unable to write to log file. /var/log/vaultwarden/vaultwarden.logEs hat erst etwas gedauert, bis mich @Nico auf die Idee brachte das Logging, welches ich umgebogen hatte, wieder auf syslog zu stellen.

Ich nutze normalerweise folgendes

LOG_FILE=/var/log/vaultwarden/vaultwarden.log USE_SYSLOG=falseOk, dann mal geändert. Danach startete Vaultwarden wieder.

Das sieht nach einem Bug aus, weil egal was man an Benutzerrechten einstellt er schreibt nicht in das Logfile. Aktuell denke ich, es ist ein

Update: Lösung -> https://linux-nerds.org/topic/1373/vaultwarden-systemd