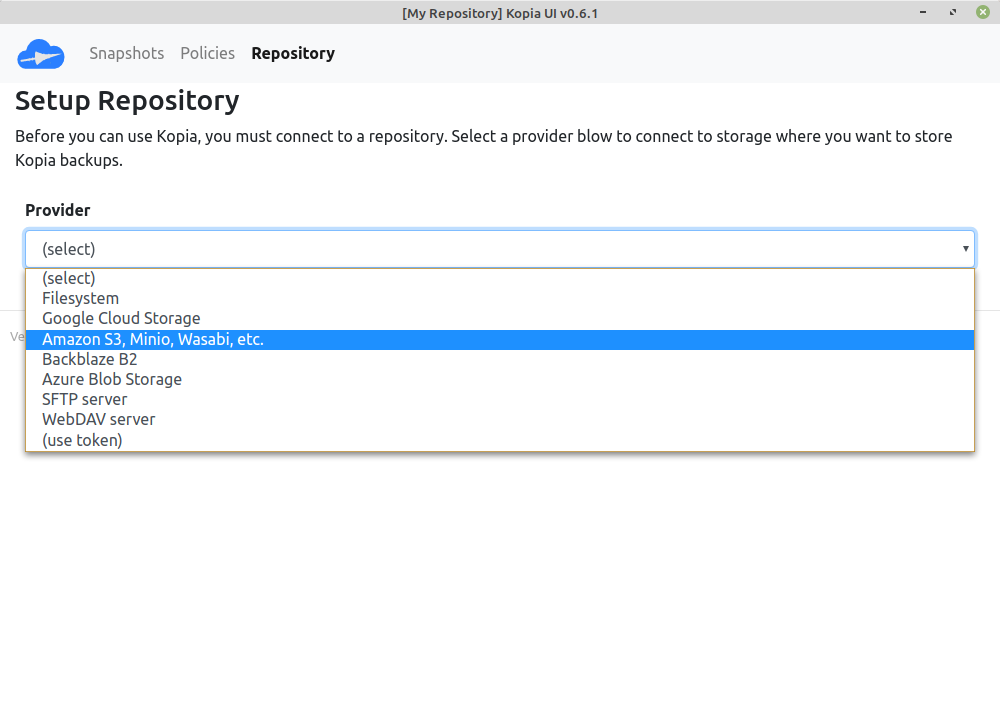

Kopia - Policies

Kopia

1

Beiträge

1

Kommentatoren

331

Aufrufe

-

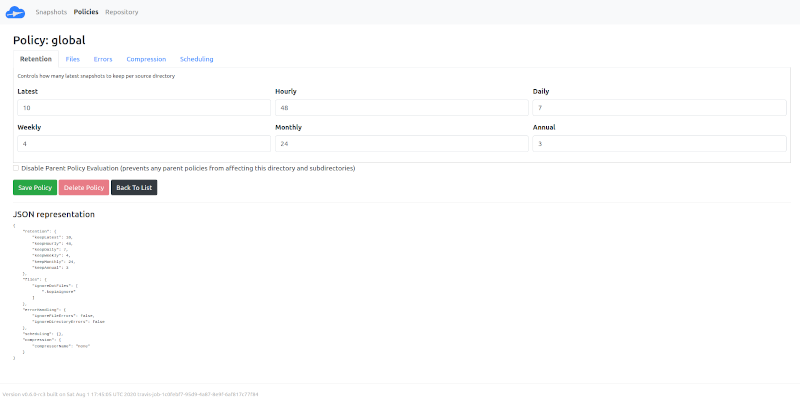

Mit den Policies kann man einstellen, welche Backups wie lange vorgehalten werden sollen. Hier mal die Standard Einstellungen von Kopia.

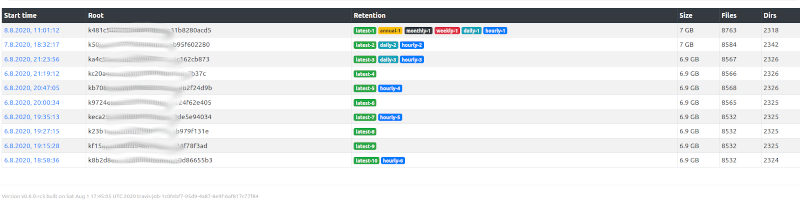

Es werden die letzten 10 Backups behalten (latest-10). Wie praktisch, die habe ich voll, dann kann man mal testen.

Man kann sehen, das ich die letzten 10 voll habe. Dann mal ein Backup angestoßen. Danach kommt das hier.

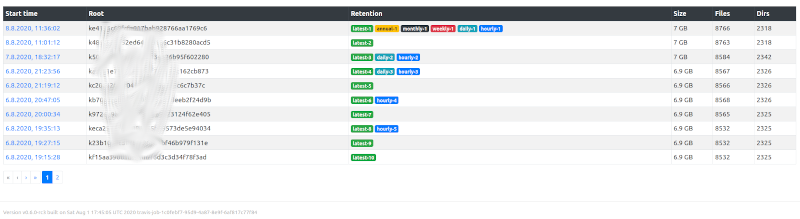

Wir haben wieder nur die letzten 10 Backups, aber es ist eine zweite Seite aufgetaucht.

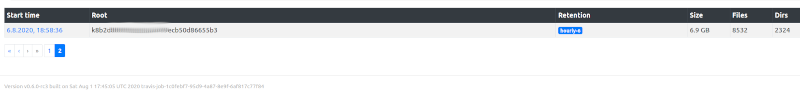

Da das 10. Backup noch in die Regel hourly-48 passt, ist es als hourly-6 behalten worden.