Bitwarden_RS auf einem Debian Buster 10 Server installieren!

-

@hase567 Danke, der Link war informativ und ich denke ich bekomme das auch damit hin, wenn da nicht die Zeit wäre. So was mache ich selten, mal eben nebenbei. Somit brauche ich da mal eine ruhige Stunde für. Ausprobieren möchte ich das auf alle Fälle, da alle meine anderen Server NGINX benutzen.

-

@hase567 Ok, hast mich überredet

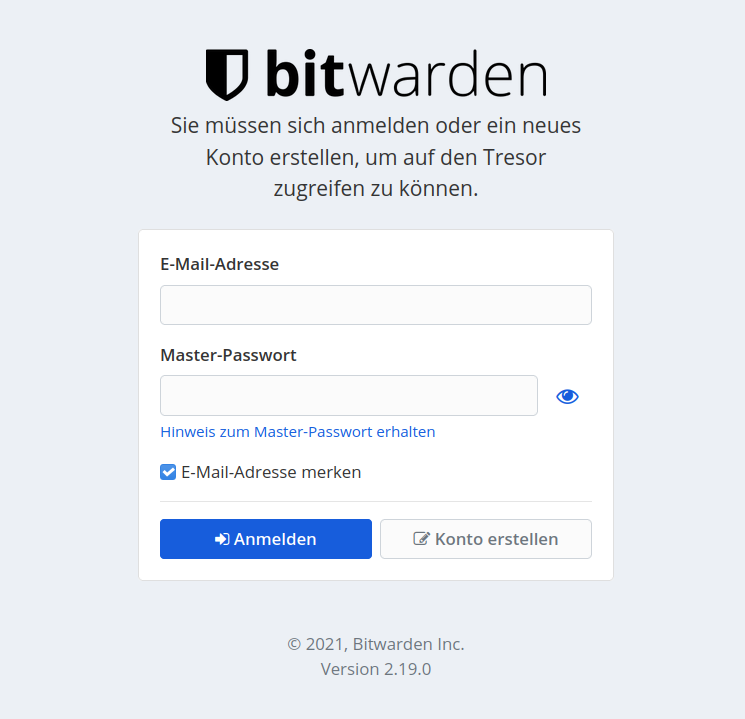

Kurzer Test.

Kurzer Test.service apache2 stopDanach NGINX installiert

apt install nginxKonfiguration unter

/etc/nginx/sites-enabled/defaulteingetragen. Folgt noch, muss noch was anpassen.

service nginx restartUnd, läuft so weit ich das auf die Schnelle sehen kann, wie unter Apache2.

Ich werde das in der Anleitung s.o. später hinzufügen. Dann können sich Interessierte aussuchen, was sie nutzen möchten.

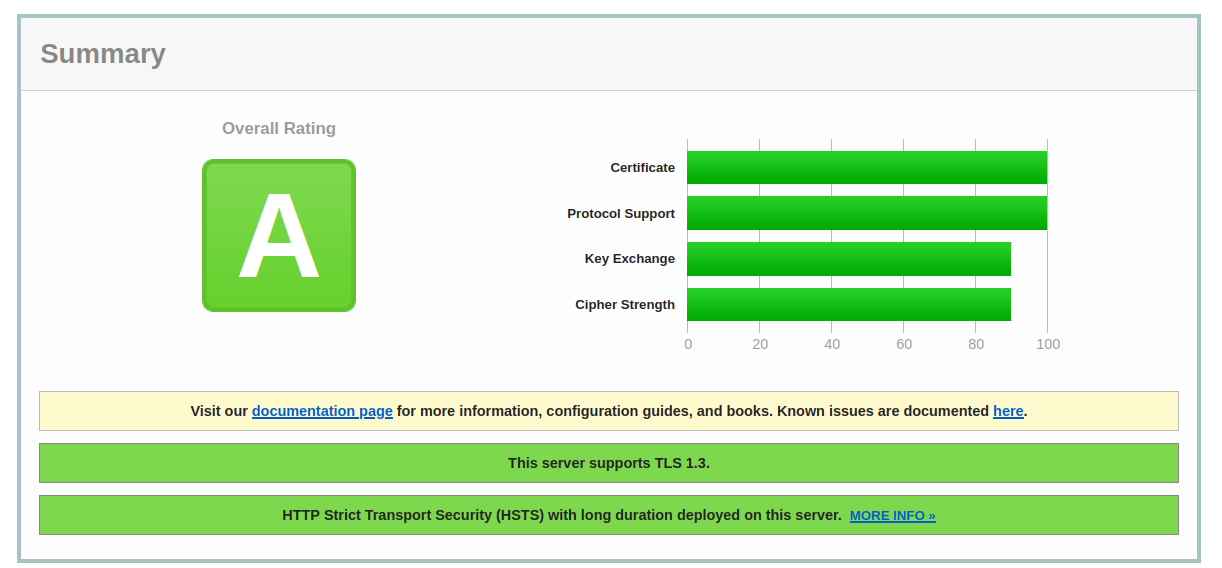

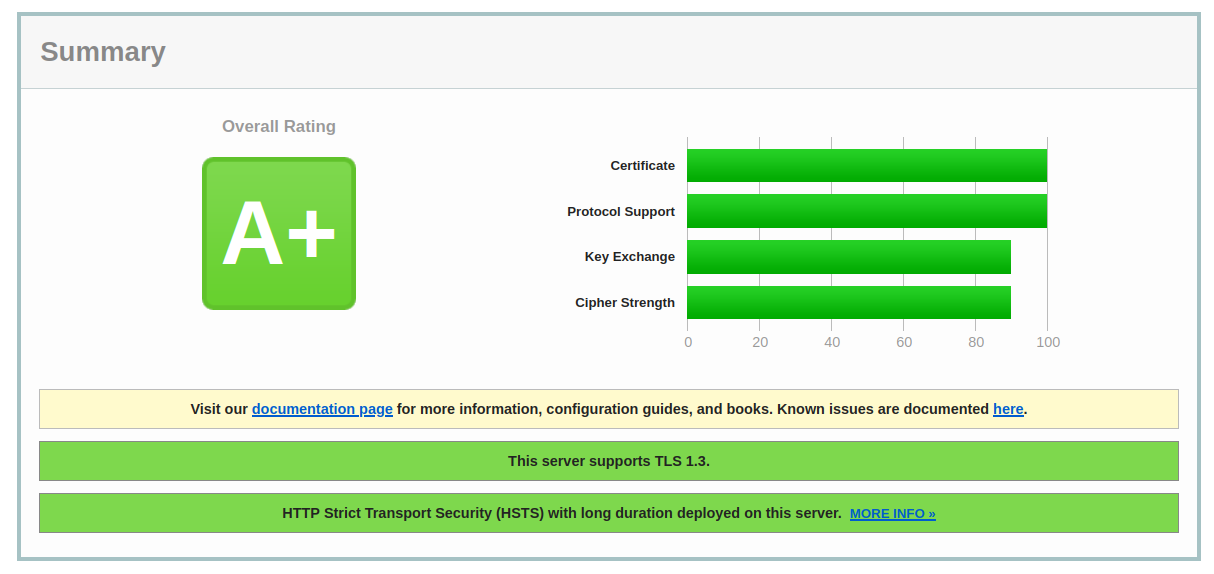

Und jetzt habe ich zusätzlich ein +

-

-

Hi,

das ist doch Super. Hatte mich auch gewundert das es doch recht Simpel ist.

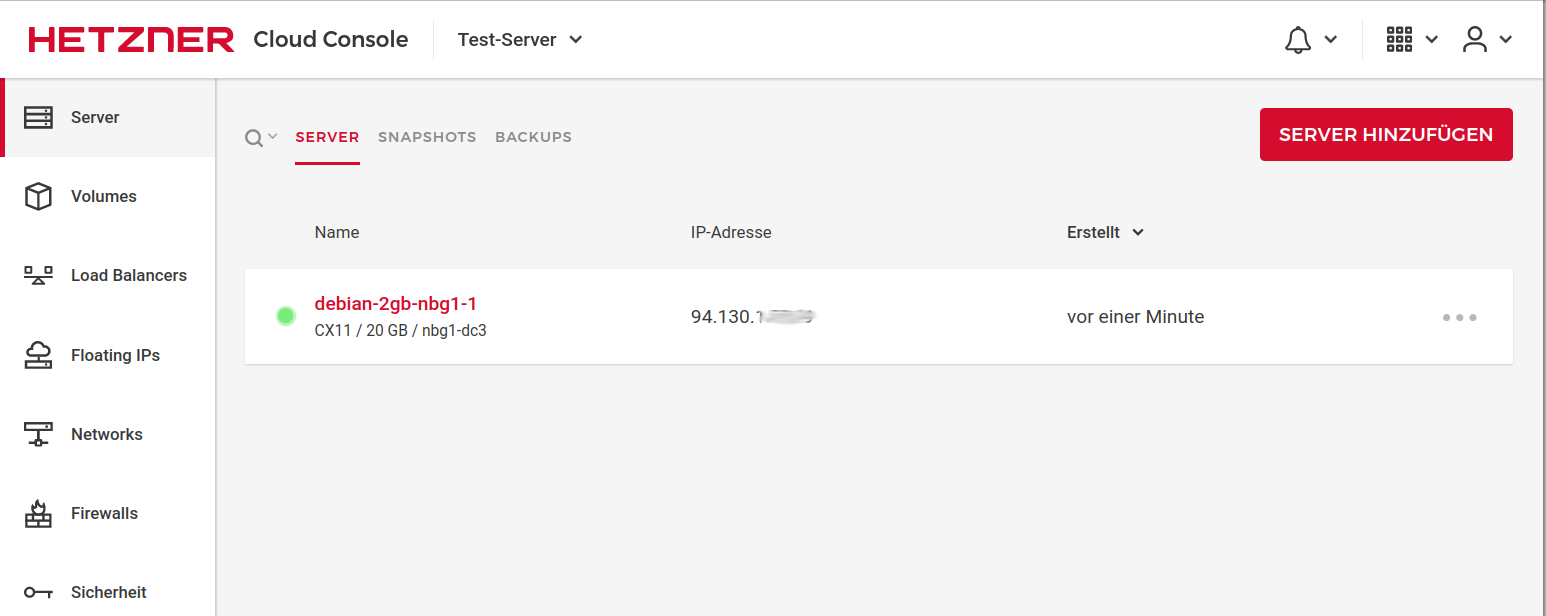

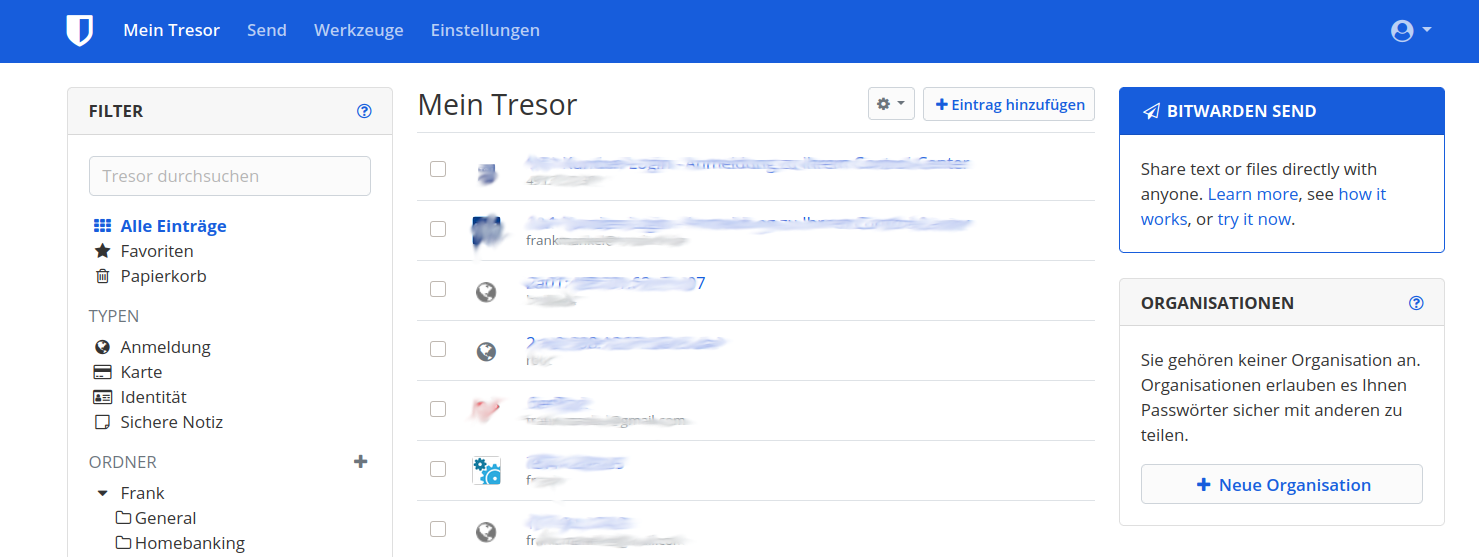

Bei mir läuft es aktuell noch auf einem Testserver, ohne irgendwelche Fehler weder seitens nginx noch von Bitwarden.

Werde wohl komplett auf ein Livesystem umstellen.

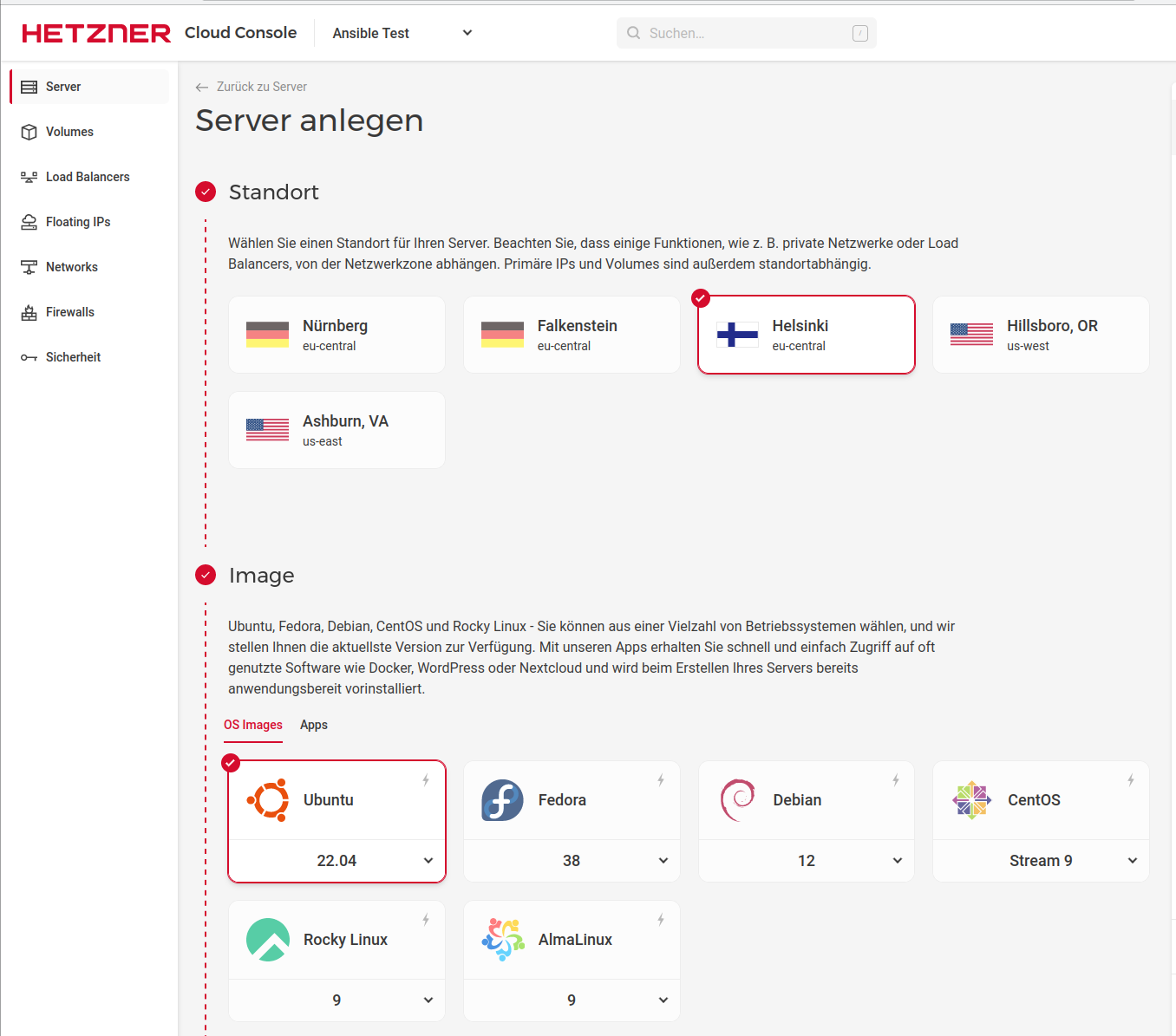

@hase567 Darf ich hier eigentlich nicht so schreiben, aber ich teste sehr viel direkt auf meinen Servern. Für Fälle wo es mal richtig schief geht, habe ich bei Hetzner ja noch etliche Backups der letzten paar Tage. Und Datensicherung usw. ist sowieso vorhanden.

Und mal eben NGINX neben dem Apache2 zu testen ist ja auch nicht wirklich Hexerei. Wobei ich den Apachen wesentlich anstrengender finde. Aber, das könnte eine sehr subjektive Meinung sein. Darum freut es mich, wenn wir oben im Thread beide Varianten drin haben. Ich baue das morgen ein.

-

Hallo,

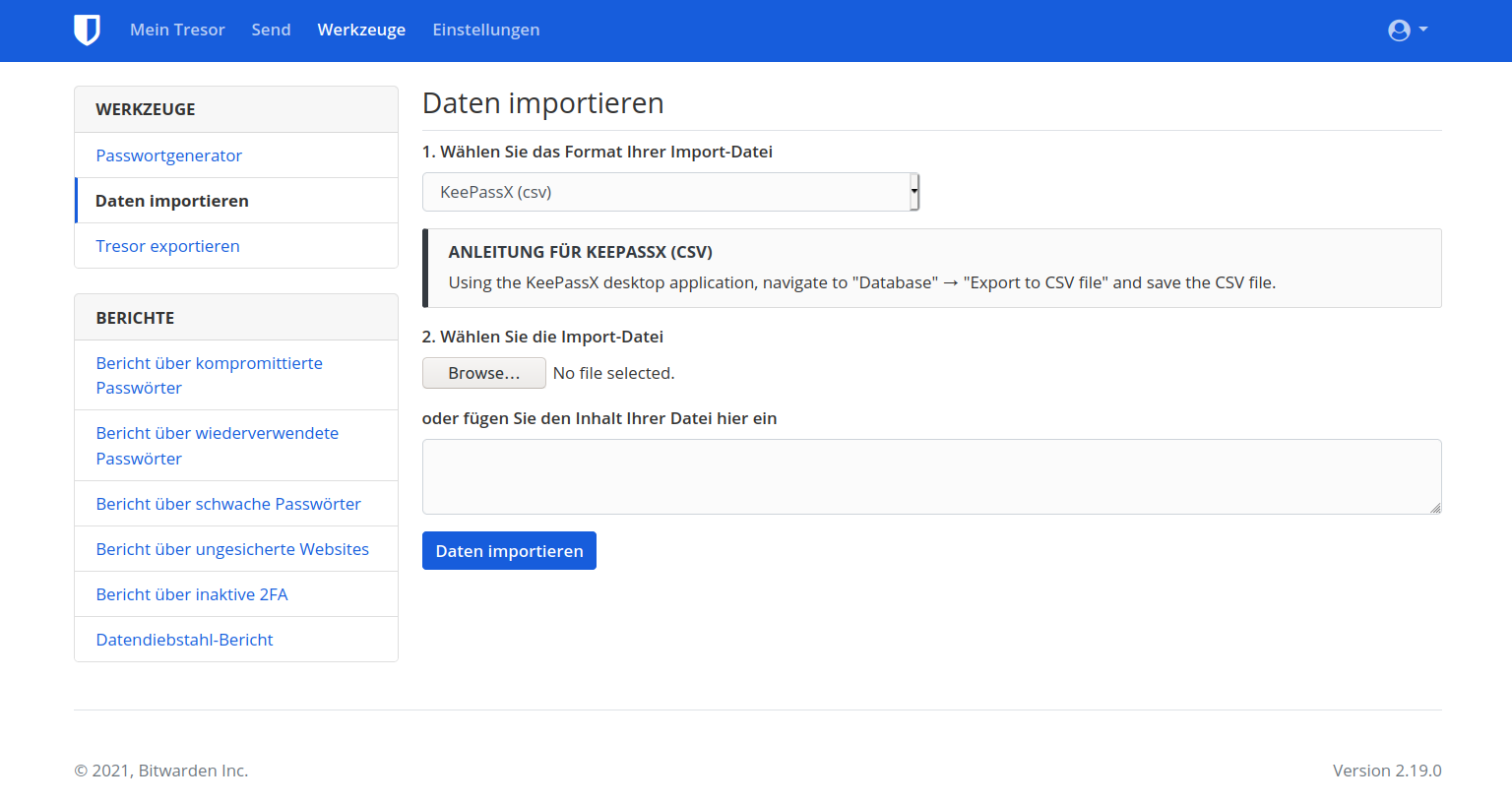

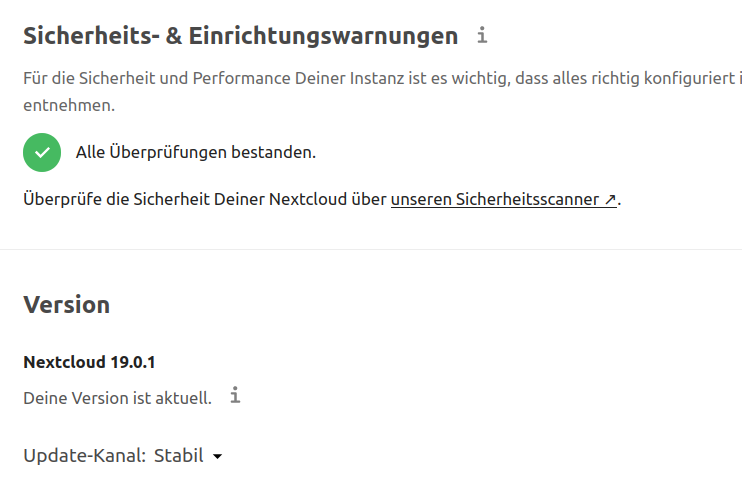

ich habe es nun auch geschafft das Repository auf die aktuelle Version von (nun) Vaultwarden zu aktualisieren. Das Paket und die Binary heißen aber noch "bitwarden_rs". Die Transition auf den neuen Namen habe ich (zumindest für dieses Release) verschoben.

Zusätzlich habe ich die Installationsanleitung von @FrankM im Repository verlinkt. Danke für den schönen Beitrag.

Ebenfalls Danke für die nginx Snippets. Ich bin ein Apache-Kind, aber werde bei Gelegenheit die ordnungsgemäße Funktion verifizieren und die nginx Konfiguration dann auch ergänzen.Beste Grüße

Nico -

Hallo,

ich habe es nun auch geschafft das Repository auf die aktuelle Version von (nun) Vaultwarden zu aktualisieren. Das Paket und die Binary heißen aber noch "bitwarden_rs". Die Transition auf den neuen Namen habe ich (zumindest für dieses Release) verschoben.

Zusätzlich habe ich die Installationsanleitung von @FrankM im Repository verlinkt. Danke für den schönen Beitrag.

Ebenfalls Danke für die nginx Snippets. Ich bin ein Apache-Kind, aber werde bei Gelegenheit die ordnungsgemäße Funktion verifizieren und die nginx Konfiguration dann auch ergänzen.Beste Grüße

Nico@nico Danke für die Infos!

Ich hab mal getestet

root@:~# service bitwarden_rs restart Warning: The unit file, source configuration file or drop-ins of bitwarden_rs.service changed on disk. Run 'systemctl daemon-reload' to reload units. root@:~# systemctl daemon-reload root@:~# service bitwarden_rs restart

Passt

-

Hi,

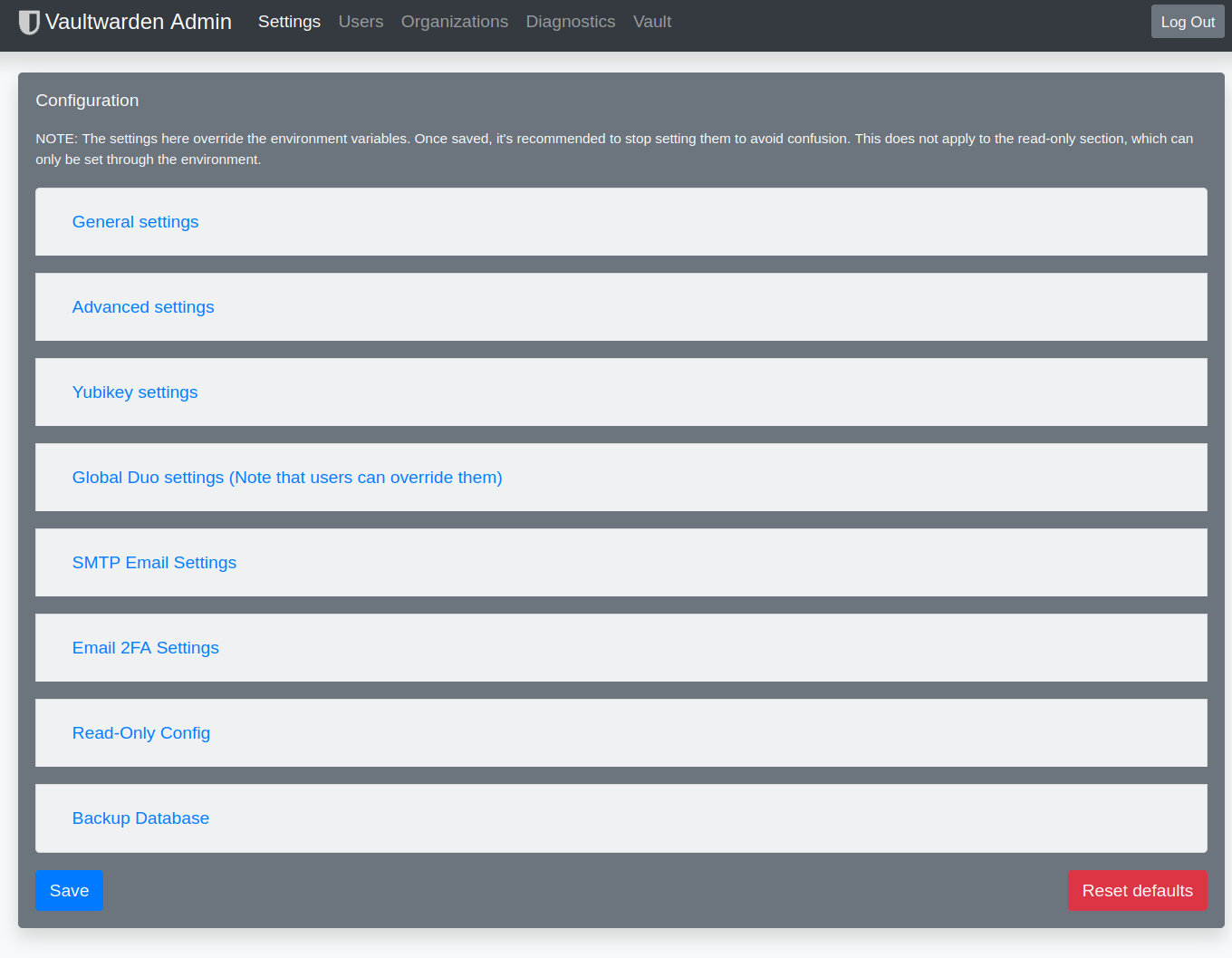

bitte achtet darauf, das die neue .env Datei weitere/neue Zeilen enthält bzgl. der Purge Cronjobs des "Send" Systems. Die Einträge dazu sind auch im Adminbereich einsehbar.Andi

@hase567 Danke für den Hinweis.

Da ich gestern vom Nico gefragt wurde, ob die Websockets unter NGINX gehen, habe ich das gestern ausprobiert. Ging nicht. Heute dann mal auf die Suche gegangen und festgestellt, das die in der Konfigurationsdatei nicht aktiv waren.

Also eingeschaltet und ausprobiert. Einen neuen Eintrag erstellt und geschaut, ob der ohne Neuladen, sofort angezeigt wird. Das passiert bei mir jetzt so.

Ich hoffe das stimmt jetzt so alles...

## Enables websocket notifications WEBSOCKET_ENABLED=true ## Controls the WebSocket server address and port WEBSOCKET_ADDRESS=0.0.0.0 WEBSOCKET_PORT=3012 -

@hase567 Danke für den Hinweis.

Da ich gestern vom Nico gefragt wurde, ob die Websockets unter NGINX gehen, habe ich das gestern ausprobiert. Ging nicht. Heute dann mal auf die Suche gegangen und festgestellt, das die in der Konfigurationsdatei nicht aktiv waren.

Also eingeschaltet und ausprobiert. Einen neuen Eintrag erstellt und geschaut, ob der ohne Neuladen, sofort angezeigt wird. Das passiert bei mir jetzt so.

Ich hoffe das stimmt jetzt so alles...

## Enables websocket notifications WEBSOCKET_ENABLED=true ## Controls the WebSocket server address and port WEBSOCKET_ADDRESS=0.0.0.0 WEBSOCKET_PORT=3012 -

@frankm Setz die "WEBSOCKET_ADDRESS" auf 127.0.0.1. Der Port muss/sollte nicht ohne Reverse Proxy erreichbar sein.

@nico Done.

Ging erst nicht, was man so alles vergisst, der Port muss ja auch mal zugänglich sein.

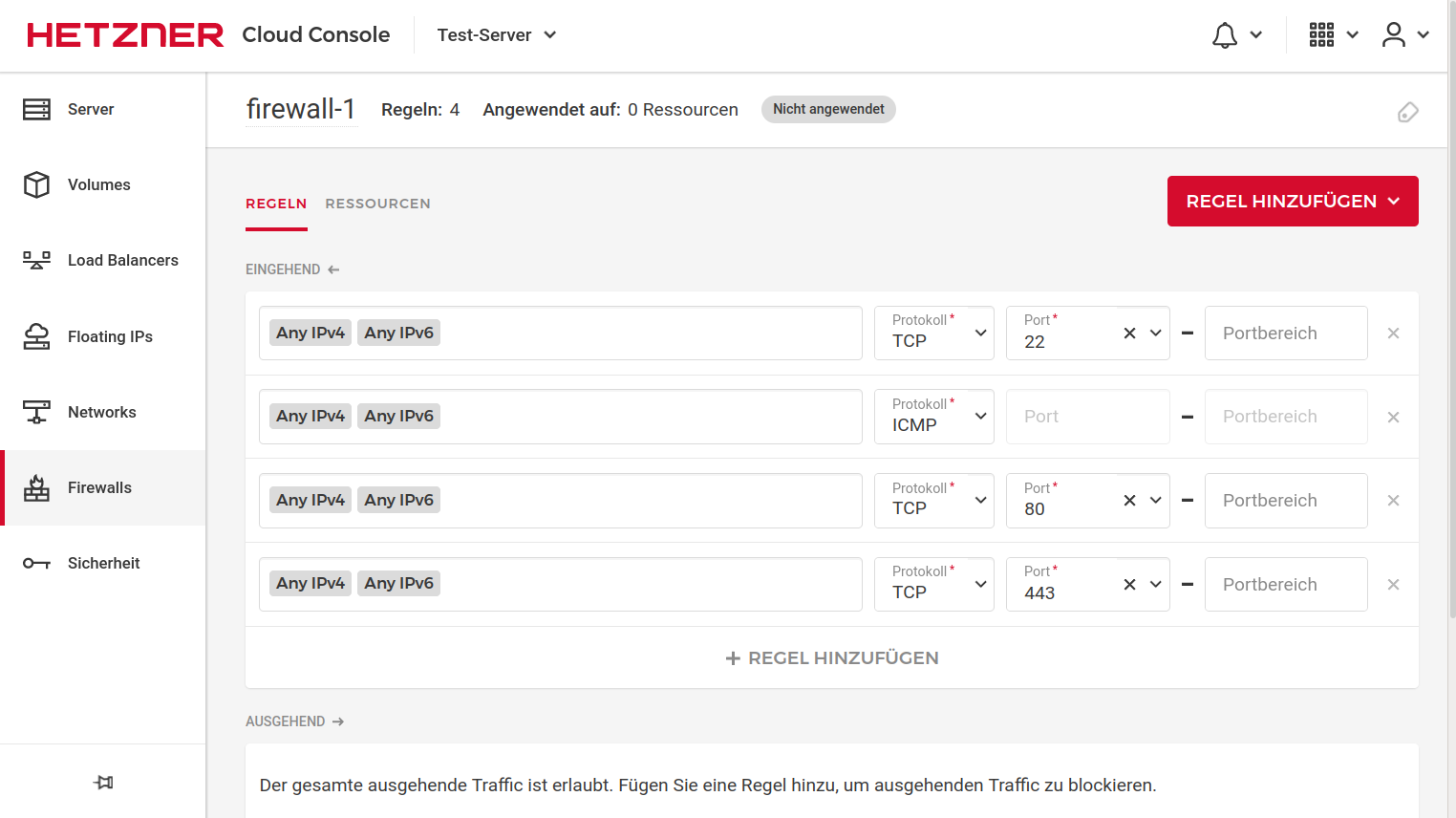

Also, das was ich heute dann noch optimiert habe. Für Websocket die Config entsprechend anpassen. Den Port in der Firewall freigeben.

Das Logging wollte ich noch umbiegen, es hat lange gedauert, bis ich den Grund gefunden hatte warum es nicht geht.

/lib/systemd/system/bitwarden_rs.serviceDer Dienst muss leicht angepasst werden

ReadWriteDirectories=/var/lib/bitwarden_rs /var/log/bitwardenDann geht es auch mit dem Logging in diese Datei.

-

@hase567 Ich habe zu danken. Durch deinen sehr nützlichen Link

Bitwarden: How to setup a self-hosted password manager using Vaultwarden | Pieter Hollander

NB: This post hasn’t been updated since May 2021, as I nowadays don’t use this approach anymore. However, it can still be useful as a reference, although version numbers and configuration settings may have changed.

Pieter Hollander (pieterhollander.nl)

konnte ich jetzt die Fail2Ban Erkennung noch mit einbauen, das Logging läuft jetzt auch separat. Tolle Seite vom Pieter. Hab mich da mal bedankt.

-

F FrankM hat dieses Thema am angepinnt

F FrankM hat dieses Thema am angepinnt

-

Hi zusammen,

ich wollte nun mal auf einen Debian Server die Installation auf einem Apache durchführen.

Bei der Einrichtung mit:

apt-key adv --keyserver keys.gnupg.net --recv-keys 24BFF712

erscheint folgende Fehlermeldung:

Executing: /tmp/apt-key-gpghome.adhmhBrwoR/gpg.1.sh --keyserver keys.gnupg.net --recv-keys 24BFF712

gpg: Empfangen vom Schlüsselserver fehlgeschlagen: Kein NameHabt Ihr eine Idee?

-

Hi zusammen,

ich wollte nun mal auf einen Debian Server die Installation auf einem Apache durchführen.

Bei der Einrichtung mit:

apt-key adv --keyserver keys.gnupg.net --recv-keys 24BFF712

erscheint folgende Fehlermeldung:

Executing: /tmp/apt-key-gpghome.adhmhBrwoR/gpg.1.sh --keyserver keys.gnupg.net --recv-keys 24BFF712

gpg: Empfangen vom Schlüsselserver fehlgeschlagen: Kein NameHabt Ihr eine Idee?

-

-

@frankm sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

@Nico ist über das Problem informiert und arbeitet an einer Lösung.

Das hört sich gut an

@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

Hallo, Super Anleitung!

Haben das Vaultwarden auch im Einsatz, hab das Debian Paket aber bisher mit https://github.com/greizgh/vaultwarden-debian gebaut... ging auch ok, würde aber gern das Repository verwenden..

Nur hab ich bei mir schon alles auf den neuen Namen Vaultwarden geändert, und will das natürlich ungern zurückbauen... - gibts da einen Plan wann das umgestellt wird in dem Repository? Oder vielleicht zwischenzeitlich beides im Repo anbieten?

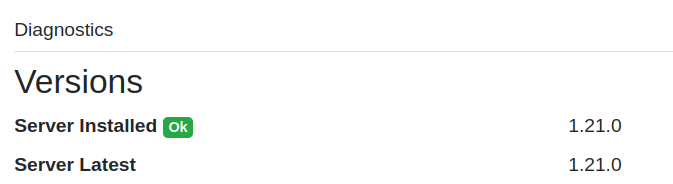

Und neue Version vom Vaultwarden is raus, 1.23 .. hab die mal mit dem Vaultwarden-Debian gebaut, da scheint es jedoch ein Problem zu geben, wenn ich es installier komm ich nicht mehr auf die Weboberfläche, Service rennt aber... da müsste ich schauen was da ist, würde mir das aber gerne ersparen wenns eh ein Repository gibt -

hoffe also auf eine 1.23 im Repo und auch bald auf eine direkte bullseye Repo Option

Lg, Flo