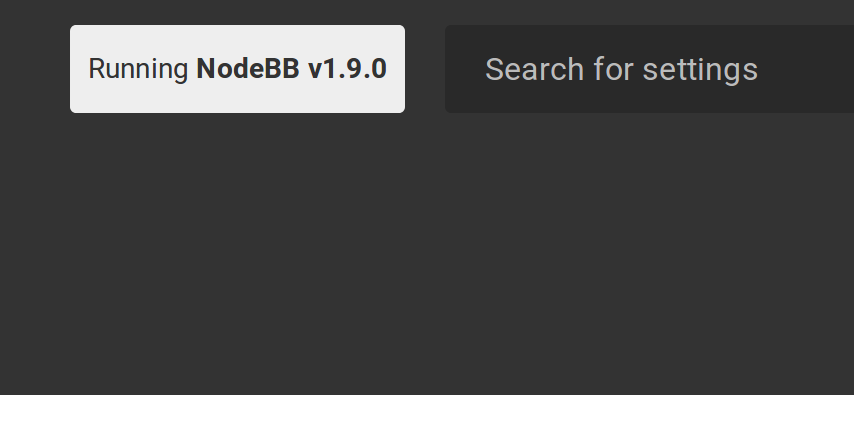

NodeBB - Upgrade auf v1.9.0

-

Datensicherung nicht vergessen!

Praxistipp: Es hat sich jetzt bei meiner mittlerweilen sehr langen Nutzung von NodeBB herausgestellt, das es sinnvoll sein kann, den Installationsordner vorher zu kopieren, damit man problemlos zum alten Stand zurück kann! (Update: 01.11.2021)

In das Installationsverzeichnis wechseln. Dran denken, mit dem richtigen User! (Ich habe da mal was durcheinander gewürfelt)

./nodebb stop Stopping NodeBB. Goodbye!Jetzt ist ein guter Zeitpunkt um alle seine Daten zu sichern. Ich gehe hier jetzt nicht drauf ein!

Dann

git fetchDanach dann folgendes

git checkout v1.8.x Already on 'v1.8.x' Your branch is up-to-date with 'origin/v1.8.x'.Ok, auf dieser Version sind wir. Das bringt so nichts. Also ...

git checkout v1.9.x Branch v1.9.x set up to track remote branch v1.9.x from origin. Switched to a new branch 'v1.9.x'Damit sind wir jetzt auf dem Zweig 1.9.x

./nodebb upgrade Updating NodeBB... 1. Updating package.json file with defaults... OK 2. Bringing base dependencies up to date... started added 20 packages and updated 4 packages in 6.407s 3. Checking installed plugins for updates... OK 4. Updating NodeBB data store schema... Parsing upgrade scripts... OK | 2 script(s) found, 51 skipped → [2018/2/28] Give registered users signature privilege... OK → [2018/4/16] Refresh post-upload associations... OK Schema update complete! 5. Rebuilding assets... started 2018-05-03T14:55:01.217Z [1638] - info: [build] Building in parallel mode 2018-05-03T14:55:01.219Z [1638] - info: [build] plugin static dirs build started . . . (gekürzt) NodeBB Upgrade Complete!Danach ein

./nodebb startund ich bin auf v1.9.0

Update

Nach dem Update ist bei mir immer noch ein Rebuild & Restart im Backend nötig, sonst fehlen mir immer die Karten (Recent Cards). Danach läuft dann alles

P.S.: Ich bin nicht so der git König, falls jemand mit Ahnung hier Fehler oder Unsinn sieht, bitte ich um einen kurzen Hinweis. Vielen Dank!

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat dieses Thema am abgepinnt

F FrankM hat dieses Thema am abgepinnt