Logger

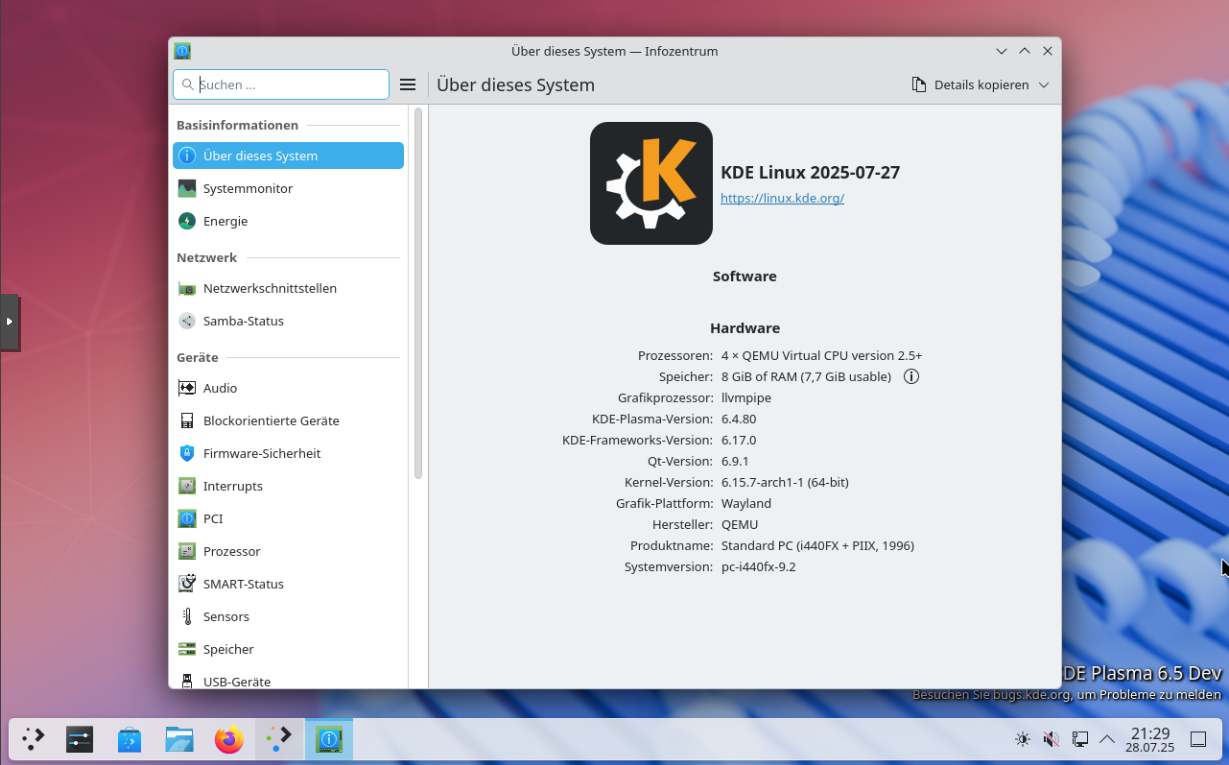

Linux

1

Beiträge

1

Kommentatoren

442

Aufrufe

-

In Scripten braucht man ja öfter mal Erfolgsmeldungen, oder auch das Gegenteil. Eine einfache Möglichkeit was in die Datei syslog einzutragen findet Ihr hier.

#Init DATE=`date +%d.%m.%Y_%H:%M` #NAS sichern #Ergebnis loggen if [ $? -eq 0 ] then logger Restic-Backup Script erfolgreich! $DATE else logger Restic-Backup Script ***nicht erfolgreich***! $DATE fi

-

-

-

-

-

-

-

Docker & Redis Datenbank

Verschoben Linux -