Proxmox - Umzug auf neue Hardware ASRock N100DC-ITX

-

Erstmal danke für das Willkommen und für die schnelle Antwort.

Die Geräusche hört man wenn man nicht weiter als ca. 25cm über dem MB ist.

Eventuell sind die Geräusche nicht zu hören wenn man mehr Verbraucher dran hat.

Du hast ja wahrscheinlich noch weitere Festplatten verbaut.

Mal sehen ob ich da mal was anschließen kann um zu hören ob sich dann noch was verändert.Zur Temperatur habe ich das mal im Desktop Modus beobachtet da wird die CPU maximal 65C° warm und im durchschritt läuft die bei ca. 50 C°.

Beim abspielen eines Videos 320x240 erreicht die CPU max. 77 C° und im Durchschnitt 65 C°.

Aber bei den Temperaturen heizt sich die SSD leider auch mit auf, ca. 64 C°.

Wenn man die Leistungsbewertung nochmal laufen lässt " Winsat formal" kommt die CPU auf 79C°.Die M.2 SSD sitzt etwas zu nahe an der CPU/Kühlkörper.

Gruß

Bernd -

Ich habe im BIOS noch ein Stromsparfunktion für die PCIe-Karte gefunden. Jetzt hab ich im Idle so zwischen 18 - 20W

Bei dem anderen NAS hatte ich um die 13W im Idle. Ok, ich hoffe das sich das evtl.. noch etwas verbessert mit BIOS-Updates oder auch einem neueren Kernel. Warten wir mal ab.

-

@FrankM sind die 20Watt mit HDDs?

Mein alter HP Gen8 nimmt 22Watt im idle mit 4x3TB platten im standby.

Wollte den eigentlich mal durch ein n100 ersetzen.

-

Guten Morgen. Ich würde zu den SSD gern eine Frage stellen. Ich möchte von meinem RasPi auch auf das Board umsteigen. Nun habe ich mich etwas in Proxmox und ZFS eingelesen. Das soll große Schreiblasten verursachen und die SSD ordentlich stressen bzw. kaputschreiben.

Hast Du Enterprise - SSD? Oder anders gefragt, welche Erfahrungen konntest Du bislang mit SSDs in Verbindung mit Proxmox machen?

Danke sehr und allen einen schönen Sonntag.

-

@RaSc sagte in Proxmox - Umzug auf neue Hardware ASRock N100DC-ITX:

Nun habe ich mich etwas in Proxmox und ZFS eingelesen. Das soll große Schreiblasten verursachen und die SSD ordentlich stressen bzw. kaputschreiben.

Hallo @RaSc und Willkommen im Forum. Ja, das kann passieren, vor allen Dingen im Zusammenhang mit dem Proxmox Backup Server. Das ist aber für mein Setup unerheblich, warum? Eine Erklärung.

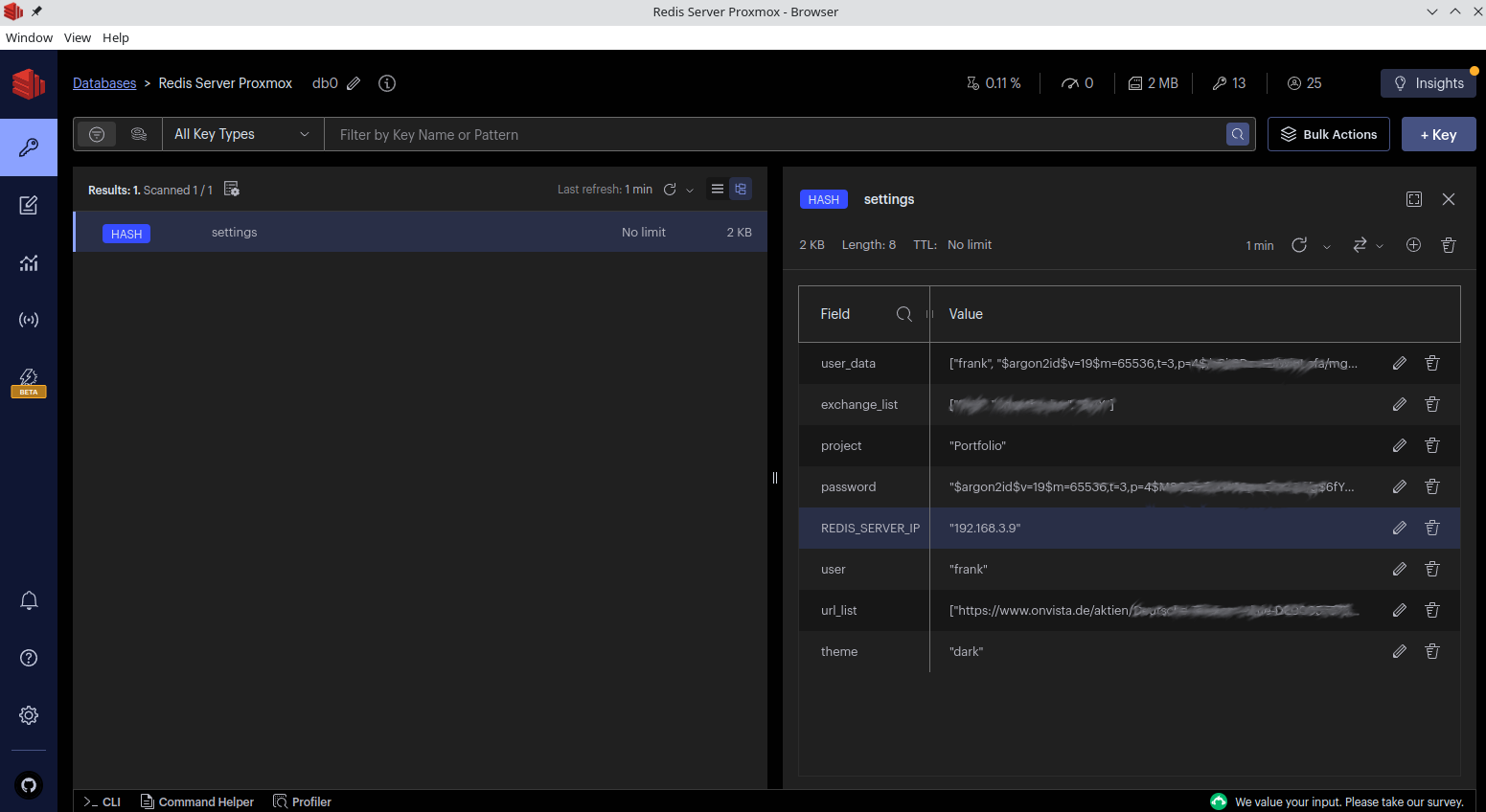

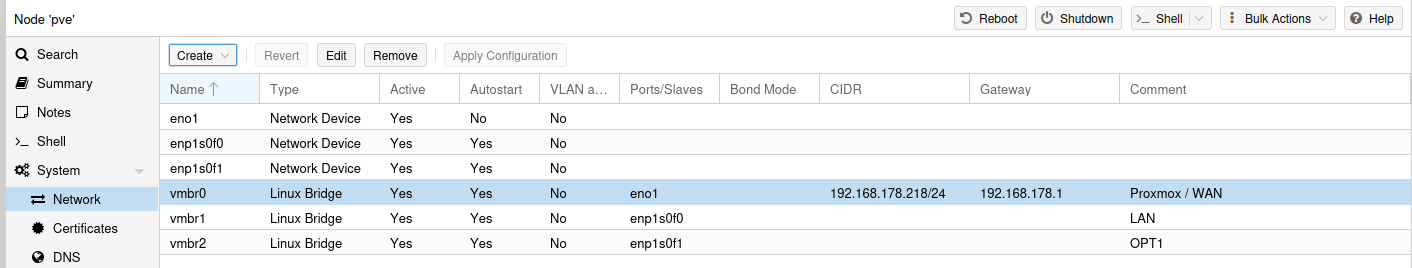

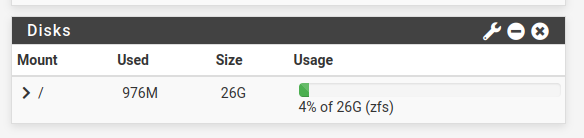

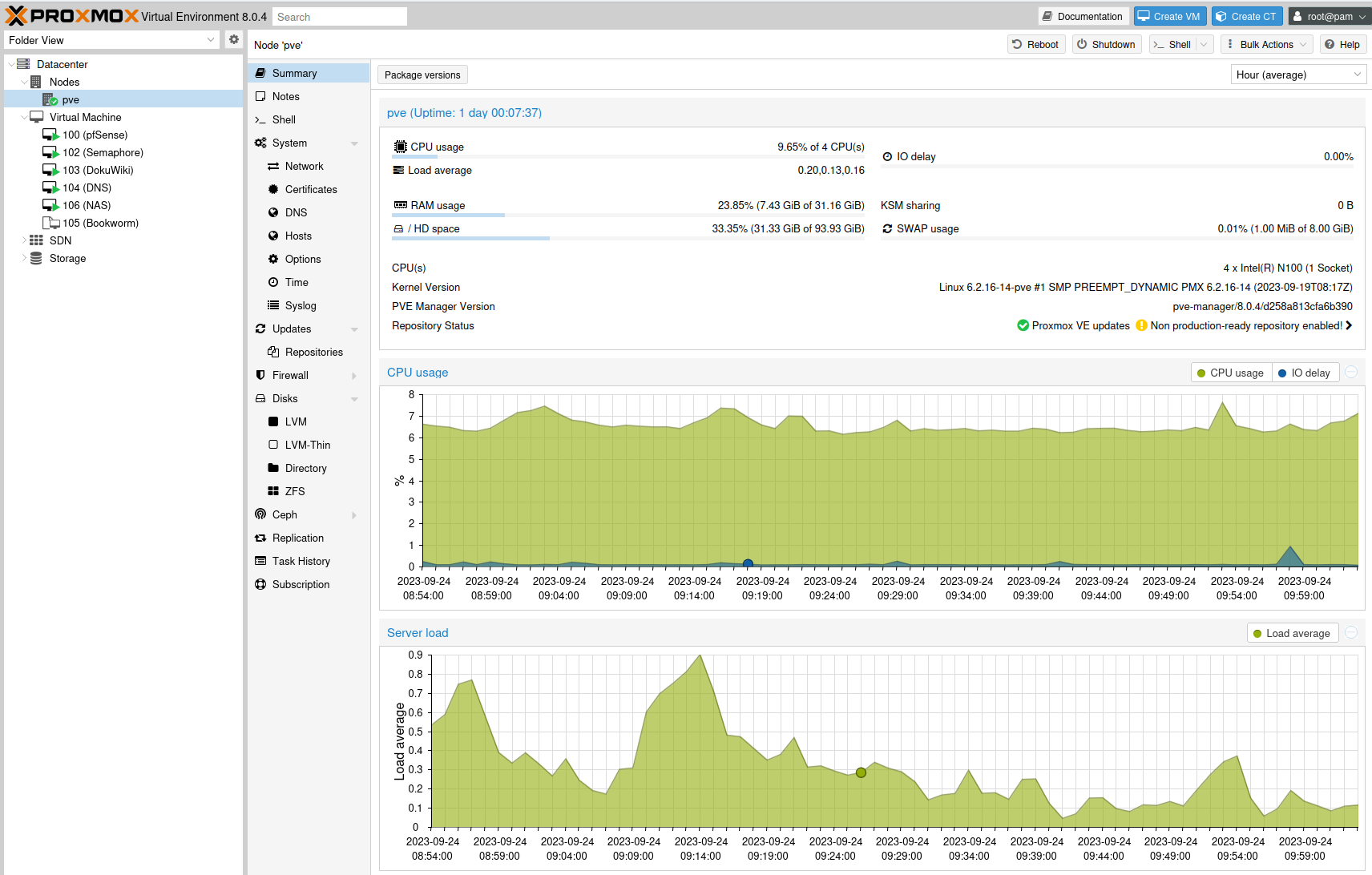

Mein Proxmox Setup basiert auf einer verbauten NVMe SSD. Soll heißen, der Proxmox Host läuft auf dieser NVMe und beinhaltet ein normales ext4.

/dev/mapper/pve-root: UUID="0aad6271-9162-479a-a724-cde690acfb10" BLOCK_SIZE="4096" TYPE="ext4"Ok, alles gut. Läuft also wie immer. Warum jetzt ZFS im Proxmox? Proxmox bietet über sein GUI nur eine Raid Installation mittels ZFS an. So weit ich weiß, bietet man auch nur dafür Support an.

Man könnte das auch noch über die Konsole machen, Stichwort mdadm, aber ich erinnere mich das das nicht so wollte wie es sollte. So habe ich am Ende doch zu ZFS gegriffen.

Noch ein kurzes Beispiel, wer noch so alles zu ZFS greift. pfSense nutzt das mittlerweile auch.

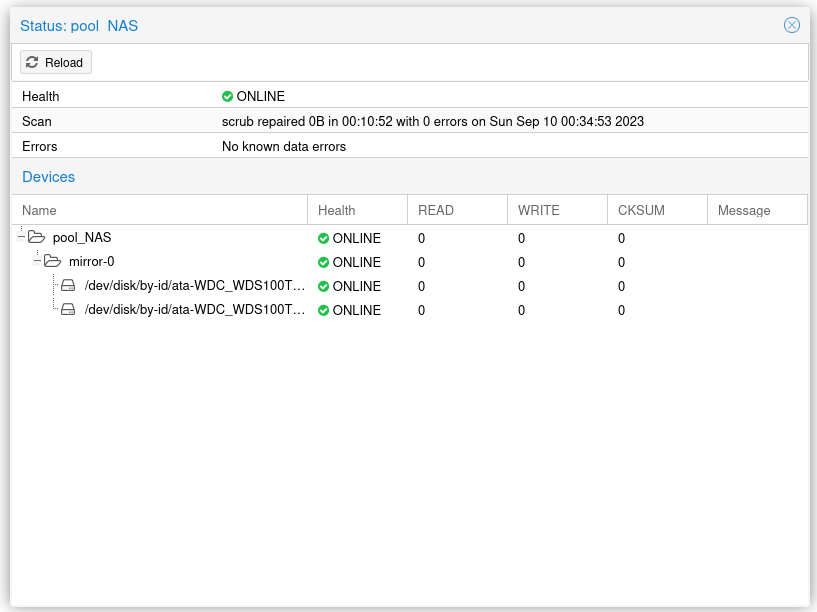

Zurück zu meinem NAS. Jetzt habe ich zwei SSD-Platten WD Red an den SATA-Ports angeschlossen. Diese beiden SSDs sind zu einem Raid 1 (ZFS) zusammengefasst.

Da passiert erst mal gar nichts, weil was soll da groß drauf schreiben? Ist nur meine persönliche Datenablage.

Was bei ZFS sehr wichtig ist, ist genug RAM. Da ZFS sehr viel RAM für die Verwaltung benötigt. (Bin da kein Experte für)

Aber auch das sehe ich ganz entspannt.

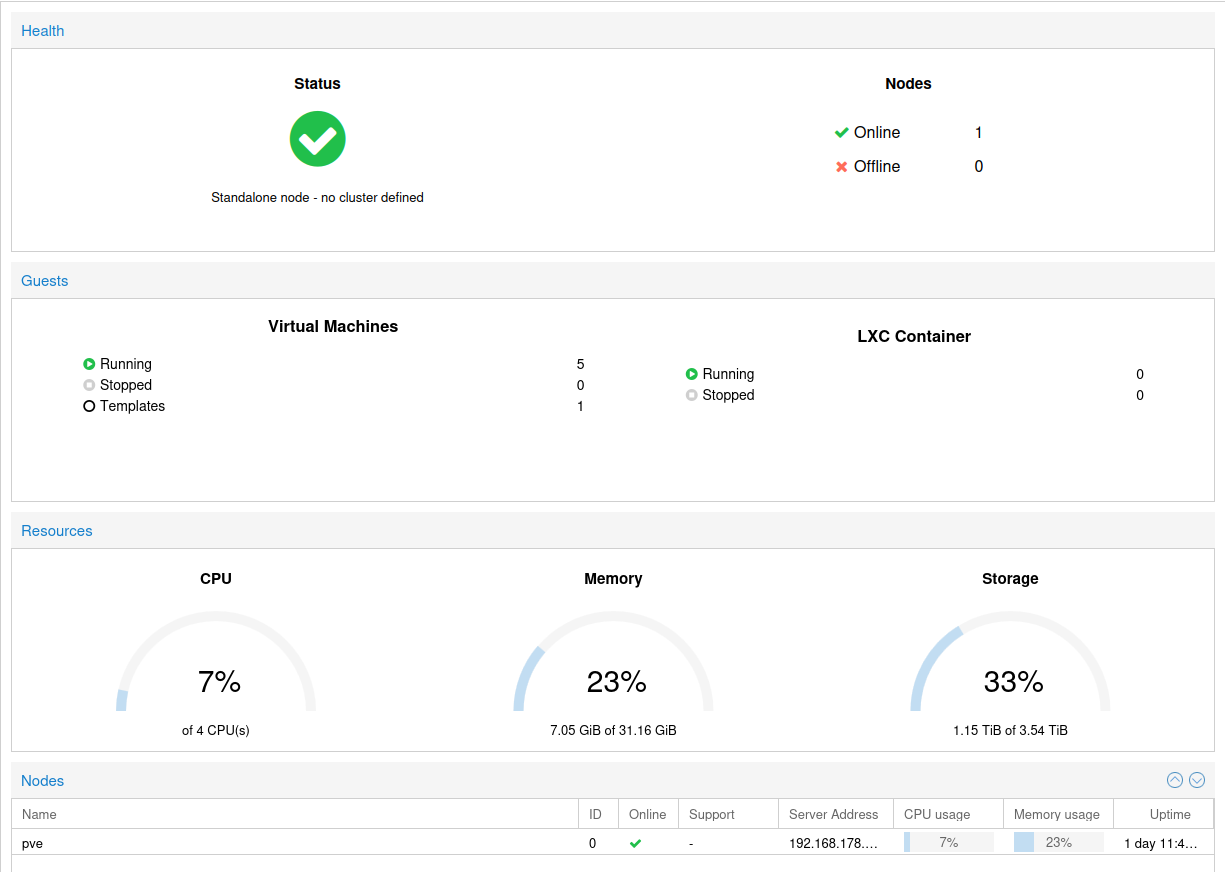

Es laufen aktuell 5 Debian Bookworm 12 VMs.

Was wichtig ist, aber das ist es immer, Backups! Die lege ich auf eine angeschlossene 2,5 Zoll HDD ab. Da kommen die Backups der VMs und mein Restic Backup des NAS drauf.

Ich fühle mich damit eigentlich ganz wohl

-

Vielen Dank. Das heißt, Du nutzt für Proxmox an sich keine Redundanz und verzichtest auf eine Sicherheitsfeatures, die ZFS bringen würde. Wie oft sicherst Du denn mit Deinem Setup Proxmox und die VMs? Wenn tatsächlich mal etwas aus dem Backup zurückgespielt werden muss, wird das gesamte Paket, also Proxmox und VMs zurückgespielt?

Danke sehr.

-

Man muss hier sehr unterscheiden, ob ich Proxmox zu Hause laufen habe oder im Internet. Eine Installation im Internet würde vollkommen anders aussehen. Hier dreht es sich aber um eine Installation bei mir zu Hause. Und auch auf Hardware, die nur eine begrenzte Anzahl von Platten aufnehmen kann.

Ich habe mit dem jetzigen Setup keine Probleme. Was soll passieren? Worst Case wäre, die NVMe des Proxmox würde kaputt gehen. Ja, das wäre blöd. Also frisch ran, neue Hardware rein, neu aufsetzen und dann die VMs aus dem Backup wieder herstellen.

Die VMs sichere ich täglich, mit der Proxmox Backup Funktion. Das NAS meistens nur wöchentlich.

-

Hallo,

ich habe mir vor ein paar Wochen ebenfalls das Asrock Board zugelegt. Allerdings das N100M anstatt die "DC" Variante.

Als Netzteil habe ich ein altes ITS PSU mit ich glaube 120 W genommen.

Verbaut sind 2x WD SA500 2TB SSD als ZFS Mirror und ein 500GB NVME für das Proxmox System. Als 32GB Ram Modul habe ich das gleiche verwendet und hat läuft auch ohne Probleme.

Hab ein 2.5Gb USB PCIe Netzwerkkarte gegönnt. Damit komme ich auf irgendwo schreibend 200 Mb/s, lesend 270 Mb/s (Samba share). Hatte bisher auf meinem "großen" Nas mit drehenden Platten ein Austausch+SVN drauf. Das werde ich auf den kleinen Rechner umziehen damit ich den großen NAS öfters ausschalten kannBackup: Die VMs werden auf das NAS gesichert -> SMB

-> unschön: Würde gerne jedes Backup in einem Unterordner sehen. Aber alle erscheinen unter /backupziel/dump. Geht wohl nur wenn ich in Proxmox mehrere Backup Ziele/Storages einrichteBisher laufen mehrere VMs

- Wordpress*Nextcloud -> von außen erreichbare Anwendungen

- interne Anwedungen wie "Teile Manager", Wiki, Unifi Controller

- Smart Home: Ich nutze hier FHEM, Grafana, MariaDB,....

- Homeassistant läuft noch nebenher, unter Raspberry hatte ich damit Probleme und bin deshalb bei FHEM geblieben

Alles "VMs", keine LXC Container. Hatte immer das aktuelle Ubuntu Server Image verwendet

Die ganze Kiste läuft irgendwo zwischen 15..17 W im Idle. Wobei das Netzteil alleine schon zwischen 4 und 5 W benötigt - selbst wenn es nicht am PC eingesteckt ist. Hatte ein 150W "klassisches" Netzteil probiert - das war aber keineswegs besser.

Tolles kleines Board, das jetzt schon 2 Raspberrys ersetzt.

Grüße

Malte -

@maltejahn Freue mich den sehr positiven Erfahrungsbericht zu lesen. Viel Spaß weiterhin.

-

Ich hab mir, unter anderem auch als Folge von dem Testbeitrag, auch so ein Board gekauft, aber ich bekomme es ums Verrecken nicht stabil zum laufen.

Egal was ich drauf boote, es crasht sobald irgendeine Form von Last drauf ist. Debian 12 wäre das eigentliche Ziel-OS, aber selbst Win10 und einfach nur memtest86 haben das gleiche Resultat - bunter Schnee auf dem Bildschirm gefolgt von einem harten Reset.

Ich sitze jetzt vor dem dritten dieser Boards, alle das gleiche Problem.. hab extra von unterschiedlichen Händlern bestellt um Chargen-Fehler auszuschliessen.

Einfach nur dieses Board, die gleiche Crucial P3 500GB SSD und einen Kingston ValueRAM DDR4-3200 (der auch korrekt erkannt wird), vor mir auf seinem Karton liegend. Alter Intel PWM boxed-Lüfter draufgelegt, damits nicht zu warm wird.

Memtest86 findet, wenn es denn mal komplett durch schafft, keine Fehler.. werde aber trotzdem mal austauschen. Netzteile hab ich auch schon drei durchprobiert (Dell, Fujitsu, HP Laptopziegel mit 19V 90W).

Ursprünglich hatte ich den Intel i915 Treiber in Verbindung mit einer doch sehr neuen CPU+iGPU in Verdacht, aber wenn ich den rausschmeisse und rein in VESA Modus boote, bleiben die Crashes, nur der bunte Schnee davor tritt nicht auf.

Irgendwelche Ideen was das sein könnte? BIOS-Einstellungen sind alle auf defaults, nix getuned oder so.

Sobald ich 'stress -c 2 -m 2' starte, was für eine 4-Kern CPU eigentlich keine Bedrohung sein sollte, resettet das Board in weniger als 30 Sekunden. -

Hallo @wooshell , erst mal sehr schade das Du so einen Stress mit dem Board hast. Ich habe das jetzt schon Monate laufen, übrigens ohne einen Kühler. Ok, wird ordentlich warm aber ich hasse Lüfter

Ich kann leider nicht so richtig erkennen, wo dein Problem liegt. Wie groß ist dein Speicher? Ist der in der Liste der unterstützen RAM Riegel?

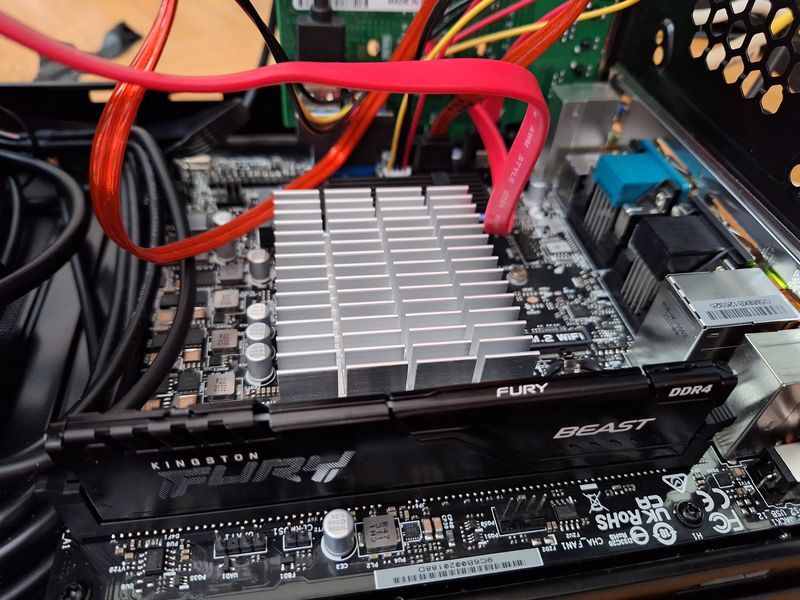

Das habe ich verbaut.

RAM: Corsair Vengeance SODIMM 32GB (2x16GB) DDR4 2400MHz CL16 https://www.corsair.com/de/de/Kategorien/Produkte/Arbeitsspeicher/VENGEANCE-DDR4-SODIMM/p/CMSX32GX4M2A2400C16

Aus dem Bauch heraus, würde ich auf RAM tippen.

-

F FrankM hat auf dieses Thema verwiesen

F FrankM hat auf dieses Thema verwiesen