Proxmox Setup 2025

-

Ja, so als Server Spielkind baut man ab und zu, einfach alles um

Zuletzt lief mein Proxmox auf folgender Hardware -> https://linux-nerds.org/topic/1450/asrock-n100dc-itx

Mein Bericht damals zum Umzug auf die neue Hardware -> https://linux-nerds.org/topic/1452/proxmox-umzug-auf-neue-hardware-asrock-n100dc-itx/8

Lief alles tadellos, aber ich brauchte etwas schnelleres und mit mehr RAM. Ja, das kostet leider auch etwas mehr Strom

(ca. 38W mit meinem aktuellen Ausbau)

(ca. 38W mit meinem aktuellen Ausbau)Ich habe hier ein Mini-ITX MSI B550i rumliegen. Das war jetzt auserkoren, meinen Proxmox zu beherbergen. Mein Netzwerksetup sieht ein drei LAN-Schnittstellen Setup vor.

- WAN

- LAN

- OPT1

Auf dem Board ist eine 2.5G Schnittstelle drauf, die macht dann WAN. Jetzt brauchte ich eine PCIe Karte mit zwei LAN Schnittstellen. Ich wollte die 1G nicht mehr nutzen, man muss ja auch was testen

Meine Wahl fiel auf diese PCIe- Karte -> https://www.amazon.de/dp/B0C4H4KCRJ?th=1

Die Karte beinhaltet 2 * RTL8125B Controller.Danach pfSense eingerichtet, bzw. den Dump restored. Die Hardware an die neuen Netzwerkkarten angepasst und fertig. Gestartet - läuft.

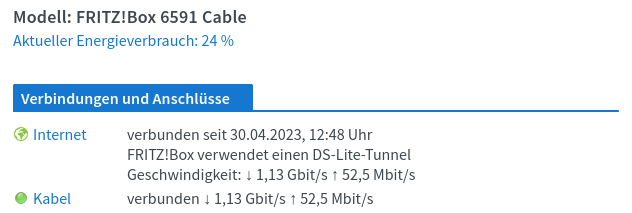

Schnell noch ein Speedtest

root@nas:~# iperf3 -s ----------------------------------------------------------- Server listening on 5201 (test #1) ----------------------------------------------------------- ^Ciperf3: interrupt - the server has terminated root@nas:~# iperf3 -c 192.168.3.213 Connecting to host 192.168.3.213, port 5201 [ 5] local 192.168.3.19 port 33950 connected to 192.168.3.213 port 5201 [ ID] Interval Transfer Bitrate Retr Cwnd [ 5] 0.00-1.00 sec 281 MBytes 2.36 Gbits/sec 0 3.58 MBytes [ 5] 1.00-2.00 sec 280 MBytes 2.35 Gbits/sec 0 3.58 MBytes [ 5] 2.00-3.00 sec 279 MBytes 2.34 Gbits/sec 0 3.58 MBytes [ 5] 3.00-4.00 sec 280 MBytes 2.35 Gbits/sec 0 3.58 MBytes [ 5] 4.00-5.00 sec 279 MBytes 2.34 Gbits/sec 0 3.58 MBytes [ 5] 5.00-6.00 sec 280 MBytes 2.35 Gbits/sec 0 3.58 MBytes [ 5] 6.00-7.00 sec 279 MBytes 2.34 Gbits/sec 184 2.70 MBytes [ 5] 7.00-8.00 sec 280 MBytes 2.35 Gbits/sec 0 2.91 MBytes [ 5] 8.00-9.00 sec 279 MBytes 2.34 Gbits/sec 0 3.08 MBytes [ 5] 9.00-10.00 sec 280 MBytes 2.35 Gbits/sec 0 3.22 MBytes - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate Retr [ 5] 0.00-10.00 sec 2.73 GBytes 2.35 Gbits/sec 184 sender [ 5] 0.00-10.01 sec 2.73 GBytes 2.34 Gbits/sec receiver iperf Done. root@nas:~# iperf3 -R -c 192.168.3.213 Connecting to host 192.168.3.213, port 5201 Reverse mode, remote host 192.168.3.213 is sending [ 5] local 192.168.3.19 port 59378 connected to 192.168.3.213 port 5201 [ ID] Interval Transfer Bitrate [ 5] 0.00-1.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 1.00-2.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 2.00-3.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 3.00-4.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 4.00-5.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 5.00-6.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 6.00-7.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 7.00-8.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 8.00-9.00 sec 280 MBytes 2.35 Gbits/sec [ 5] 9.00-10.00 sec 280 MBytes 2.35 Gbits/sec - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate Retr [ 5] 0.00-10.00 sec 2.74 GBytes 2.35 Gbits/sec 0 sender [ 5] 0.00-10.00 sec 2.74 GBytes 2.35 Gbits/sec receiver iperf Done.Und wer sich jetzt fragt, was ich als Switch genommen habe -> https://www.amazon.de/dp/B0CFQKYDRM

Ein China Teil, was laut Kommentaren furchtbar heiß werden soll. In meinem Setup gar nicht. In den Kommentaren schreiben viele, das sie das Webinterface schlecht erreichen konnte. War kein Problem, man sollte halt auch im selben Netzwerk sein. Läuft jetzt hier seit einer Woche ohne Probleme.

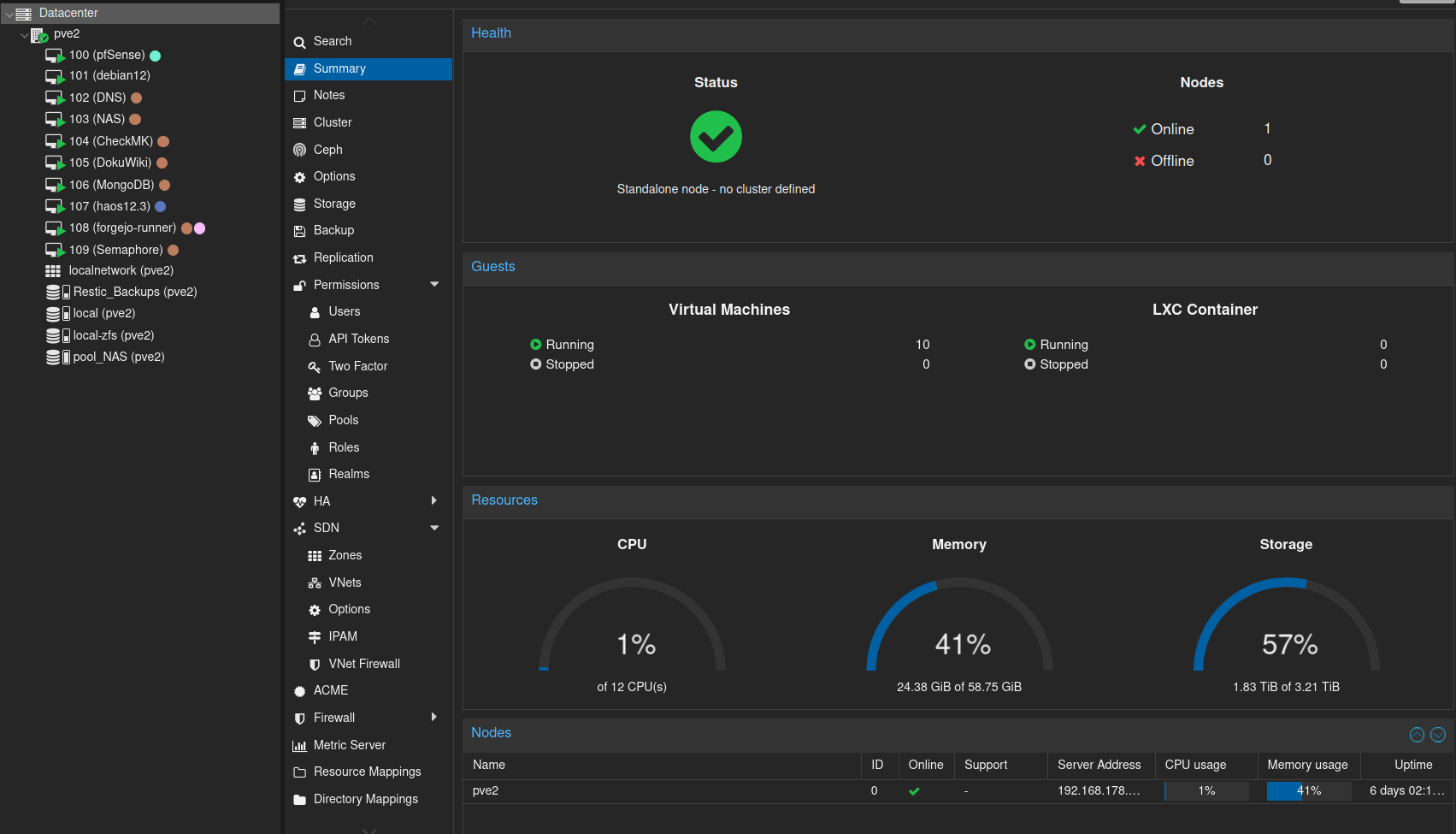

Setup Proxmox

Den Proxmox eingerichtet, das ist ja jetzt nicht so die Herausforderung. Auf dem Board sind zwei NVMe Steckplätze, die auch beide bestückt sind, So mit 500GB jeweils.

Da bot es sich an, bei der Installation eine ZFS Raid 1 Installation vorzunehmen. Das habe ich dann auch so gemacht. Macht dann

root@pve2:~# dd if=/dev/zero of=test.img bs=1M count=4096 conv=fdatasync 4096+0 records in 4096+0 records out 4294967296 bytes (4.3 GB, 4.0 GiB) copied, 1.08774 s, 3.9 GB/sRestore VMs

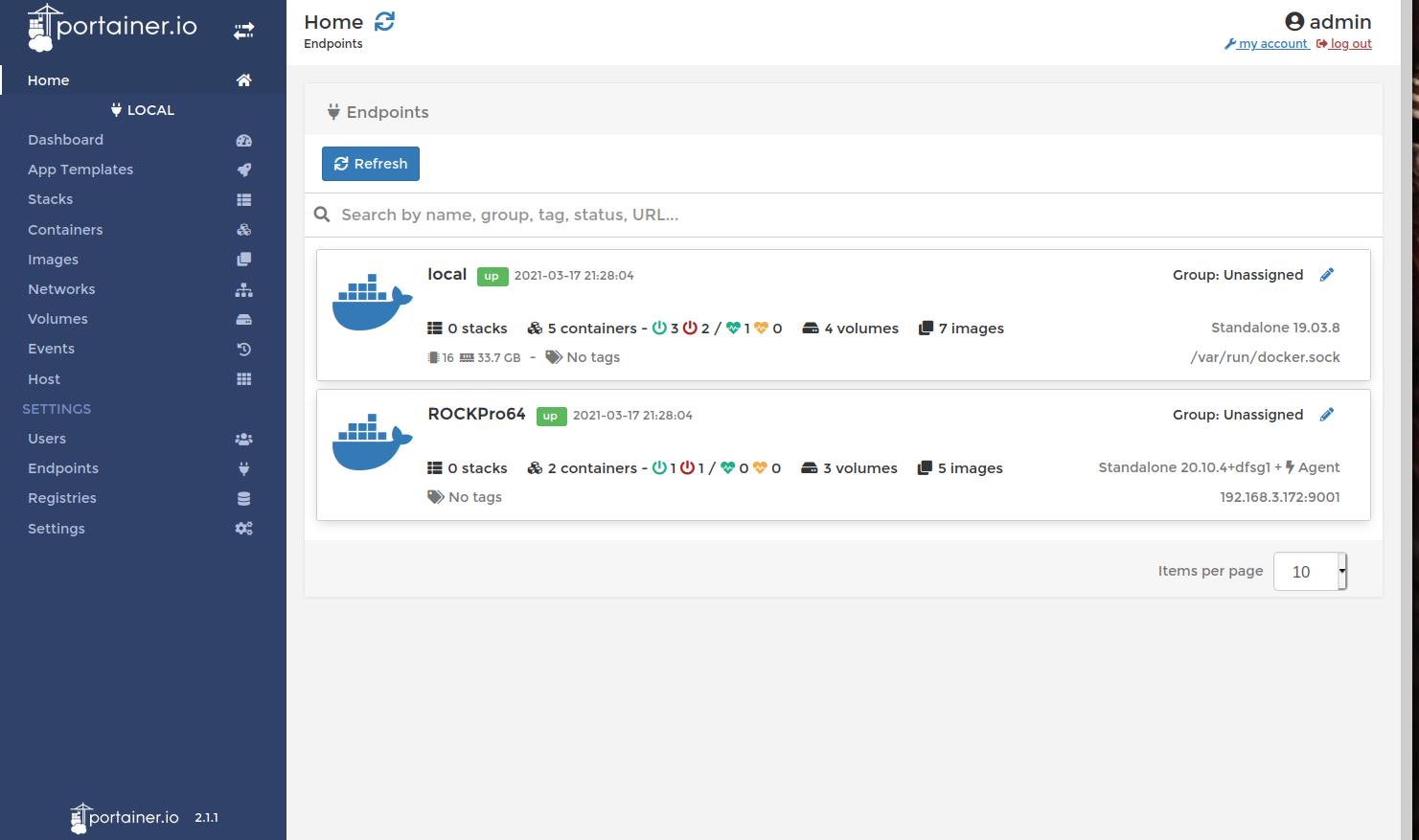

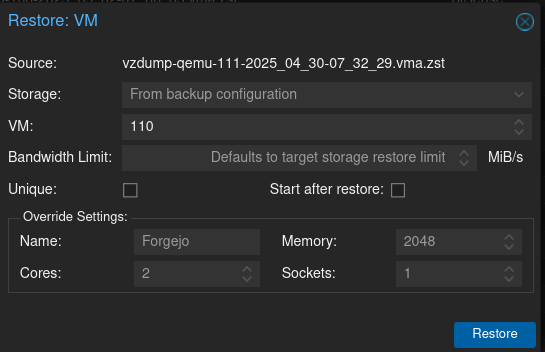

Das ist wirklich so mit das Einfachste was es gibt. Mit scp vom alten Proxmox alle Dumps auf den Neuen kopiert. Dann braucht man den letzten Dump nur Auswählen auf Restore klicken, Datenspeicher auswählen und fertig.

Gut, das war jetzt nicht so die Herausforderung.

NAS ZFS Pool

Mein NAS beinhaltet einen ZFS Pool Raid 1, den ich damals mit Proxmox angelegt hatte und dann an die VM durchreiche. Ok, wie bekomme ich das auf den neuen Proxmox?

Man kopiert die Einstellung vom alten Proxmox.

zfspool: pool_NAS pool pool_NAS content rootdir,images mountpoint /pool_NAS nodes pve2Man achtet auf den richtigen Namen bei nodes

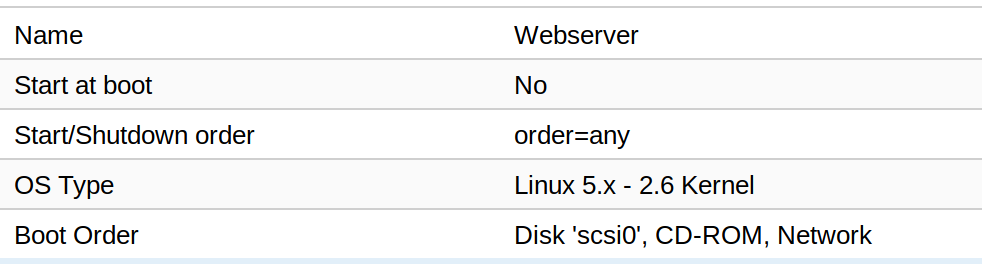

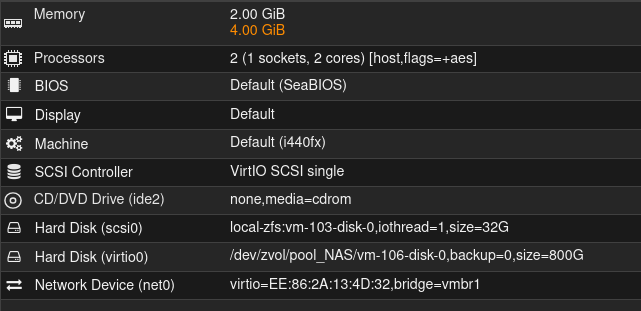

Danach muss man den Pool an die VM dran hängen. Meine neue VM für das NAS hat die ID 103, die alte hatte die ID 106. Ich habe das so gelassen, weil ich nicht wusste ob ich den Namen einfach so anpassen konnte. War aber nicht nötig, weil es auch so gut funktionierte.

qm set 103 --virtio0 /dev/zvol/pool_NAS/vm-106-disk-0

Der Rest war dann ganz normale Arbeit, VMs restoren, Backups einrichten, Domains konfigurieren, Mail Setup usw.

-

-

-

Debian Bookworm 12.9 released

Verschoben Linux -

-

-

-

-

Let's Encrypt installieren

Verschoben Let's Encrypt