Kernel 4.4.x

-

4.4.167-1175-rockchip-ayufan released

- Old driver is

rockchip-drm-rga

- Old driver is

-

4.4.167-1184-rockchip-ayufan released

4.4.167-1185-rockchip-ayufan released- Revert "PCI: rockchip: Add Rockchip DW PCIe controller support"

- Revert "nuumio: dts/c: rockpro64: add pcie scan sleep and enable it for rockpro64 (#45)"

und viele andere Änderungen. https://gitlab.com/ayufan-repos/rock64/linux-kernel/commits/release-4.4

-

-

4.4.167-1201-rockchip-ayufan released

Ganz schön aktiv unser Kamil im Moment.

Hier zum Nachlesen -> https://gitlab.com/ayufan-repos/rock64/linux-kernel/commits/release-4.4

-

4.4.167-1217-rockchip-ayufan released

Kamil hat die letzten Tage viele Änderungen gemacht, aber hauptsächlich für das kommende Pinebook Pro.

Hier zum Nachlesen https://gitlab.com/ayufan-repos/rock64/linux-kernel/commits/release-4.4

-

4.4.185-1222-rockchip-ayufan released

Der Kernel ist seit 10.7.19 auf kernel.org, also habt ihr jetzt wieder was Frisches

-

Kamil war fleißig, in erster Linie für das kommende PineBook-Pro.

- ayufan: dts: pinebook-pro: add OPP for 2/1.5GHz

- ayufan: dts: pinebook-pro: reduce thresholds

- ayufan: dts: rk3399: configure DMA for uarts and spis

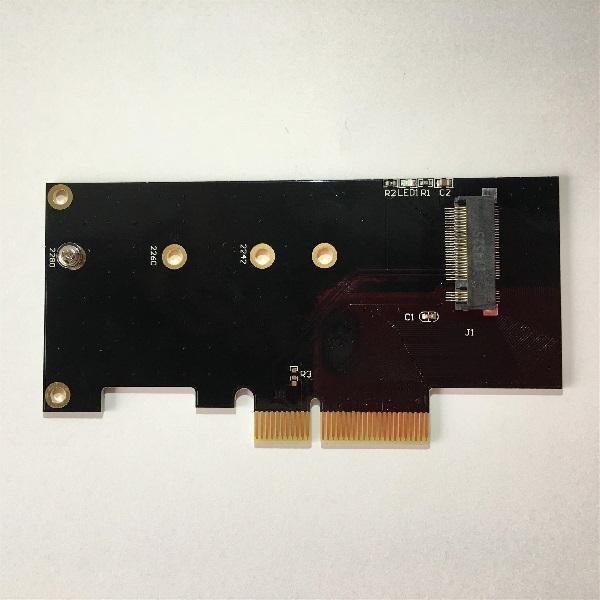

- ayufan: dts: pinebook-pro: enable PCIE

Damit sind wir jetzt bei 4.4.189-1229-rockchip-ayufan