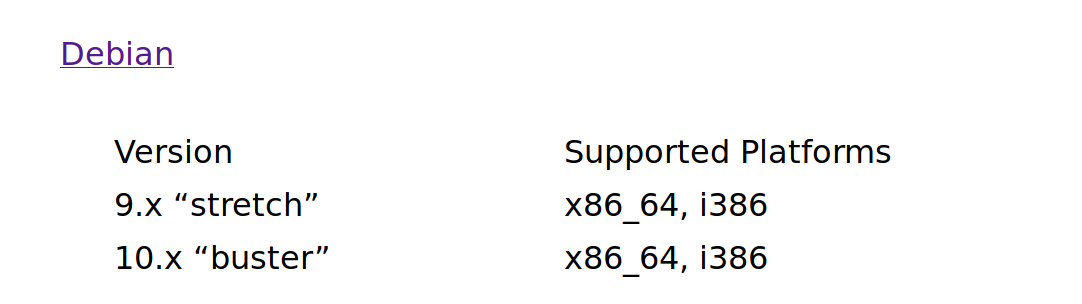

Debian Bookworm 12.11 released

Dieses Thema wurde gelöscht. Nur Nutzer mit entsprechenden Rechten können es sehen.

-

Debian hat 12.11 für Bookworm veröffentlicht

The Debian project is pleased to announce the eleventh update of its stable distribution Debian 12 (codename "bookworm"). This point release mainly adds corrections for security issues, along with a few adjustments for serious problems. Security advisories have already been published separately and are referenced where available.

33 packages can be upgraded. Run 'apt list --upgradable' to see them. N: Repository 'http://deb.debian.org/debian bookworm InRelease' changed its 'Version' value from '12.10' to '12.11'Im Fediverse -> @FrankM@nrw.social

- NanoPi R5S

- Quartz64 Model B, 4GB RAM

- Quartz64 Model A, 4GB RAM

- RockPro64 v2.1

-

Der Longread zum Sonntag.

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Uncategorized microsoft mcsd developer windows linux 1

0 Stimmen2 Beiträge4 Aufrufe

1

0 Stimmen2 Beiträge4 Aufrufe -

Every Ubuntu Linux default wallpaper

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux linux 1

0 Stimmen6 Beiträge128 Aufrufe

1

0 Stimmen6 Beiträge128 Aufrufe -

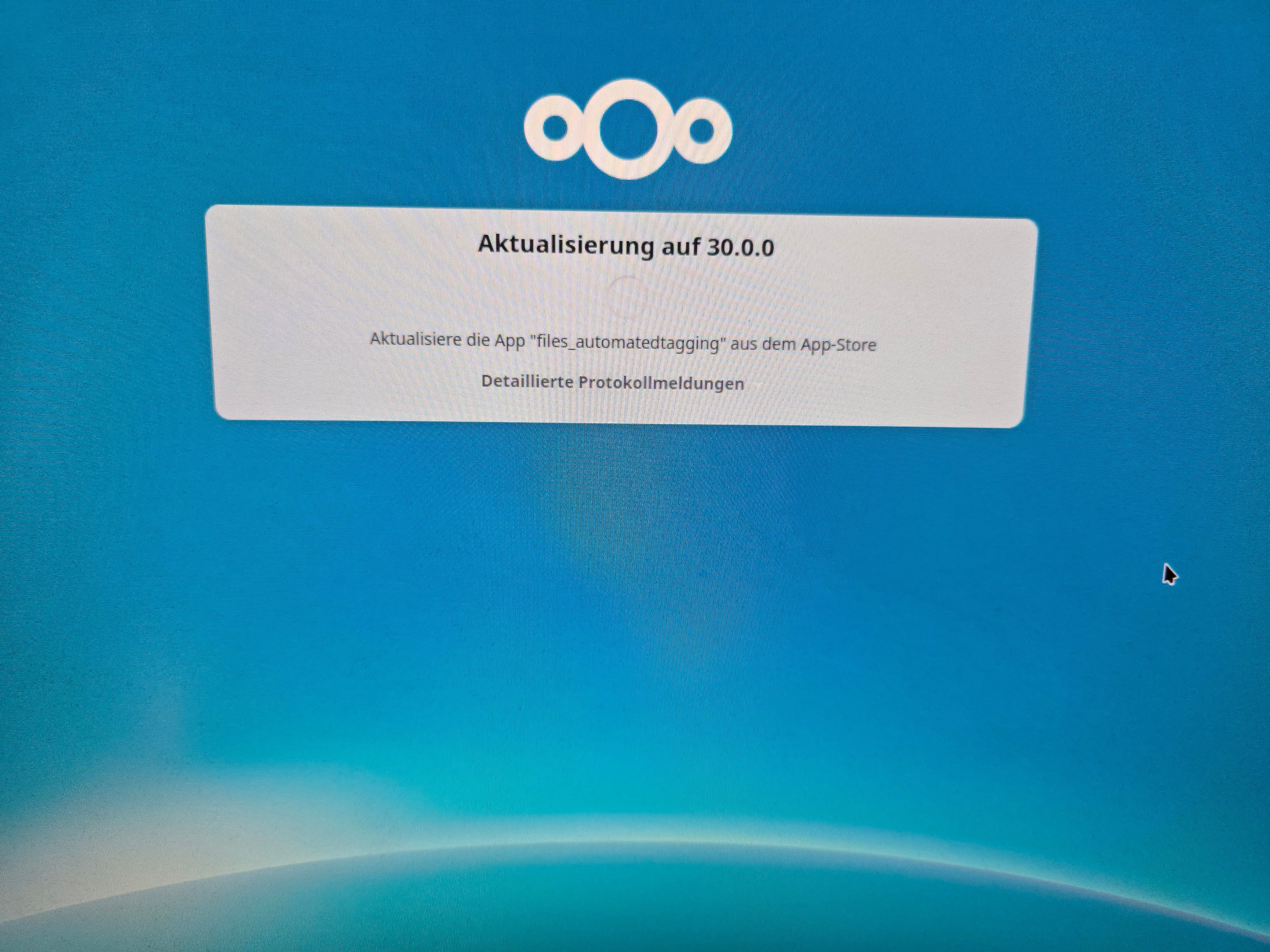

Nextcloud - Upgrade Hub 9 (30.0.0)

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Nextcloud nextcloud linux 2

0 Stimmen3 Beiträge2k Aufrufe

2

0 Stimmen3 Beiträge2k Aufrufe -

ZFS - Wichtige Befehle

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux zfs linux0 Stimmen3 Beiträge1k Aufrufe -

OpenWrt - Sysupgrade

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben OpenWRT & Ubiquiti ER-X openwrt linux er-x0 Stimmen1 Beiträge299 Aufrufe -

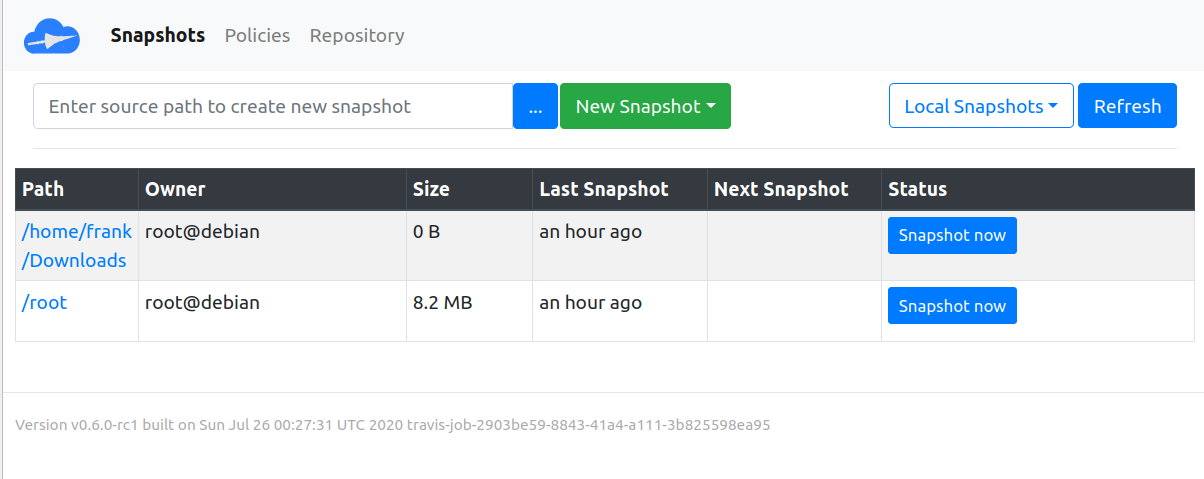

Kopia - HTTP/S Server

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Kopia kopia linux 2

0 Stimmen3 Beiträge2k Aufrufe

2

0 Stimmen3 Beiträge2k Aufrufe -

NGINX - Installation

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben NGINX nginx linux 2

0 Stimmen1 Beiträge367 Aufrufe

2

0 Stimmen1 Beiträge367 Aufrufe -

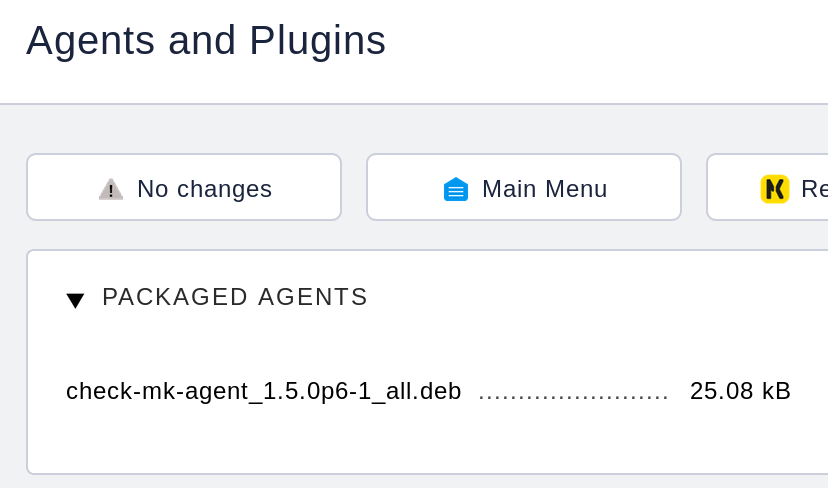

checkmk - Agent installieren

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben checkmk checkmk linux 1

0 Stimmen1 Beiträge3k Aufrufe

1

0 Stimmen1 Beiträge3k Aufrufe