Bitwarden_RS auf einem Debian Buster 10 Server installieren!

-

Hi zusammen,

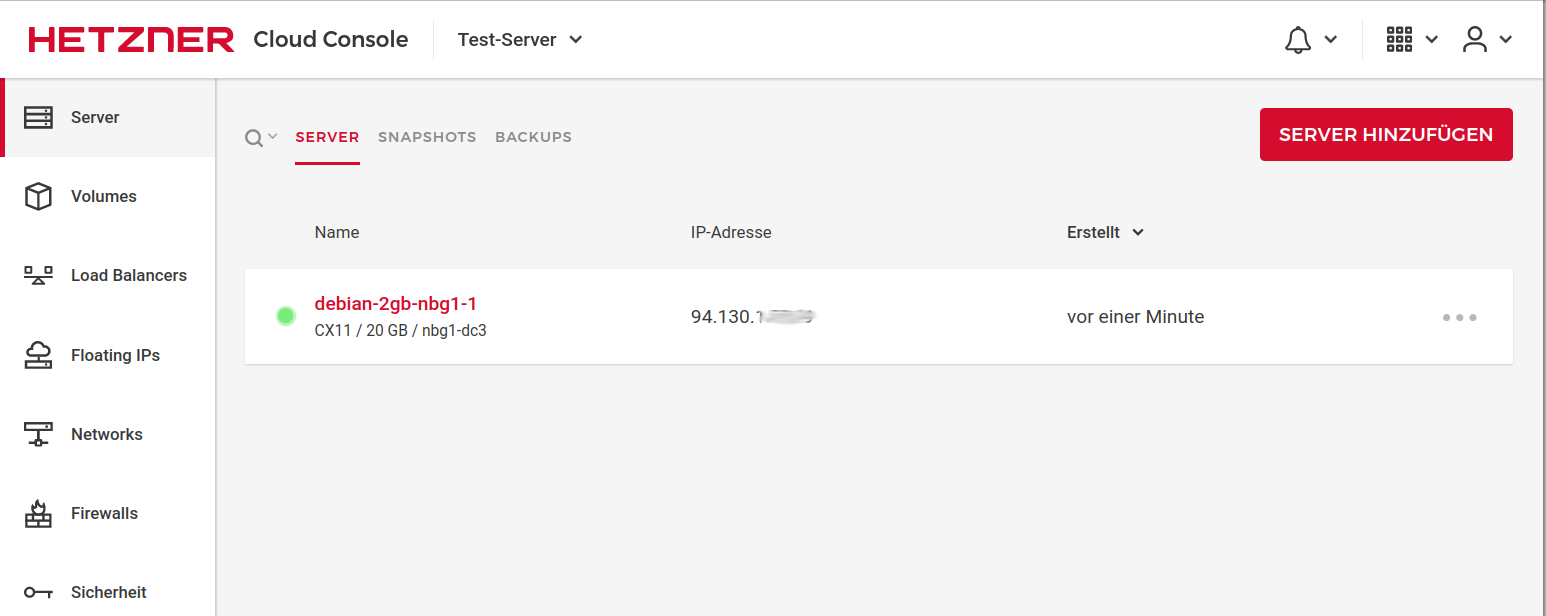

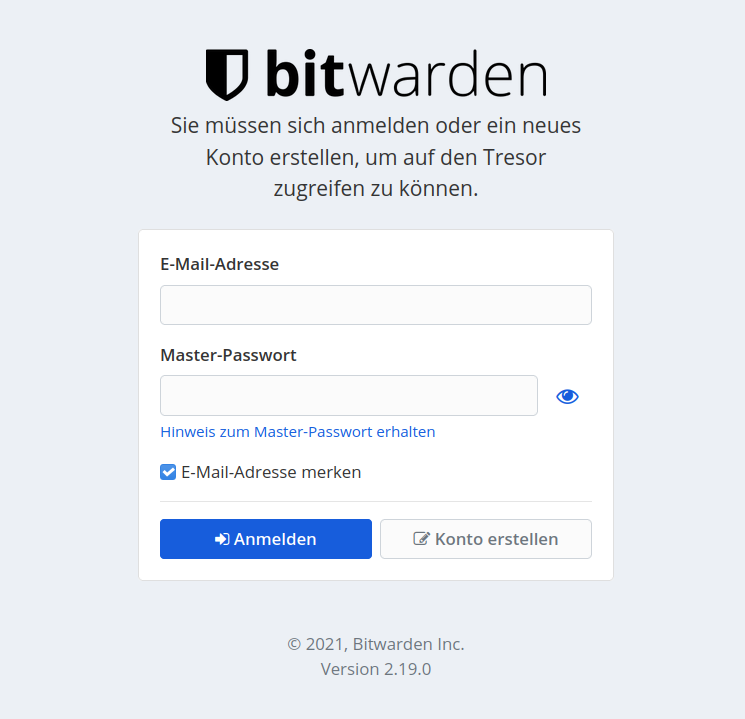

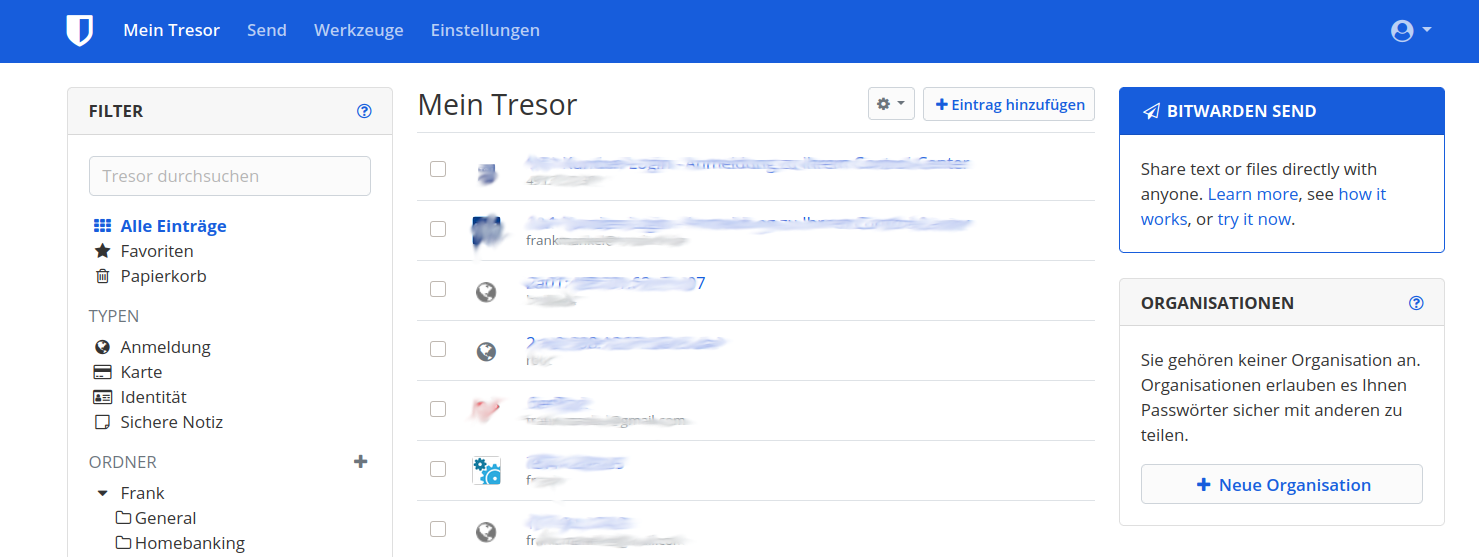

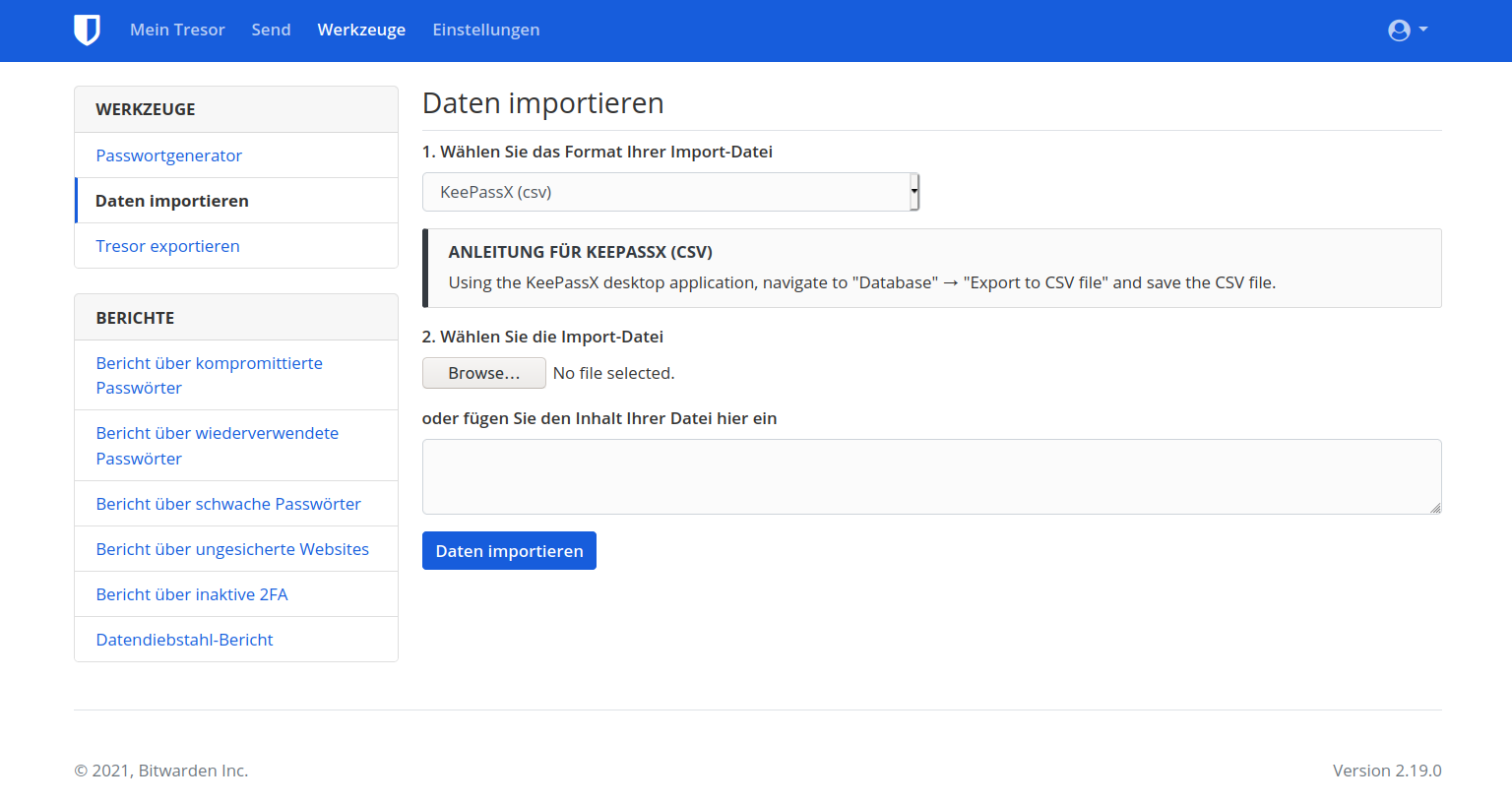

ich wollte nun mal auf einen Debian Server die Installation auf einem Apache durchführen.

Bei der Einrichtung mit:

apt-key adv --keyserver keys.gnupg.net --recv-keys 24BFF712

erscheint folgende Fehlermeldung:

Executing: /tmp/apt-key-gpghome.adhmhBrwoR/gpg.1.sh --keyserver keys.gnupg.net --recv-keys 24BFF712

gpg: Empfangen vom Schlüsselserver fehlgeschlagen: Kein NameHabt Ihr eine Idee?

-

schrieb am 12. Sept. 2021, 16:48 zuletzt editiert von

@frankm sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

@Nico ist über das Problem informiert und arbeitet an einer Lösung.

Das hört sich gut an

-

@frankm sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

@Nico ist über das Problem informiert und arbeitet an einer Lösung.

Das hört sich gut an

schrieb am 13. Sept. 2021, 09:42 zuletzt editiert von

schrieb am 13. Sept. 2021, 09:42 zuletzt editiert von@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

@hase567 Ich habe die Anleitung auf https://bitwarden-deb.tech-network.de/ überarbeitet.

Jetzt funktioniert es auch mit Debian 11 und neueren Ubuntu Versionen.Konkret hat sich Schritt 1 geändert. Das Hinzufügen des Keys erfolgt jetzt über:

wget -O /etc/apt/trusted.gpg.d/bananian-keyring.gpg https://bitwarden-deb.tech-network.de/bananian-keyring.gpg -

schrieb am 22. Okt. 2021, 08:57 zuletzt editiert von

Hallo, Super Anleitung!

Haben das Vaultwarden auch im Einsatz, hab das Debian Paket aber bisher mit https://github.com/greizgh/vaultwarden-debian gebaut... ging auch ok, würde aber gern das Repository verwenden..

Nur hab ich bei mir schon alles auf den neuen Namen Vaultwarden geändert, und will das natürlich ungern zurückbauen... - gibts da einen Plan wann das umgestellt wird in dem Repository? Oder vielleicht zwischenzeitlich beides im Repo anbieten?

Und neue Version vom Vaultwarden is raus, 1.23 .. hab die mal mit dem Vaultwarden-Debian gebaut, da scheint es jedoch ein Problem zu geben, wenn ich es installier komm ich nicht mehr auf die Weboberfläche, Service rennt aber... da müsste ich schauen was da ist, würde mir das aber gerne ersparen wenns eh ein Repository gibt -

hoffe also auf eine 1.23 im Repo und auch bald auf eine direkte bullseye Repo Option

Lg, Flo

-

Hallo, Super Anleitung!

Haben das Vaultwarden auch im Einsatz, hab das Debian Paket aber bisher mit https://github.com/greizgh/vaultwarden-debian gebaut... ging auch ok, würde aber gern das Repository verwenden..

Nur hab ich bei mir schon alles auf den neuen Namen Vaultwarden geändert, und will das natürlich ungern zurückbauen... - gibts da einen Plan wann das umgestellt wird in dem Repository? Oder vielleicht zwischenzeitlich beides im Repo anbieten?

Und neue Version vom Vaultwarden is raus, 1.23 .. hab die mal mit dem Vaultwarden-Debian gebaut, da scheint es jedoch ein Problem zu geben, wenn ich es installier komm ich nicht mehr auf die Weboberfläche, Service rennt aber... da müsste ich schauen was da ist, würde mir das aber gerne ersparen wenns eh ein Repository gibt -

hoffe also auf eine 1.23 im Repo und auch bald auf eine direkte bullseye Repo Option

Lg, Flo

schrieb am 22. Okt. 2021, 13:41 zuletzt editiert von FrankM -

schrieb am 25. Okt. 2021, 09:23 zuletzt editiert von

Hallo,

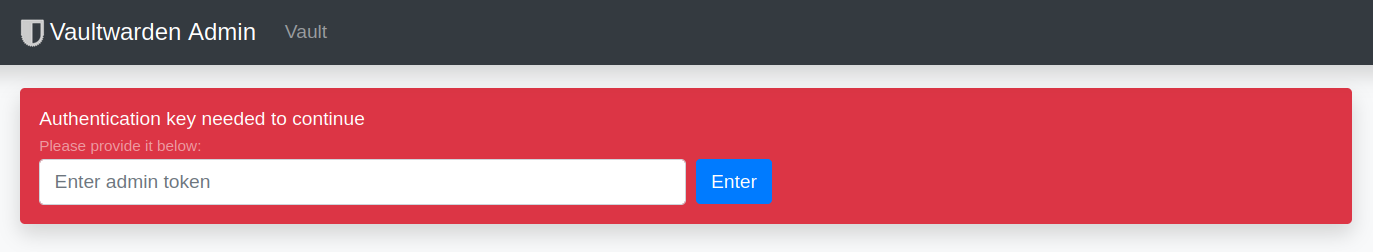

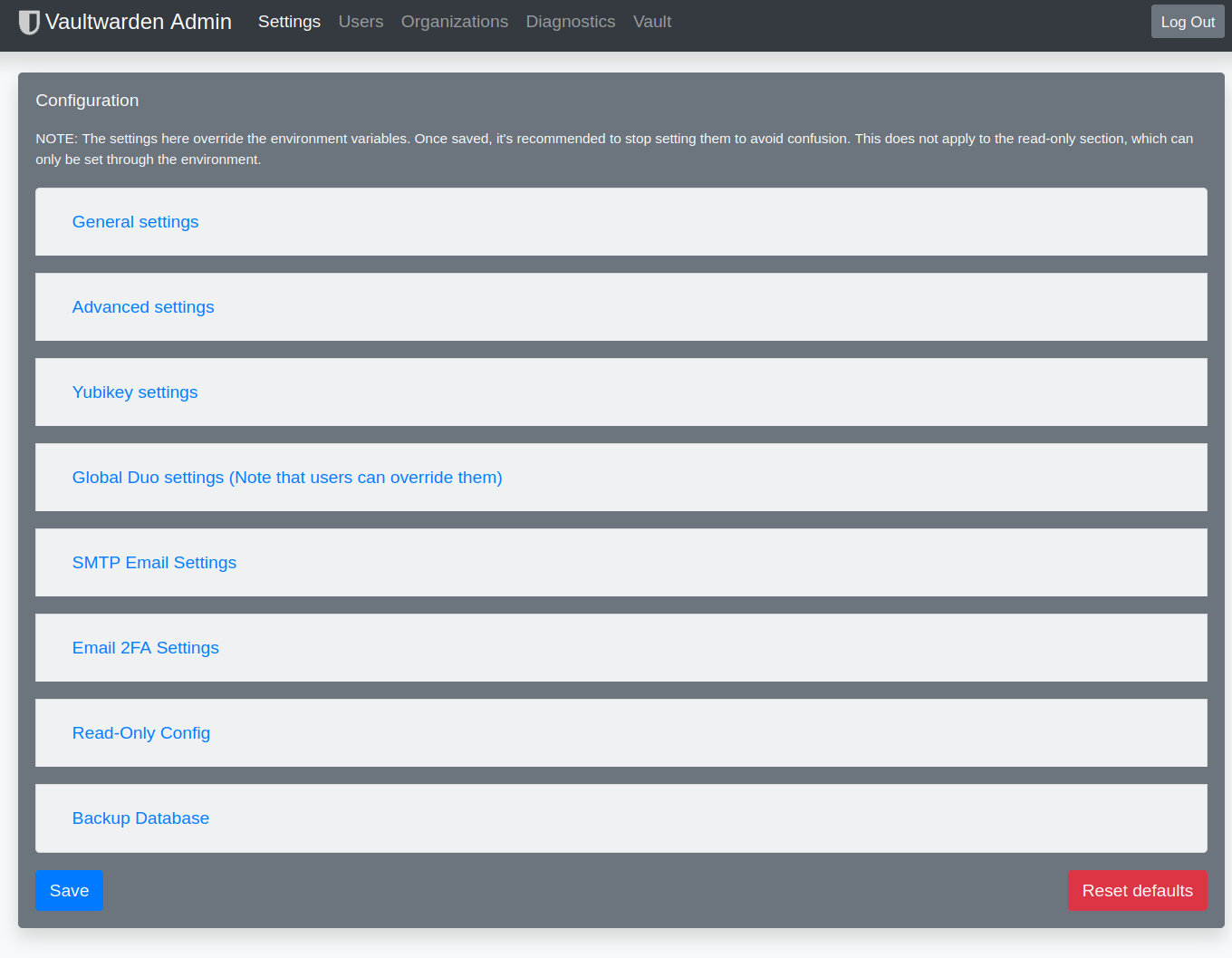

ich habe nun die Bitwarden Installation auf einem Apache Server unter Debian10 installiert.

Soweit funktioniert auch alles bestens, außer der Adminbereich

Wenn ich die Hauptseite vom Adminbereich aufrufe sind die Auswahlpunkte für die Einstellungen

nicht anklickbar bzw. lassen sich diese nicht öffnen! Weiss jemand woran das liegen kann??

Auf dem Nginx Server hat das alles geklappt. -

Hallo,

ich habe nun die Bitwarden Installation auf einem Apache Server unter Debian10 installiert.

Soweit funktioniert auch alles bestens, außer der Adminbereich

Wenn ich die Hauptseite vom Adminbereich aufrufe sind die Auswahlpunkte für die Einstellungen

nicht anklickbar bzw. lassen sich diese nicht öffnen! Weiss jemand woran das liegen kann??

Auf dem Nginx Server hat das alles geklappt. -

schrieb am 26. Okt. 2021, 08:57 zuletzt editiert von

@Frank,

ich habe die Apache Config wie hier im Beitrag entsprechend angepasst und nochmals überprüft. Ist alles OK, ansonsten würde ja alles andere auch nicht funktionieren.Ist nur merkwürdig, warum ich im Adminbereich die Auswahlpunkte nicht ausklappen kann!?!

Kann es vielleicht an einer wichtigen Einstellung in der config.env liegen?

Habe eigentlich nichts weiter verändert...

Wie gesagt, ansonsten läuft alles. -

@Frank,

ich habe die Apache Config wie hier im Beitrag entsprechend angepasst und nochmals überprüft. Ist alles OK, ansonsten würde ja alles andere auch nicht funktionieren.Ist nur merkwürdig, warum ich im Adminbereich die Auswahlpunkte nicht ausklappen kann!?!

Kann es vielleicht an einer wichtigen Einstellung in der config.env liegen?

Habe eigentlich nichts weiter verändert...

Wie gesagt, ansonsten läuft alles.schrieb am 1. Nov. 2021, 17:21 zuletzt editiert von@hase567 Ich glaube, das jetzt ein Beitrag von Dir leider verschwunden ist. Ich hatte ein kleines Problem und habe leider ein paar wenige Daten verloren. Sorry!!

Zum Thema Version 1.23.0

Ist jetzt im Repo, man kann einfach wie gewohnt updaten

root@bitwarden:/var/log# bitwarden_rs -h vaultwarden 1.23.0 Alternative implementation of the Bitwarden server API written in Rust USAGE: vaultwarden FLAGS: -h, --help Prints help information -v, --version Prints the app versionDie komplette Änderung auf den Namen vaultwarden hat @Nico noch nicht implementiert.

-

@hase567 Ich glaube, das jetzt ein Beitrag von Dir leider verschwunden ist. Ich hatte ein kleines Problem und habe leider ein paar wenige Daten verloren. Sorry!!

Zum Thema Version 1.23.0

Ist jetzt im Repo, man kann einfach wie gewohnt updaten

root@bitwarden:/var/log# bitwarden_rs -h vaultwarden 1.23.0 Alternative implementation of the Bitwarden server API written in Rust USAGE: vaultwarden FLAGS: -h, --help Prints help information -v, --version Prints the app versionDie komplette Änderung auf den Namen vaultwarden hat @Nico noch nicht implementiert.

schrieb am 2. Nov. 2021, 07:21 zuletzt editiert von@frankm sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

@hase567 Ich glaube, das jetzt ein Beitrag von Dir leider verschwunden ist. Ich hatte ein kleines Problem und habe leider ein paar wenige Daten verloren. Sorry!!

Moin,

kein Problem. Habe das Problem ja beheben können, lag an einem Firefox AddOn. -

@frankm sagte in Bitwarden_RS auf einem Debian Buster 10 Server installieren!:

@hase567 Ich glaube, das jetzt ein Beitrag von Dir leider verschwunden ist. Ich hatte ein kleines Problem und habe leider ein paar wenige Daten verloren. Sorry!!

Moin,

kein Problem. Habe das Problem ja beheben können, lag an einem Firefox AddOn.schrieb am 8. Jan. 2022, 15:15 zuletzt editiert vonNeues Update da, was die Version 1.23.1 und Web vault 2.25.0 installiert.

Die folgenden Pakete werden aktualisiert (Upgrade): bitwarden-rs 1 aktualisiert, 0 neu installiert, 0 zu entfernen und 0 nicht aktualisiert. Es müssen 12,9 MB an Archiven heruntergeladen werden. Nach dieser Operation werden 0 B Plattenplatz zusätzlich benutzt. Möchten Sie fortfahren? [J/n] Holen:1 http://bitwarden-deb.tech-network.de buster/main amd64 bitwarden-rs amd64 1.23.1-1 [12,9 MB] Es wurden 12,9 MB in 0 s geholt (57,7 MB/s). Changelogs werden gelesen... Fertig (Lese Datenbank ... 36232 Dateien und Verzeichnisse sind derzeit installiert.) Vorbereitung zum Entpacken von .../bitwarden-rs_1.23.1-1_amd64.deb ... Entpacken von bitwarden-rs (1.23.1-1) über (1.23.0-1) ... bitwarden-rs (1.23.1-1) wird eingerichtet ... Konfigurationsdatei »/etc/bitwarden_rs/config.env« ==> Geändert (von Ihnen oder von einem Skript) seit der Installation. ==> Paketverteiler hat eine aktualisierte Version herausgegeben. Wie möchten Sie vorgehen? Ihre Wahlmöglichkeiten sind: Y oder I : Die Version des Paket-Betreuers installieren N oder O : Die momentan installierte Version beibehalten D : Die Unterschiede zwischen den Versionen anzeigen Z : Eine Shell starten, um die Situation zu begutachten Der Standardweg ist das Beibehalten der momentanen Version. *** config.env (Y/I/N/O/D/Z) [Vorgabe=N] ? N Warnung: Das von Ihnen angegebene Home-Verzeichnis /var/lib/bitwarden_rs existie rt bereits. Der Systembenutzer »bitwarden« existiert bereits. Programmende.Danach

bitwarden:~# systemctl restart bitwarden_rs.service Warning: The unit file, source configuration file or drop-ins of bitwarden_rs.service changed on disk. Run 'systemctl daemon-reload' to reload units. bitwarden:~# systemctl daemon-reload bitwarden:~# systemctl restart bitwarden_rs.service -

schrieb am 22. Apr. 2022, 13:02 zuletzt editiert von

Achtung: Die vorliegende Version funktioniert aktuell nicht unter Ubuntu 22.04!

-

schrieb am 28. Apr. 2022, 06:18 zuletzt editiert von

Moin,

wird auch ein aktualisiertes Update auf die Version 2.28.0 bereitgestellt? -

schrieb am 28. Apr. 2022, 17:08 zuletzt editiert von

@hase567 Ich glaube Du verwechselst da was. Die Bitwarden_RS (vaultwarden) Version 1.24.0 ist aktuell und dani-garcia hat noch keine neue Version veröffentlicht. https://github.com/dani-garcia/vaultwarden/releases

Du meinst mit Version 2.28.0 das Original. Das wird dann vermutlich die Vorlage für das nächste Release vom dani-garcia.

Ich denke, da müssen wir uns noch etwas in Geduld üben.

-

schrieb am 17. Mai 2022, 17:54 zuletzt editiert von Nico

Es gibt mal wieder ein Update - aber keine neue Version!

Was hat es damit auf sich?Das Paket "bitwarden-rs" ist jetzt nur noch ein Metapaket mit einer Abhängigkeit auf das neue Paket "vaultwarden". Beim nächsten Update ("apt update && apt upgrade") wird also Bitwarden_rs durch Vaultwarden ersetzt.

Die Konfiguration und das Datenverzeichnis werden dabei vollständig migriert.

Übrig bleiben lediglich die Verzeichnisse /etc/bitwarden_rs und /var/lib/bitwarden_rs, die nach erfolgreichem Test manuell gelöscht werden können.Neue Installationen (auch über das Paket "bitwarden-rs") installieren ab sofort immer Vaultwarden.

Die Ubuntu 22.04 Kompatibilität ist nicht gelöst und damit meine nächste Baustelle...