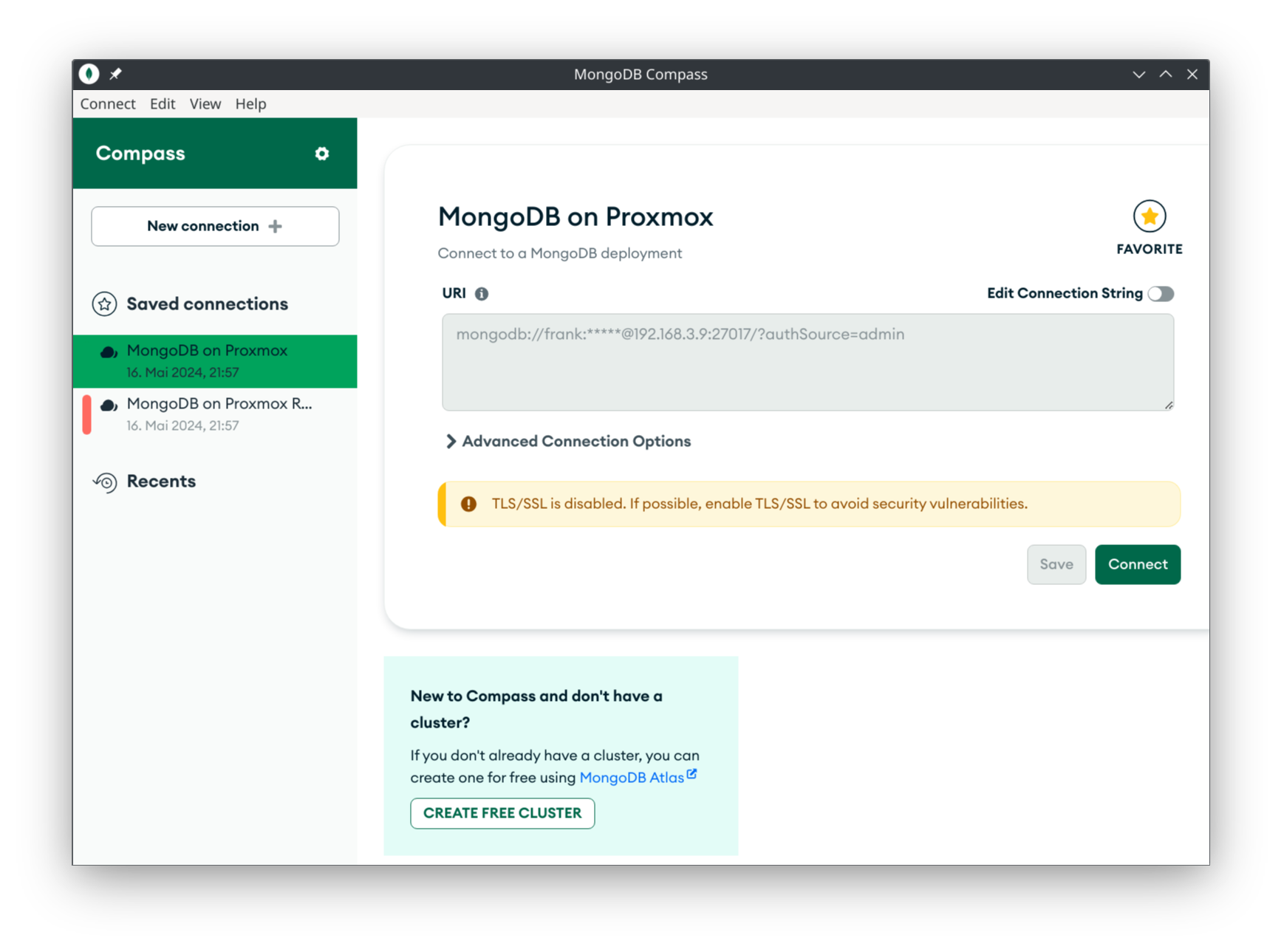

Restic - Backblaze B2 Cloud Storage

-

Dank eines Tipps, viele Grüße nach Hamburg

, teste ich heute mal Restic in Zusammenarbeit mit dem Cloud Anbieter Backblaze B2. Da Backblaze ein amerikanischer Anbieter ist, scheidet ein Speichern von Daten im Klartext logischerweise aus. Also muss mindestens was nett verschlüsseltes her, so was wie AES256.

, teste ich heute mal Restic in Zusammenarbeit mit dem Cloud Anbieter Backblaze B2. Da Backblaze ein amerikanischer Anbieter ist, scheidet ein Speichern von Daten im Klartext logischerweise aus. Also muss mindestens was nett verschlüsseltes her, so was wie AES256.Ok, das kann Restic

Restic is built to secure your data against such attackers, by encrypting it with AES-256 in counter mode and authenticating it using Poly1305-AES.

Quelle: https://restic.net/Account erstellen

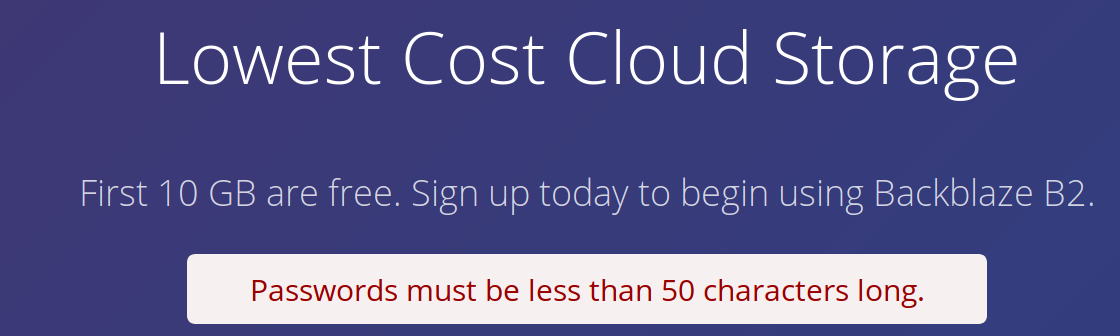

Wollte mich anmelden, das erste was passiert ist folgendes...

Ok, dann nur 49 Zeichen

Danach kommt eine Abfrage bzgl. der Telefonnummer. Danach kann man die 2FA einstellen.

Danach kommt eine Abfrage bzgl. der Telefonnummer. Danach kann man die 2FA einstellen.

Man kann zwischen SMS und Google Authenticator/Authy wählen. Alles in allem sieht das sehr gut aus. Denke da kann man was ablegen LOLDamit haben wir das erledigt.

Bucket erstellen

Wir legen ein Bucket an, darauf achten das er auf Privat steht! Auch wenn die Daten verschlüsselt sind

Ok, die Namen müssen wohl über die komplette Cloud einmalig sein, die ersten zwei getesteten Namen gab es schon.

Ok, die Namen müssen wohl über die komplette Cloud einmalig sein, die ersten zwei getesteten Namen gab es schon.frank-restic-backupDen nicht

Application Keys erstellen

Wir brauchen aber mal zu erst, die Application Keys. Dazu kann man auf Backblaze auf App-Keys gehen, dort auf Add a New Application Key klicken. Dann vergeben wir einen Namen, wählen das Bucket aus, für den die Keys gelten. Danach auf Create New Key und die Keys notieren!

Test Repo erzeugen

Ich benutze hier ein File /root/passwd worin das gewünschte Passwort abgelegt ist. Denkt an die Rechte, so wenig wie möglich

$ export B2_ACCOUNT_ID="<ApplicationID>" $ export B2_ACCOUNT_KEY="<ApplicationKEY>"Da oben die ApplicationID und den ApplicationKEY eingeben!

Init

restic --password-file /root/passwd -r b2:frank-restic-backup initDann kommt folgendes

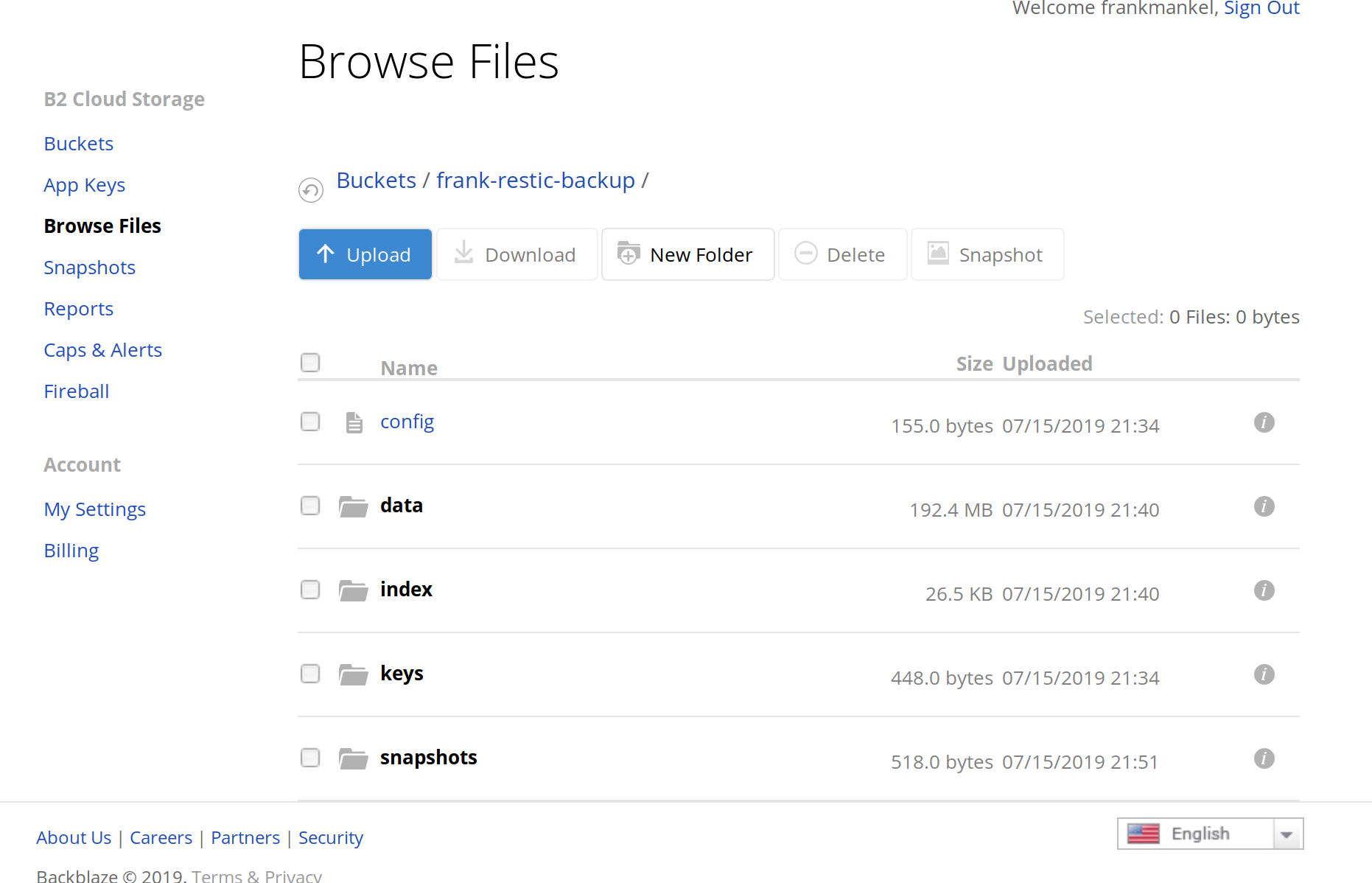

root@debian:~# restic -r b2:frank-restic-backup init enter password for new repository: enter password again: created restic repository f9419b33bc at b2:frank-restic-backup Please note that knowledge of your password is required to access the repository. Losing your password means that your data is irrecoverably lost.Damit wäre das Repository auf Blackbaze erzeugt. Jetzt können wir dort ein paar Daten zum Testen ablegen.

root@debian:~# restic --password-file /root/passwd -r b2:frank-restic-backup backup /home/frank/Bilder repository f9419b33 opened successfully, password is correct created new cache in /root/.cache/restic Files: 68 new, 0 changed, 0 unmodified Dirs: 2 new, 0 changed, 0 unmodified Added to the repo: 183.462 MiB processed 68 files, 183.461 MiB in 5:49 snapshot 6dc27047 savedGut zum Testen was kleines und hier direkt der Hinweis, für Server ist das sicherlich besser geeignet. Der Upload ist ja zu Hause meistens ein Flaschenhals. Aber, wir sehen, es funktioniert.

Restic Script erstellen

Ich habe ja schon ein paar Cronjobs Laufen, so das ich jetzt eines dieser Scripte nehme und es modifiziere.

#!/bin/bash # Script um mit Restic Daten automatisiert zu sichern! # Hier sichern wir das Bilderverzeichnis auf ein Backblaze Bucket! export B2_ACCOUNT_ID="ApplicationID" export B2_ACCOUNT_KEY="ApplicationKey" #Was soll gesichert werden? backup_pfad=/home/frank/Bilder #Programm Start restic --password-file /root/passwd -r b2:frank-restic-backup backup --verbose $backup_pfadMittels --exclude-file=excludes.txt am Ende könnt ihr noch Verzeichnisse vom Sichern ausklammern.

Backblaze.com hat eine gute Anleitung, schaut auf alle Fälle mal rein.

https://help.backblaze.com/hc/en-us/articles/115002880514-How-to-configure-Backblaze-B2-with-Restic-on-LinuxTest des Scriptes

root@debian:~# ./backblaze.sh open repository repository f9419b33 opened successfully, password is correct lock repository load index files using parent snapshot 6dc27047 start scan on [/home/frank/Bilder] start backup on [/home/frank/Bilder] scan finished in 2.652s: 68 files, 183.461 MiB Files: 0 new, 0 changed, 68 unmodified Dirs: 0 new, 0 changed, 2 unmodified Data Blobs: 0 new Tree Blobs: 0 new Added to the repo: 0 B processed 68 files, 183.461 MiB in 0:03 snapshot e72e0f67 savedIch hoffe, dem ein oder anderen habe ich jetzt auf den Geschmack gebracht. Mir sind beim Schreiben dieser Zeilen ein paar Ideen gekommen, was ich dort sichern könnte

-

-

-

Wichtige Links

Angeheftet Ansible -

-

-

-

-

Restic - Ein Backupkonzept

Angeheftet Restic