OnRouteMap - Point of Interest (POI) für lange Radtouren

-

Heute mal etwas ganz anderes, eine Vorstellung eines Tools von einem guten Freund @Nico

Das könnte ja für den ein oder anderen sehr hilfreich sein, wo jetzt die Sommer Urlaubszeit beginnt bzw. schon im Gange ist.OnRouteMap | Finde POIs entlang deiner Route

OnRouteMap: Finde wichtige POIs entlang deiner GPX-Route. Perfekt für Radfahrer, Wanderer und Langstreckenläufer.

(onroutemap.de)

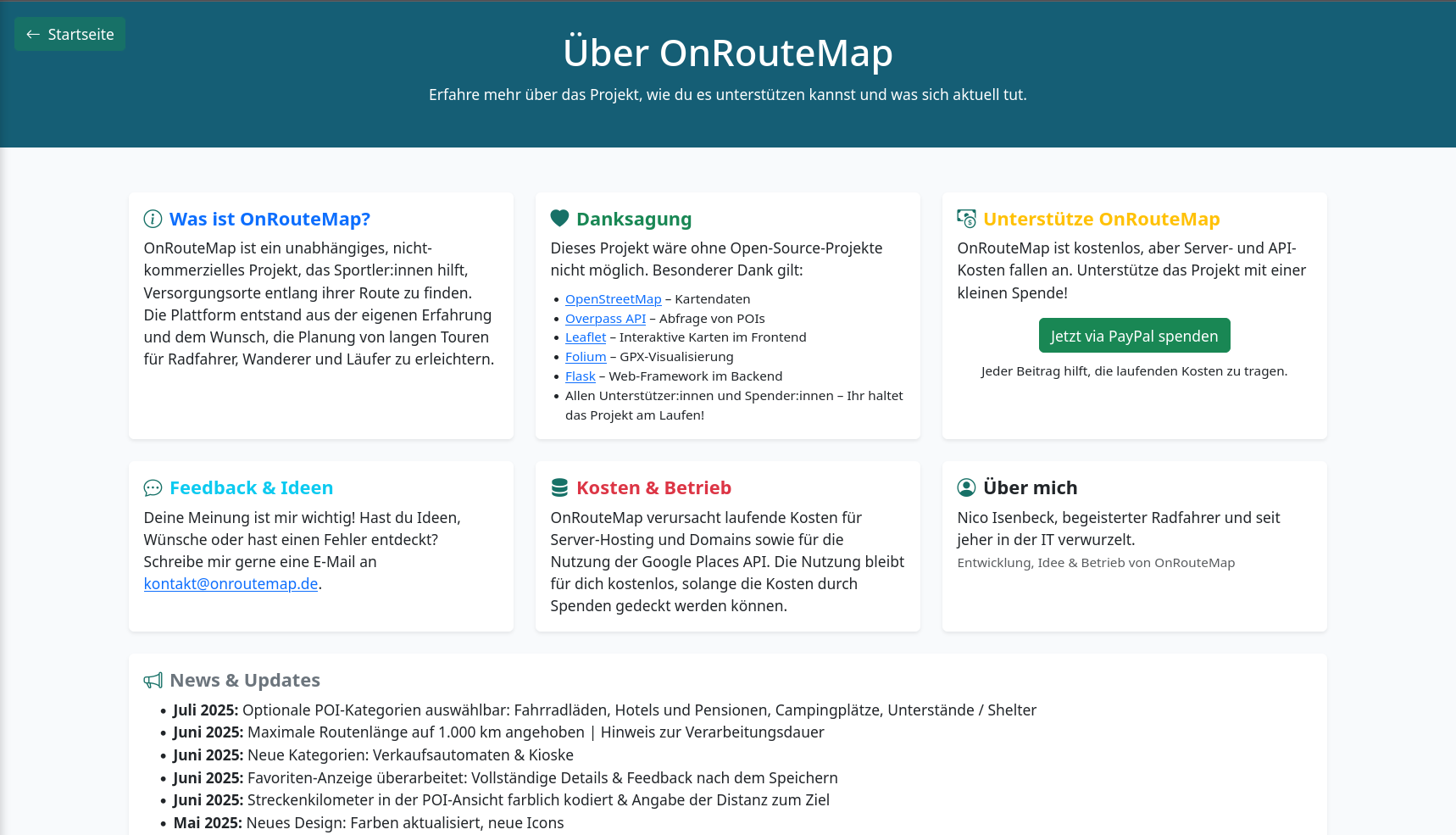

Was ist OnRouteMap?

OnRouteMap hilft Sportler:innen, die auf langen Strecken unterwegs sind, Verpflegung und Services zu finden. Einfach GPX-Datei hochladen, alle wichtigen Anlaufstellen wie Tankstellen, Cafés, Supermärkte und mehr entdecken und perfekt vorbereitet starten.

Egal ob du mit dem Rad fährst, wanderst oder läufst – ob Trainingsausfahrt, Bikepacking-Abenteuer, Bergtour oder die Wanderung deines Lebens, OnRouteMap macht dich startklar.

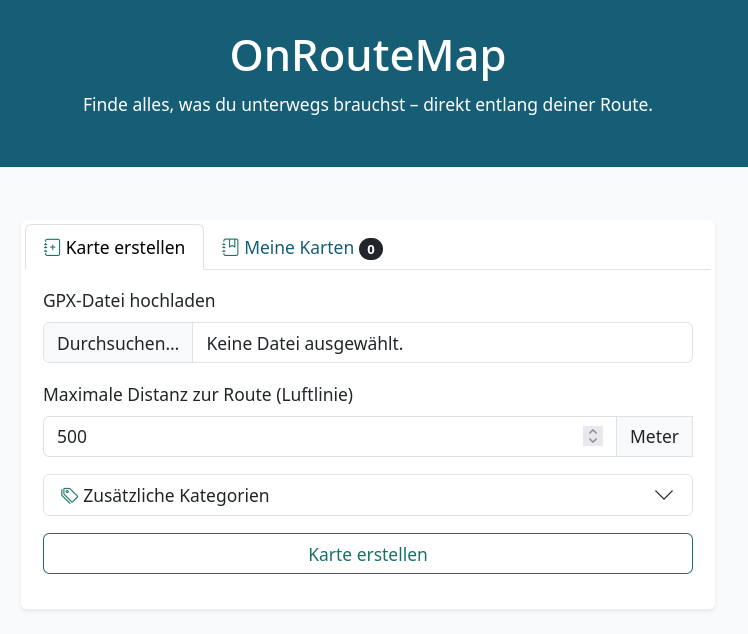

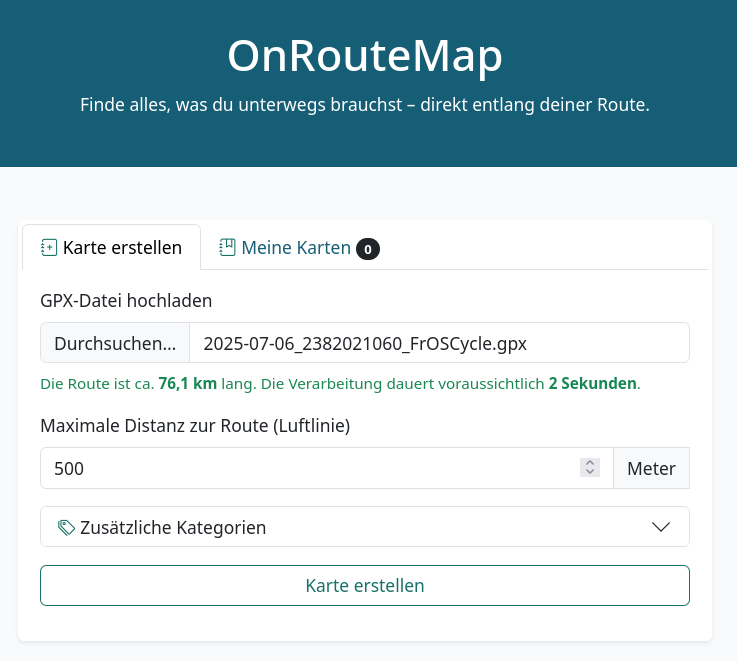

Startseite

Route erstellen

Man nimmt also eine vorhandene Datei und fügt sie z.B. per Drag and Drop hinzu. Dann bekommt man direkt ein paar Infos angezeigt.

Die Route ist 76,1 km lang und die Berechnung der Points of Interest (POI) dauert 2 Sekunden.

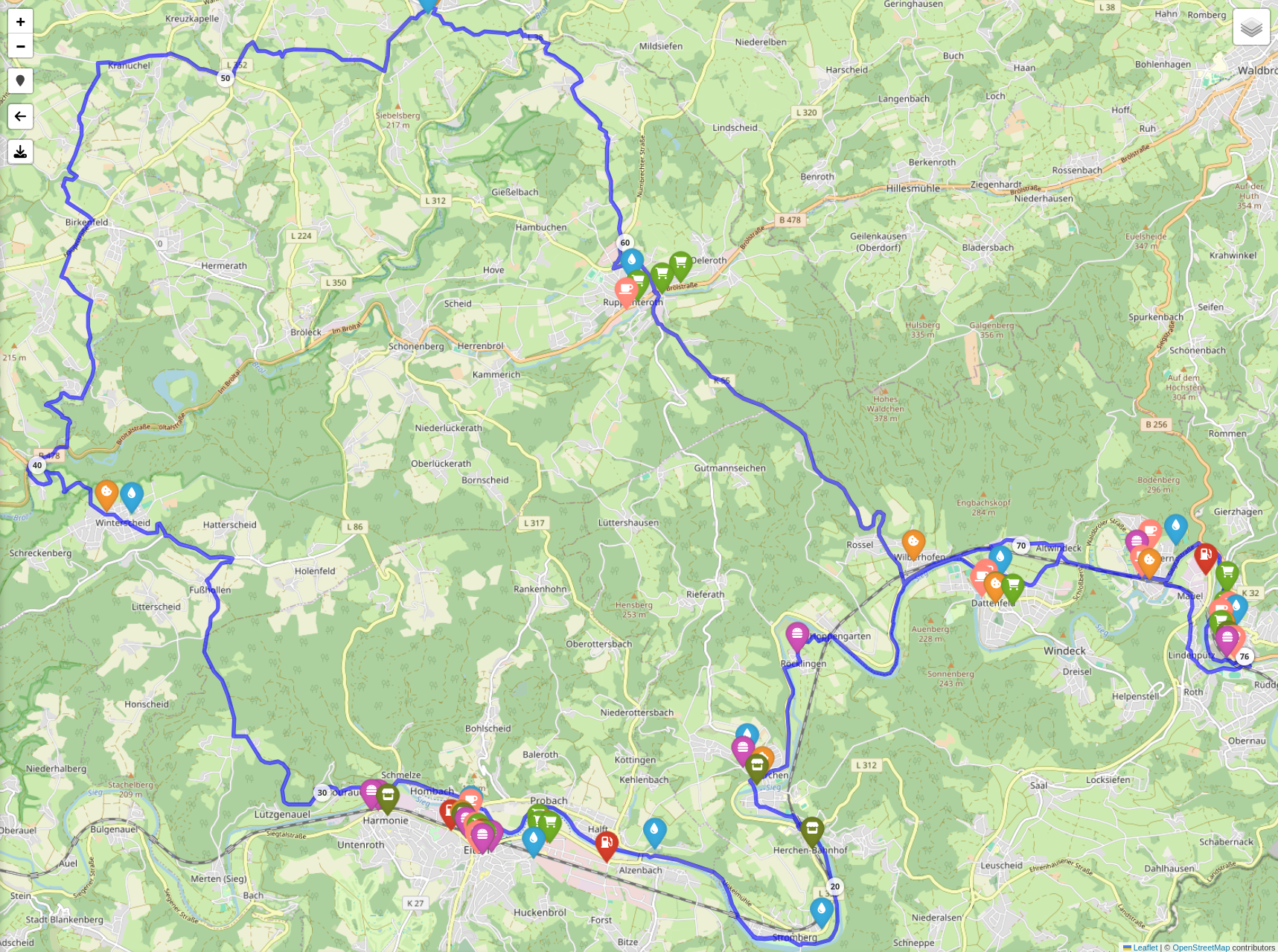

Karte erstellen

Dann drücke ich mal auf den Button Karte erstellen. Überrascht war ich, das die 2 Sekunden wirklich passen.

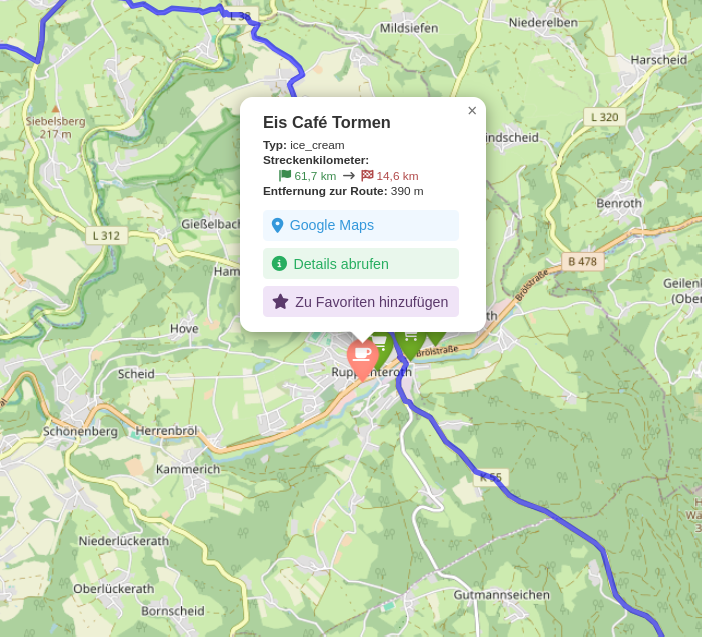

Wenn man jetzt auf einen POI klickt, bekommt man mehr Infos dazu.

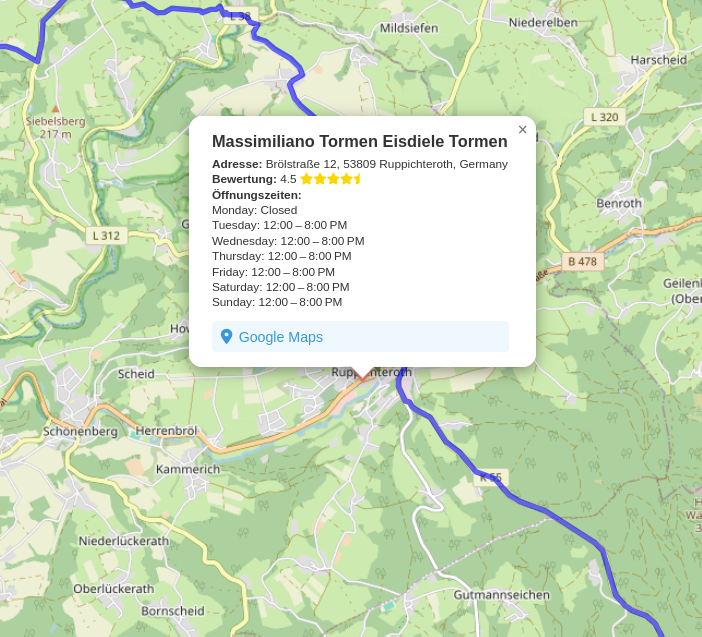

Wenn man auf Details abrufen klickt, bekommt man ganz viele Details dazu angezeigt.

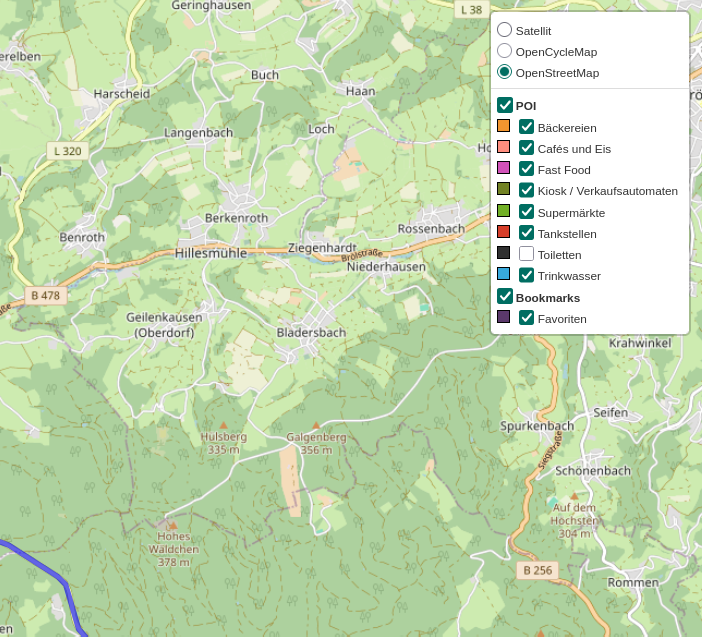

Oben rechts im Hamburger Menü findet man folgendes.

Karten

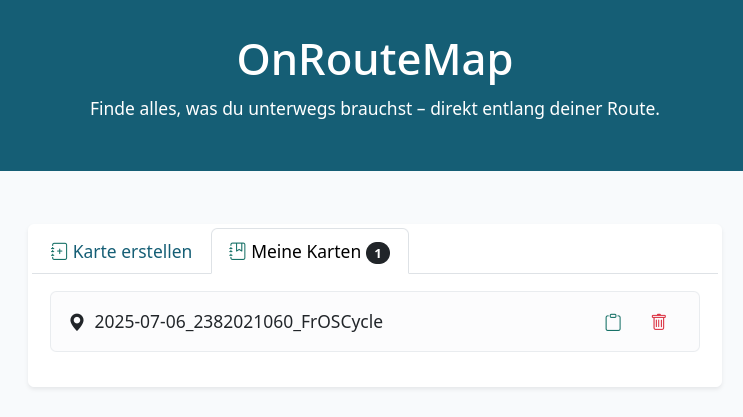

Nachdem Du eine Route erstellt hast, werden diese im Hauptmenü auf dem Reiter Meine Karten angezeigt.

Zum Speichern wird der local storage des Webbrowsers benutzt. Der Serverbetreiber kann so deine Routen nicht sehen (datenschutzfreundlich)

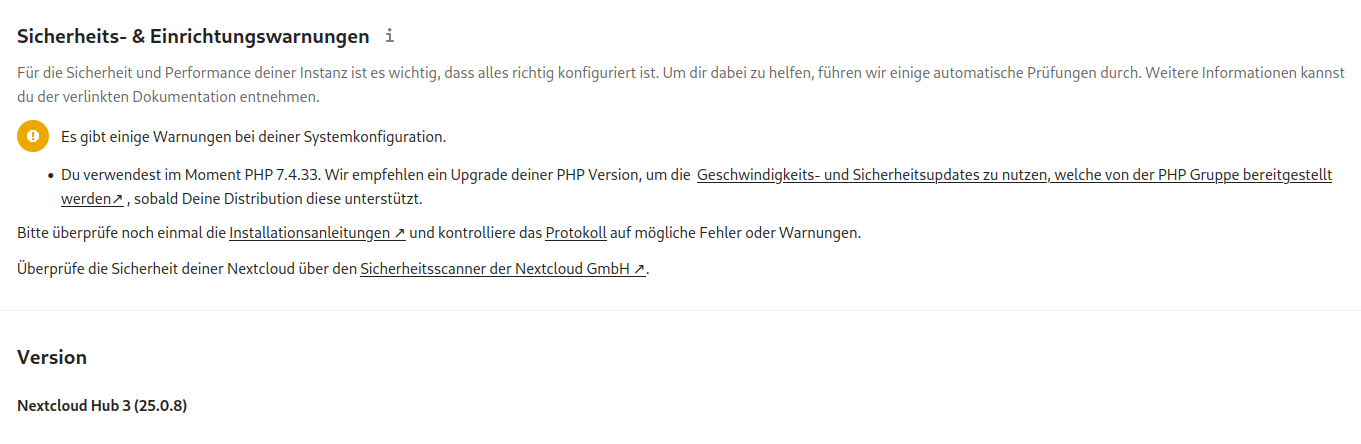

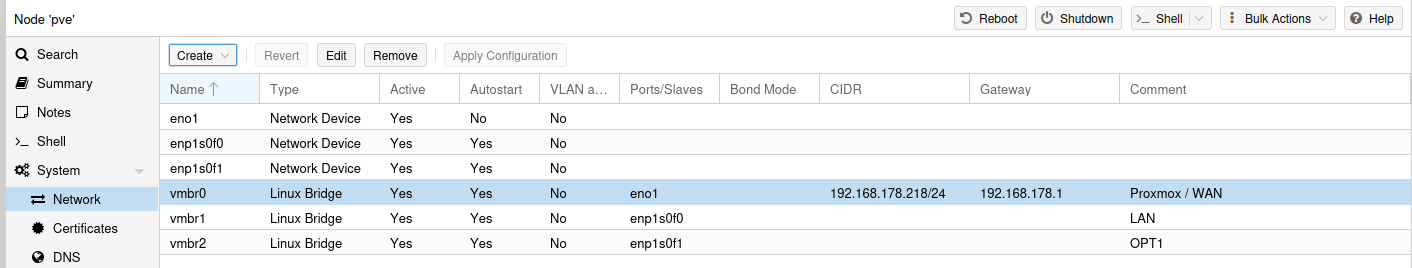

Die Technik

Die Webanwendung benutzt im Frontend Flask und im Backend Python. Schöner Debian Server mit Podman

Datenschutz

OnRouteMap | Impressum und Datenschutzerklärung

OnRouteMap: Finde wichtige POIs entlang deiner GPX-Route. Perfekt für Radfahrer, Wanderer und Langstreckenläufer.

(onroutemap.de)

Erhebung und Speicherung von personenbezogenen Daten

Wir erheben und speichern auf dieser Website keine personenbezogenen Daten.

Es werden keine Logdateien der Webseitenaufrufe erstellt.Kosten

Das Projekt ist aktuell kostenlos. Da es, wie jedes Tool im Netz Kosten verursacht, wird dafür auch Geld benötigt. Aktuell wird das über Spenden finanziert. Der @Nico würde sich über jede kleine Spende freuen, die Benutzer des Tools ihm zukommen lassen.

Fragen zum Projekt

Solltet ihr Fragen oder Anregungen zum Projekt haben, bin ich mir sicher wird der @Nico die hier gerne beantworten.

-

-

-

-

-

-

-

Redis Replication

Angeheftet Verschoben Redis -