Projekt NAS - BIOS Update 1.25.0

Dieses Thema wurde gelöscht. Nur Nutzer mit entsprechenden Rechten können es sehen.

-

Heute ist Update-Tag

Das BIOS von meinem NAS mal auf Vordermann gebracht. Dazu auch direkt den neuen Kernel installiert, einmal durchgestartet - läuft.

Das BIOS von meinem NAS mal auf Vordermann gebracht. Dazu auch direkt den neuen Kernel installiert, einmal durchgestartet - läuft.

uname -a Linux nas 4.9.0-6-amd64 #1 SMP Debian 4.9.82-1+deb9u3 (2018-03-02) x86_64 GNU/LinuxUnd eben gesehen, das das NAS schon seit Oktober 2016 läuft. (24/7) Gute Investition, bin absolut zufrieden damit.

Im Fediverse -> @FrankM@nrw.social

- NanoPi R5S

- Quartz64 Model B, 4GB RAM

- Quartz64 Model A, 4GB RAM

- RockPro64 v2.1

-

Forgejo-Runner

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Forgejo forgejo linux podman 4

0 Stimmen1 Beiträge205 Aufrufe

4

0 Stimmen1 Beiträge205 Aufrufe -

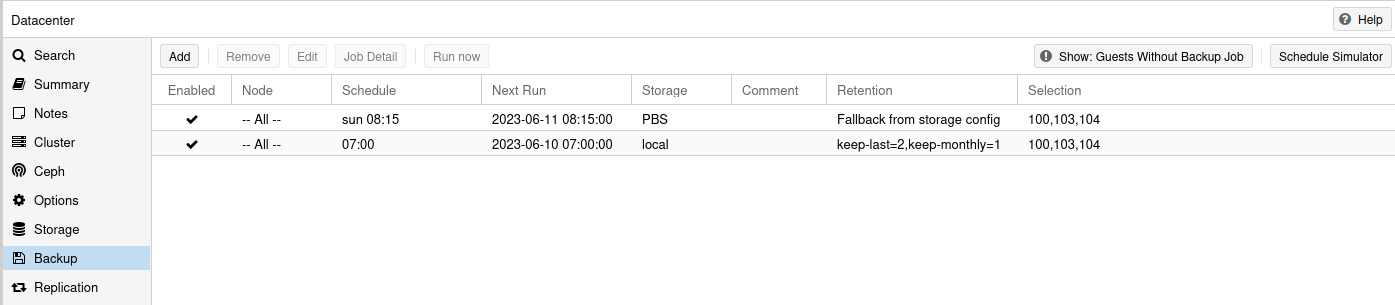

NAS 2023 - Thema Datensicherung

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux proxmox linux 2

0 Stimmen2 Beiträge219 Aufrufe

2

0 Stimmen2 Beiträge219 Aufrufe -

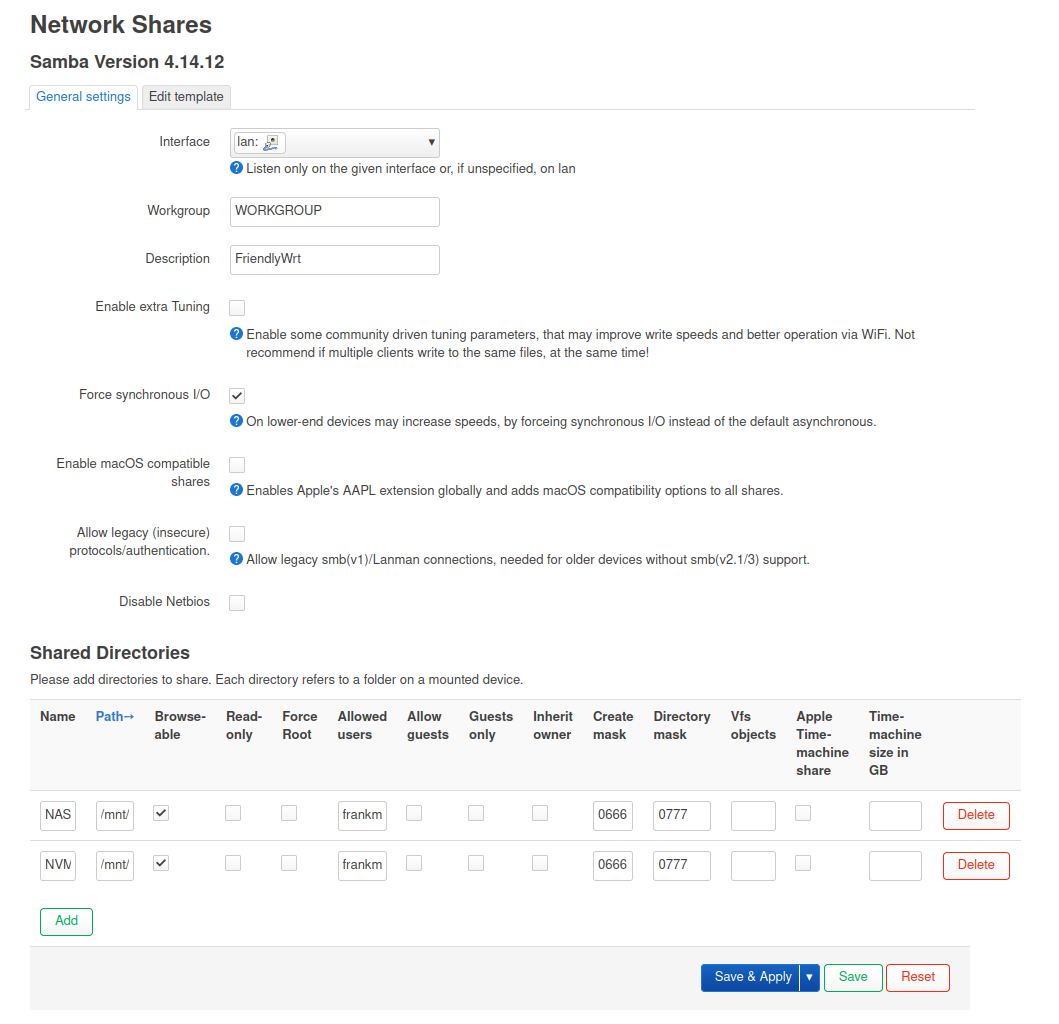

NanoPi R5S - Samba

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben NanoPi R5S nanopir5s linux 1

0 Stimmen5 Beiträge525 Aufrufe

1

0 Stimmen5 Beiträge525 Aufrufe -

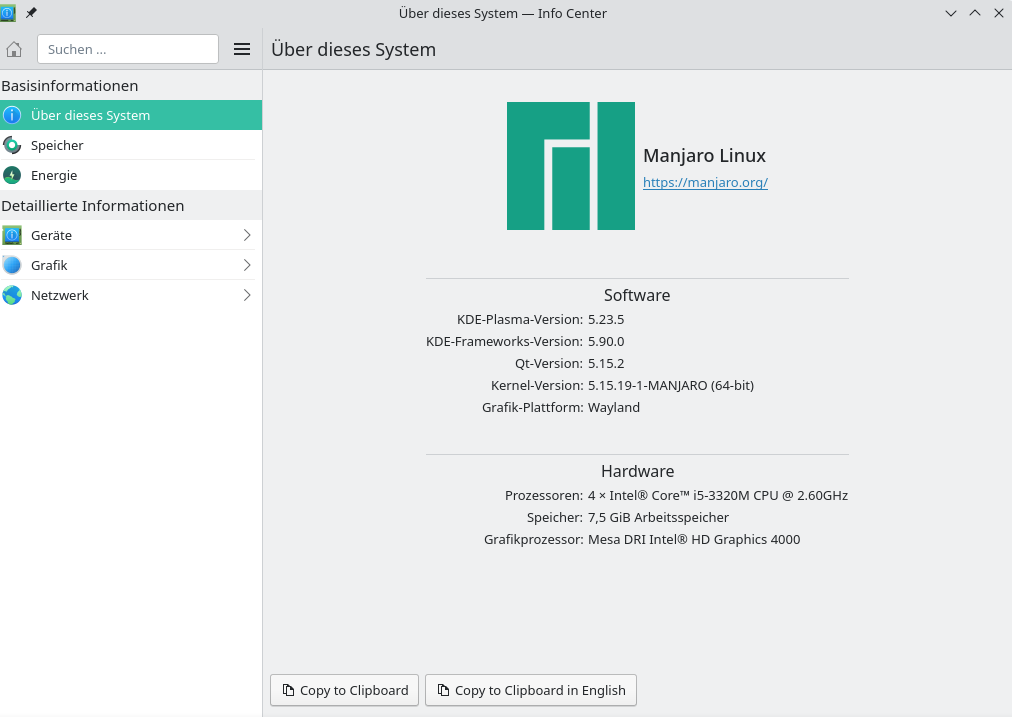

Manjaro KDE Plasma 21.2.2

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux linux manjaro 2

0 Stimmen5 Beiträge354 Aufrufe

2

0 Stimmen5 Beiträge354 Aufrufe -

ZFS - Wichtige Befehle

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux zfs linux0 Stimmen3 Beiträge1k Aufrufe -

WLan auf der Konsole einrichten

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Linux linux quartz64 rockpro640 Stimmen3 Beiträge719 Aufrufe -

Redis Replication

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben Redis linux redis1 Stimmen4 Beiträge618 Aufrufe -

[HOWTO] Verschlüsseltes NAS aufsetzen

Beobachtet Ignoriert Geplant Angeheftet Gesperrt Verschoben ROCKPro64 howto linux rockpro640 Stimmen12 Beiträge3k Aufrufe