ROCKPro64 - Armbian - NAS umgezogen

-

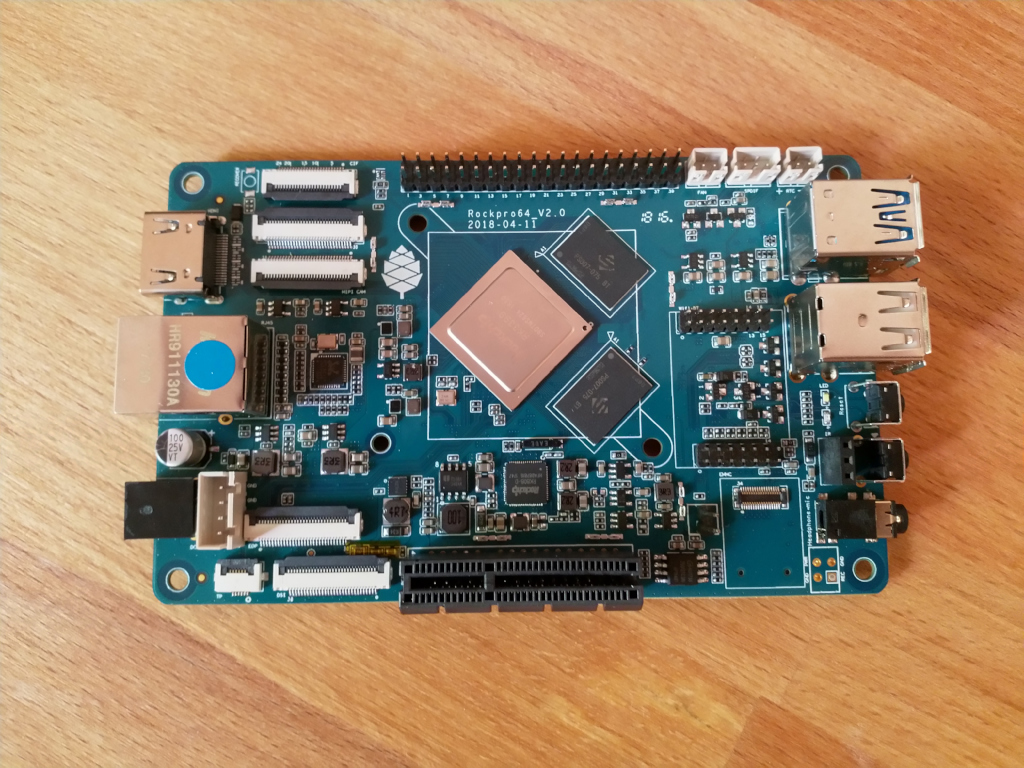

Wie ja einige wohl schon mitbekommen haben, stehe ich im Moment mehr auf Armbian und das hat eigentlich nur einen einzigen Grund - die USB3 Schnittstelle!

Da ich für einen Job diese USB3-Schnittstelle mit einer HDD bestücken möchte, musste ich dafür extra einen ROCKPro64 mit Armbian laufen lassen. Mein NAS lief mit einem 4.19er Ayufan Kernel (ohne Probleme). Wie schön wäre es jetzt, wenn an dem NAS die USB3 HDD dran hängen würde.

Wenn man jetzt nachdenkt, bleibt nur eine Lösung. Das NAS braucht ein Armbian als Betriebssystem. Ok, ran an die Arbeit.

Ich hatte ein Armbian so weit vorbereitet, das übliche mit User, IP-Adresse usw. Das NAS runtergefahren und die neue SD-Karte rein. Das NAS gestartet und dann tauchte dieses Problem mit meinem RAID auf. Die Geschichte ist was länger

https://forum.frank-mankel.org/topic/421/raid1-platte-verschwundenOk, ein Tag verloren aber das NAS ist wieder stabil

root@rockpro64_NAS:~# mdadm --detail /dev/md0 /dev/md0: Version : 1.2 Creation Time : Sat Oct 20 07:05:51 2018 Raid Level : raid1 Array Size : 1953379392 (1862.89 GiB 2000.26 GB) Used Dev Size : 1953379392 (1862.89 GiB 2000.26 GB) Raid Devices : 2 Total Devices : 2 Persistence : Superblock is persistent Intent Bitmap : Internal Update Time : Thu Dec 27 12:17:39 2018 State : clean Active Devices : 2 Working Devices : 2 Failed Devices : 0 Spare Devices : 0 Name : rockpro64v_2_1:0 UUID : 33ac7964:473fe590:3682dd85:a979b336 Events : 57884 Number Major Minor RaidDevice State 2 253 0 0 active sync /dev/dm-0 1 253 1 1 active sync /dev/dm-1 root@rockpro64_NAS:~# cat /proc/mdstat Personalities : [linear] [multipath] [raid0] [raid1] [raid6] [raid5] [raid4] [raid10] md0 : active raid1 dm-1[1] dm-0[2] 1953379392 blocks super 1.2 [2/2] [UU] bitmap: 0/15 pages [0KB], 65536KB chunk unused devices: <none>Mal für alle, die evt. mit dem gedanken spielen sich einen PCIe SATA Adapter kaufen wollen, ja er hat den Sync problemlos durchgezogen. 10 Stunden! Angeschlossen sind an diesem Adapter zwei 1,8 TB große 2,5 Zoll HDDs.

Aktuell nutze ich folgendes Armbian

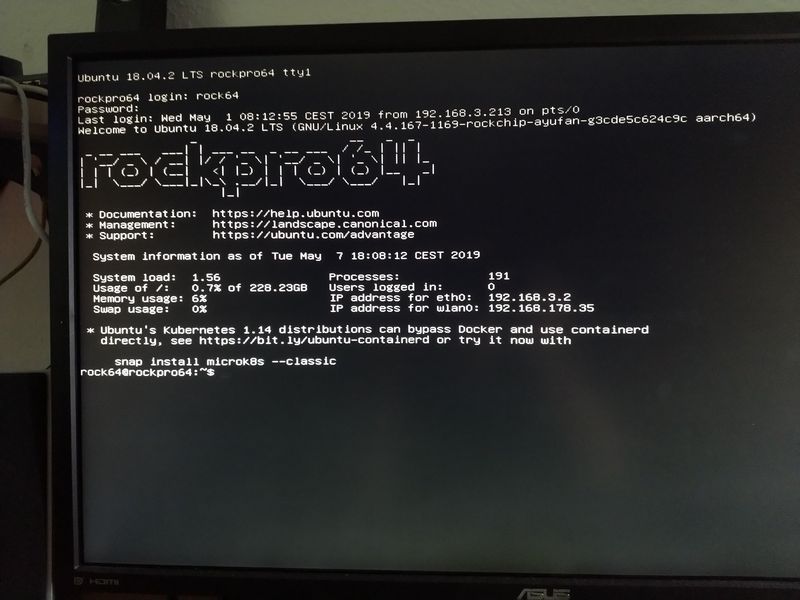

frank@frank-MS-7A34:~$ ssh root@192.168.3.207 root@192.168.3.207's password: ____ _ ____ __ _ _ | _ \ ___ ___| | _| _ \ _ __ ___ / /_ | || | | |_) / _ \ / __| |/ / |_) | '__/ _ \ | '_ \| || |_ | _ < (_) | (__| <| __/| | | (_) | | (_) |__ _| |_| \_\___/ \___|_|\_\_| |_| \___/ \___/ |_| Welcome to ARMBIAN 5.67 stable Debian GNU/Linux 9 (stretch) 4.4.166-rockchip64 System load: 0.85 0.22 0.08 Up time: 0 min Memory usage: 4 % of 1991MB IP: 192.168.3.207 CPU temp: 37°C Usage of /: 16% of 15GJa, ich denke auf dem NAS ist die stable die bessere Wahl

Es gibt dort jetzt ein verschlüsseltes RAID 1 mit zwei 1,8TB Platten am SATA Controller. Am USB3 Port hängt eine 1,8TB HDD. So weit bin ich erst mal zufrieden.

Das NAS steht mir per NFS auf meinen anderen Rechnern zur Verfügung. Gewisse Cronjobs müssen Nachts dann ein paar Daten abholen und hier und dort hin kopieren. Das NAS steht ja die meiste Zeit sinnlos in der Ecke und verbraucht Strom, dann kann das auch nachts ein wenig arbeiten

Zum Schluss habe ich dann noch mittels hdparm den Platten beigebracht, das es nach einer eingestellten Zeit Feierabend ist und sich die HDDs schlafen legen.

Nun wird es Zeit das NAS wieder in den Schrank zu stellen und die nächsten Tage mal zu beobachten, ob alles so läuft wie es soll. Da ich Armbian vorher ausgiebig getestet habe, gehe ich im Moment davon aus. Aber, man weiß ja nie.....

Mich würde es freuen, wenn Kamil mal wieder Zeit hätte, aber es ist schön das es jetzt auch Armbian gibt. Was man jetzt noch bräuchte, wäre einen Mainline Kernel von Armbian. Ich bin mir sicher, das kommt auch noch.

-

Das NAS mit den drei 2,5 Zoll HDD Platten läuft an einem 3A Netzteil - ohne Probleme. Hat heute Nacht die Jobs einwandfrei erledigt

PINE64 Community

PINE64 is a large, vibrant and diverse community and creates software, documentation and projects. Founded in 2015, it is known for affordable devices that promote user freedom.

PINE64 (www.pine64.org)

-

-

-

-

-

-

Benchmark Mainline 4.17.0-rc6

Verschoben Archiv -

-

Images 0.6.x

Verschoben Images