FreeOTP+

-

schrieb am 27. März 2021, 09:02 zuletzt editiert von

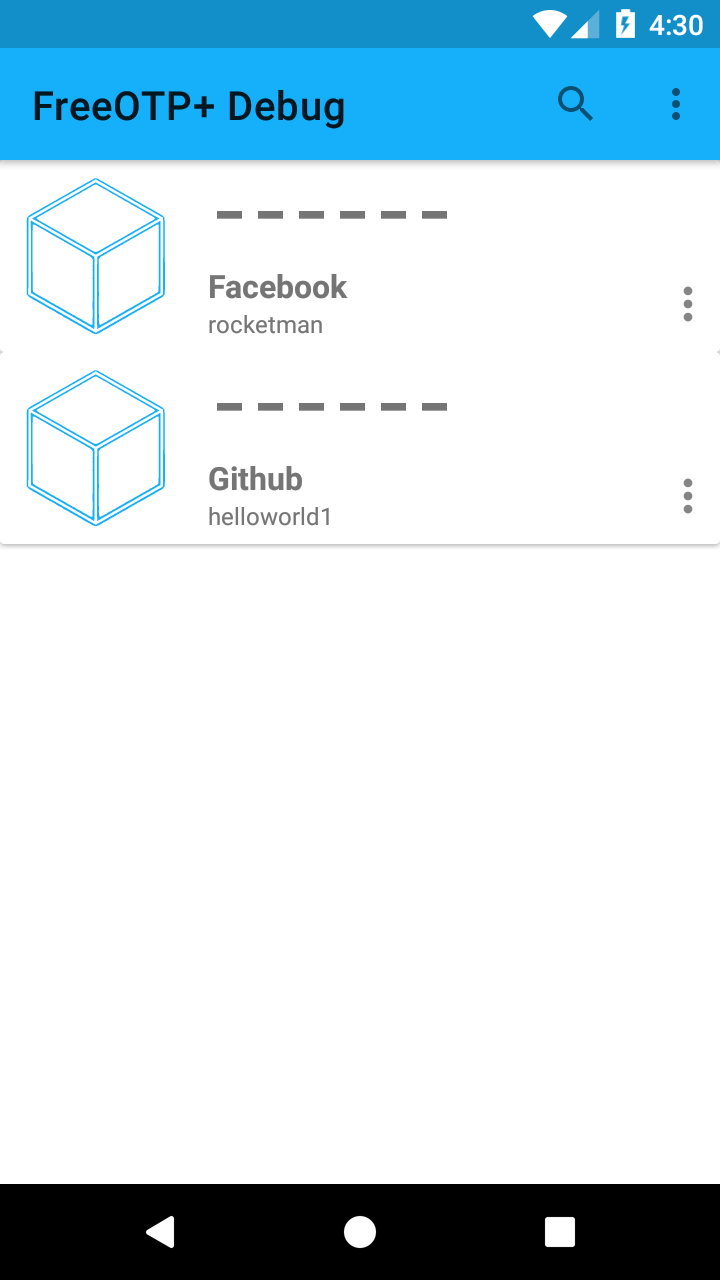

Am Anfang hatte ich den Google Authenticator genutzt. Irgendwann wurden dann bei mir viele Google Dienste entfernt. Danach habe ich Authy benutzt. Bei einem Vortrag auf den letzten Chemnitzer Linux Tagen dann FreeOTP+ kennen gelernt.

Warum ich Euch das erzähle? Ich habe ein neues Smartphone und damit fingen die Probleme an.

Ich musste Authy umziehen, das erwies sich aber als nicht lösbare Aufgabe - für mich. Hintergrund ist wohl ein SIM Card Wechsel, was nun zu einer falschen Telefonnummer führte. Alle angebotenen Lösungswege von Authy führten nicht zum Erfolg.

Ok, Authy funktionierte noch auf dem alten Smartphone, so das ich alles umziehen konnte. Ein relativ hoher Aufwand, wenn man viele Dienste so sichert. Und ich nutze das bei sehr vielen Diensten...

FreeOTP+ hatte ich schon vor dem Neukauf mal ausprobiert, aber nicht wirklich genutzt. Das soll jetzt in Zukunft anders werden, hier warum...

Bildquelle: https://play.google.com/store/apps/details?id=org.liberty.android.freeotpplus&hl=en_US&gl=USIch habe also mühsam alle meine Token umgezogen, dazu musste ich dann im entsprechenden Dienst den 2FA deaktivieren und wieder neu erstellen. Gut, so konnte man direkt testen, ob das auch alles noch klappt.

Nachdem ich dann die wichtigsten Dienste umgezogen hatte, stellte sich die Frage

Wie verhindere ich das beim nächsten Mal!??

FreeOTP+ hat dazu Export Funktionen. Damit kann man sich die Daten z.B. als JSON exportieren lassen. Das habe ich dann mal ausprobiert. JSON läßt sich mit dem Tool jq übrigens prima anzeigen.

jq - Leichtgewichtiger und flexibler JSON-Prozessor für die Kommandozeile

apt install jqHier mal ein kleiner Einblick.

frank@:~$ jq . /home/frank/Schreibtisch/freeotp-backup.json { "tokenOrder": [ "GitHub:ACCOUNT", .... ], "tokens": [ { "algo": "SHA1", "counter": 0, "digits": 6, "issuerExt": "GitHub", "issuerInt": "GitHub", "label": "ACCOUNT", "period": 30, "secret": [ 99, 99, 99, 99, 99, 99, 99, 99, 99, 82 ], "type": "TOTP" },So, sieht das dann aus. Das kann man dann in einem anderen FreeOTP+ wieder importieren. Damit wir das auch wissen, habe ich das kurz mal auf dem alten Smartphone gegen geprüft. Funktioniert einwandfrei.

Somit wieder ein kommerzielles cloudbasiertes Tool, wo ich keine Kontrolle habe, weniger im Einsatz

-

schrieb am 28. März 2025, 10:04 zuletzt editiert von

Alles richtig gemacht

Das ging mir letztes Jahr ähnlich und ich bin begeistert von FreeOTP+ > weil sich Plattformübergreifend meine Tokens importieren ließen. Kein Vergleich zu dem kommerziellen Schrott, wie Google oder Authy, bei denen man, wenn nicht bereits nicht mehr funktionsfähig aus diversen Gründen, so zumindest immer in Gefahr ist, dass plötzlich aufgrund einer neuen Regelung, der Dienst oder die Software abgeschaltet ist. So ging es mir bei Authy auf meinem Linux-Rechner.

Nun, es war Anstoss etwas wesentlich besseres zu finden!

Grüße an Alle,

und herzlichen Dank an alle fleißigen Entwickler, die unser Leben besser machen! -

schrieb am 29. März 2025, 15:29 zuletzt editiert von

Falls mal jemand von FreeOTP+ zum Bitwarden Authenticator wechseln möchte, ich habe da mal was gebaut

freeotpplus-export-to-bitwarden-authenticator

freeotpplus-export-to-bitwarden-authenticator

Forgejo: Beyond coding. We Forge. (forgejo.linux-nerds.org)