NodeBB - v3.3.0

NodeBB

1

Beiträge

1

Kommentatoren

160

Aufrufe

-

schrieb am 16. Aug. 2023, 18:39 zuletzt editiert von

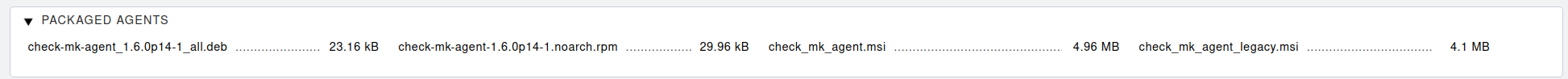

Wieder ganz viel neu, zum Nachlesen hier hin.

Das mit dem Chat hab ich mal getestet. Den findet man ->

Ist nur für registrierte Benutzer sichtbar.