Debian 11 Bullseye released!

-

Heute wird Debian 11 Bullseye released. Man konnte den ganzen Tag mitlesen wie das so läuft. Und dort kamen auch ein paar Info's was so alles neu ist.

- neues ipp-usb Paket für treiberloses Drucken über USB

- neuer "Open" Befehl der weiß was er mit dem File machen soll (ich bin gespannt..)

- nächster Testzweig heißt "Bookworm"

- "systemd persistent journal" ist aktiv, es läuft neben dem normalen logging.

- treiberloses scannen mit "sane-airscan"

- erster Kernel mit exFAT Filesystem

Releasing Debian 11 doesn't mean Debian 10 "buster" is abandoned. Debian supports the previous version for at least twelve months following a new release, before it moves to the LTS and eLTS teams for further maintenance #ReleasingDebianBullseye

Jetzt warten wir nur noch auf die Images

Debian -- The Universal Operating System

Debian is an operating system and a distribution of Free Software. It is maintained and updated through the work of many users who volunteer their time and effort.

(www.debian.org)

-

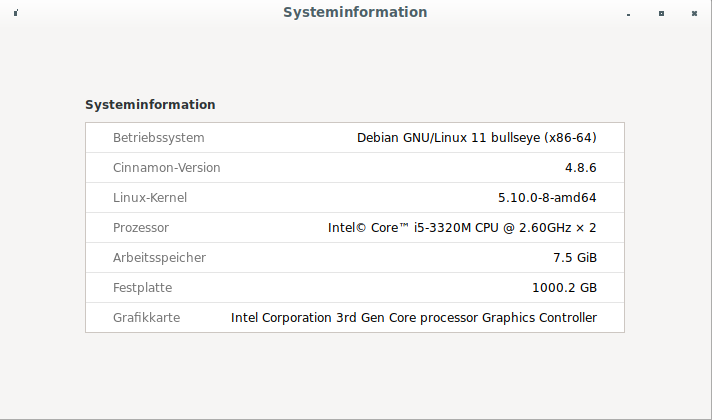

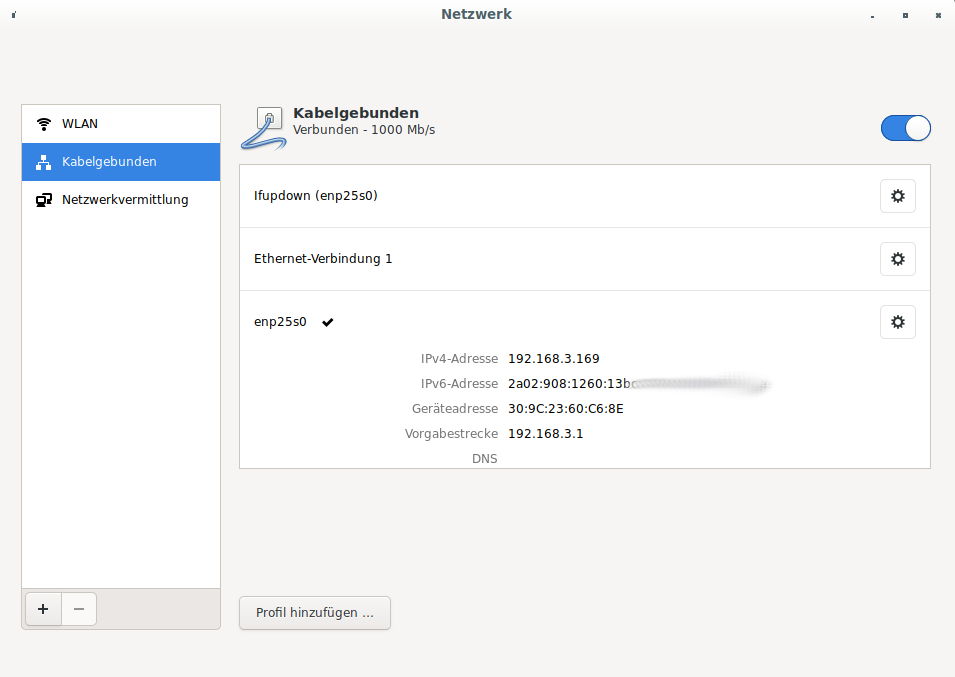

Auf meinem Zweit-PC mit dem Debian Netinstaller installiert. Nach dem Neustart die Grafiktreiber installiert (NVidia) und es lief. Als Desktop ist Cinnamon installiert. Dort fällt mir dann auf, das der Networkmanager keine Verbindung anzeigt.

Ok, für den USB WiFi Stick sind keine Treiber installiert, das ist klar. Aber auch keine LAN Verbindung, obwohl sie steht.

root@debian:~# ping 8.8.8.8 PING 8.8.8.8 (8.8.8.8) 56(84) bytes of data. 64 bytes from 8.8.8.8: icmp_seq=1 ttl=117 time=15.2 ms 64 bytes from 8.8.8.8: icmp_seq=2 ttl=117 time=13.5 ms ^C --- 8.8.8.8 ping statistics --- 2 packets transmitted, 2 received, 0% packet loss, time 1001ms rtt min/avg/max/mdev = 13.546/14.356/15.167/0.810 ms root@debian:~# ping www.google.de PING www.google.de(fra16s48-in-x03.1e100.net (2a00:1450:4001:80e::2003)) 56 data bytes 64 bytes from fra16s48-in-x03.1e100.net (2a00:1450:4001:80e::2003): icmp_seq=1 ttl=118 time=15.2 ms 64 bytes from fra16s48-in-x03.1e100.net (2a00:1450:4001:80e::2003): icmp_seq=2 ttl=118 time=13.3 ms ^C --- www.google.de ping statistics --- 2 packets transmitted, 2 received, 0% packet loss, time 1001ms rtt min/avg/max/mdev = 13.288/14.261/15.234/0.973 msGut, mal nachdenken...

-

Mein Systemadmin auf der Arbeit meinte heute, angesprochen auf das Problem, läuft der Network-Manager? Ok, gute Frage...... Schauen wir mal.

Ich bin mir leider nicht 100% sicher, ob er vor meinem Eingreifen lief, ich denke aber schon. Warum ich unsicher bin?

root@debian:~# systemctl enable systemd-networkd.service Created symlink /etc/systemd/system/dbus-org.freedesktop.network1.service → /lib/systemd/system/systemd-networkd.service. Created symlink /etc/systemd/system/multi-user.target.wants/systemd-networkd.service → /lib/systemd/system/systemd-networkd.service. Created symlink /etc/systemd/system/sockets.target.wants/systemd-networkd.socket → /lib/systemd/system/systemd-networkd.socket. Created symlink /etc/systemd/system/network-online.target.wants/systemd-networkd-wait-online.service → /lib/systemd/system/systemd-networkd-wait-online.service.Ok, danach

root@debian:~# systemctl start systemd-networkd.service root@debian:~# systemctl status systemd-networkd.service ● systemd-networkd.service - Network Service Loaded: loaded (/lib/systemd/system/systemd-networkd.service; enabled; ven> Active: active (running) since Tue 2021-08-17 17:36:38 CEST; 6s ago TriggeredBy: ● systemd-networkd.socket Docs: man:systemd-networkd.service(8) Main PID: 1288 (systemd-network) Status: "Processing requests..." Tasks: 1 (limit: 19087) Memory: 3.9M CPU: 39ms CGroup: /system.slice/systemd-networkd.service └─1288 /lib/systemd/systemd-networkd Aug 17 17:36:38 debian systemd[1]: Starting Network Service... Aug 17 17:36:38 debian systemd-networkd[1288]: enp25s0: Gained IPv6LL Aug 17 17:36:38 debian systemd-networkd[1288]: Enumeration completed Aug 17 17:36:38 debian systemd[1]: Started Network Service.Danach ging immer noch nix.

root@debian:/etc/network# ^C root@debian:/etc/network# nmcli device show GENERAL.DEVICE: wlx7cdd907cbec2 GENERAL.TYPE: wifi GENERAL.HWADDR: BA:59:C0:76:C7:F5 GENERAL.MTU: 1500 GENERAL.STATE: 20 (nicht verfügbar) GENERAL.CONNECTION: -- GENERAL.CON-PATH: -- GENERAL.DEVICE: enp25s0 GENERAL.TYPE: ethernet GENERAL.HWADDR: 30:9C:23:60:C6:8E GENERAL.MTU: 1500 GENERAL.STATE: 10 (nicht verwaltet) GENERAL.CONNECTION: -- GENERAL.CON-PATH: -- WIRED-PROPERTIES.CARRIER: an IP4.ADDRESS[1]: 192.168.3.169/24 IP4.GATEWAY: 192.168.3.1 IP4.ROUTE[1]: dst = 192.168.3.0/24, nh = 0.0.0.0, mt = 0 IP4.ROUTE[2]: dst = 0.0.0.0/0, nh = 192.168.3.1, mt = 0 IP6.ADDRESS[1]: 2a02:908:1260:13bc:329c:23ff:xxxx:xxxx/64 IP6.ADDRESS[2]: fd8a:6ff:2880:0:329c:23ff:fe60:c68e/64 IP6.ADDRESS[3]: fe80::329c:23ff:fe60:c68e/64 IP6.GATEWAY: fe80::e4d3:f0ff:fe8f:2354 IP6.ROUTE[1]: dst = fe80::/64, nh = ::, mt = 256 IP6.ROUTE[2]: dst = ::/0, nh = fe80::e4d3:f0ff:fe8f:2354, mt = 1024 IP6.ROUTE[3]: dst = 2a02:908:xxxx:xxxx::/64, nh = ::, mt = 256 IP6.ROUTE[4]: dst = fd8a:6ff:2880::/64, nh = ::, mt = 256Jetzt hatte ich das erste Mal einen Ansatz, wonach ich suchen musste.

GENERAL.STATE: 10 (nicht verwaltet)Etwas Suche im Netz und dann das

nano /etc/NetworkManager/NetworkManager.confInhalt der Datei

[main] plugins=ifupdown,keyfile [ifupdown] managed=falseDas false in true geändert. Danach ein

systemctl restart NetworkManagerund ich konnte den Network-Manager auf dem Desktop benutzen!?!?!?

Irgendwas ist da durcheinander im Bullseye

-

-

-

-

-

-

-

-

Redis Datenbank sichern

Verschoben Redis