Hetzner Cloud - Volumes

-

Bedingt durch einige Spielerei an diesem Wochenende, wo ich mal wieder viel ausprobiert habe, bin ich doch zu der Überzeugung gekommen das das Setup von mir nicht sooo schlecht ist, bis auf eine Sache. Bei einem kurzen Schriftwechsel mit dem Nico, hatte ich eine Problem in meinem Setup erkannt. Alle meine Server liegen bei Hetzner im selben Rechenzentrum. Ok, wenn wir uns kurz zurück erinnern, nicht unbedingt die beste Idee.

OVH: Großbrand in Datenzentrum in Straßburg sorgt für Störungen

Das Unternehmen OVH zählt zu den größten Cloud-Anbietern Europas. In Straßburg beschädigte am Mittwoch ein Feuer eines der Firmengebäude schwer. Die Folgen betrafen mehrere Websites und Dienste.

(www.spiegel.de)

Hetzner bietet drei Standorte in Europa an, zwei in Deutschland und einer in Finnland. Somit war klar, der Server mit den Backups muss umziehen

Also, fangen wir an.

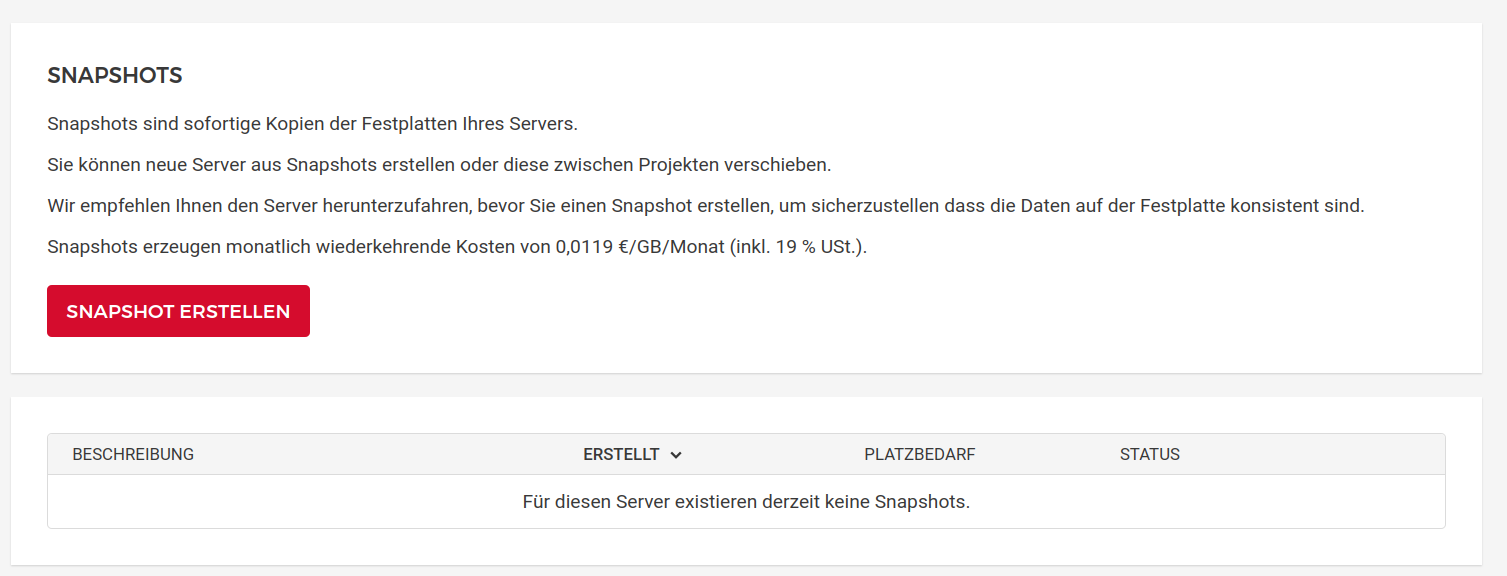

Snapshot erstellen

Von dem Server einen Snapshot angelegt. Dabei ist mir direkt ein anderes Problem aufgefallen. Der Snapshot ist 1,4 GB groß, ich habe aber ca. 100 GB an Daten

Ok, ich hatte da eine schwere Informationslücke, die Volumes werden nicht in die Datensicherung mit aufgenommen, es wird nur der Server gesichert.

Ok, ich hatte da eine schwere Informationslücke, die Volumes werden nicht in die Datensicherung mit aufgenommen, es wird nur der Server gesichert.Bitte beachten Sie, dass Snapshots und Backups keine Volumes enthalten, die an Ihren Server angehängt sind.

Quelle: https://docs.hetzner.com/de/cloud/general/faqOk, dazu später mehr.

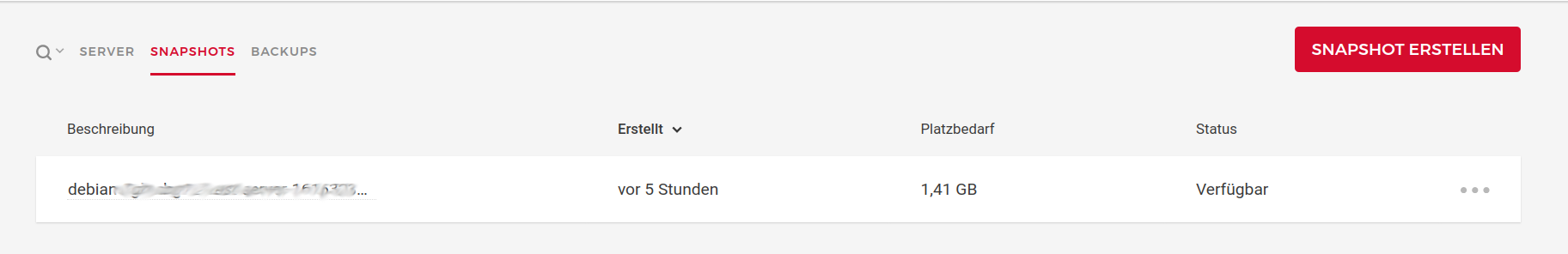

Snapshot transferieren

Ich habe mir für den Server ein eigenes Projekt erstellt. Dahin habe ich den Snapshot dann transferiert.

Server erstellen

Mit Hilfe dieses Snapshots konnte ich den Server nun neu erstellen. Das hatte auch ganz gut geklappt, bis auf das Volume. Das habe ich später nochmal ausgehangen und erneut angehangen um den automatischen Mount erneut erstellen zu können.

Dran denken, wenn man Volumes vergrößert, muss man das Filesystem von Hand vergrößern.

resize2fs /dev/sdx

Der Server lief danach und mein Volume war auch vorhanden, aber ohne Daten.

Volume umziehen

Da man Volumes nicht von einem Standort zum nächsten schieben kann, musste ich das von Hand mit Bordmitteln lösen. Auch nicht so schwer.

scp -r /mnt/HC_Volume_1234567/Ordner/ USER@<IPv4>://mnt/HC_Volume_12345678Danach konnte ich einen Kaffee trinken. Nach relativ kurzer Zeit waren die 100 GB auf dem neuen Volume drauf. Kurz noch die Benutzerrechte anpassen, weil mein Ordner von einem bestimmten Benutzer betreut wird

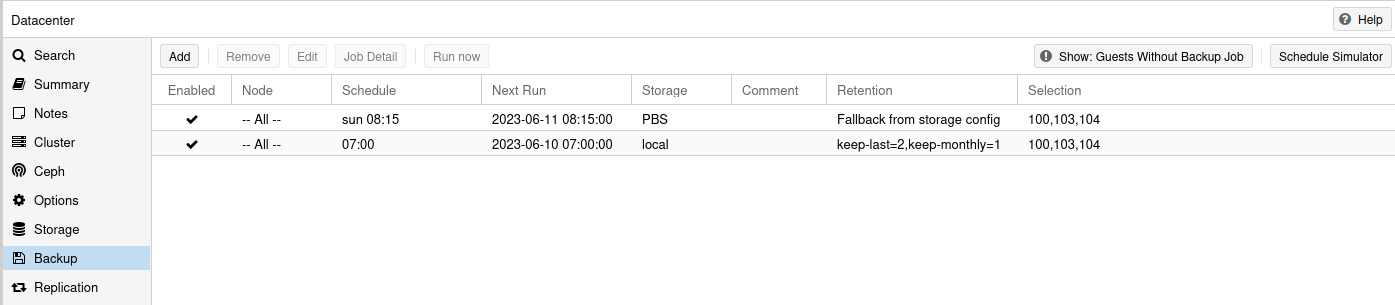

Backups

Dann für den neuen Server die Backup Funktion eingeschaltet.

Merksatz

Das Backup sichert keine Daten von einem Volume Laufwerk!!

Das Backup sichert keine Daten von einem Volume Laufwerk!!Servicearbeiten

Was musste ich noch an meinem Rest-Server machen?

-

Mit Letsencrypt das richtige Zertifikat installieren, nachdem ich den DNS-Eintrag auf den neuen Server eingestellt hatte.

-

Funktionstest. Ein Backup gestartet, lief alles einwandfrei.

-

Erinnerung im Kalender eingerichtet, das ich nächste Woche alles kontrolliere und dann den alten Server abschalte.

Fazit

Wieder eine Menge dieses Wochenende gelernt. Und einen Konzeptfehler in meinem Aufbau verbessert. Sollte jetzt das RZ mit den Webservern ausfallen, habe ich noch die Backups im anderen RZ. Sollte das RZ der Backups ausfallen, ist das zu verkraften, da die Webserver ja noch laufen. Somit sollte das jetzt für meine Hobbyserver ausreichend sicher sein.

Danke Nico, für den entscheidenden Hinweis, das ich was verbessern muss!

Oder das RZ abbrennt, siehe ovh

-