Bitwarden_RS auf einem Debian Buster 10 Server installieren!

-

Hi,

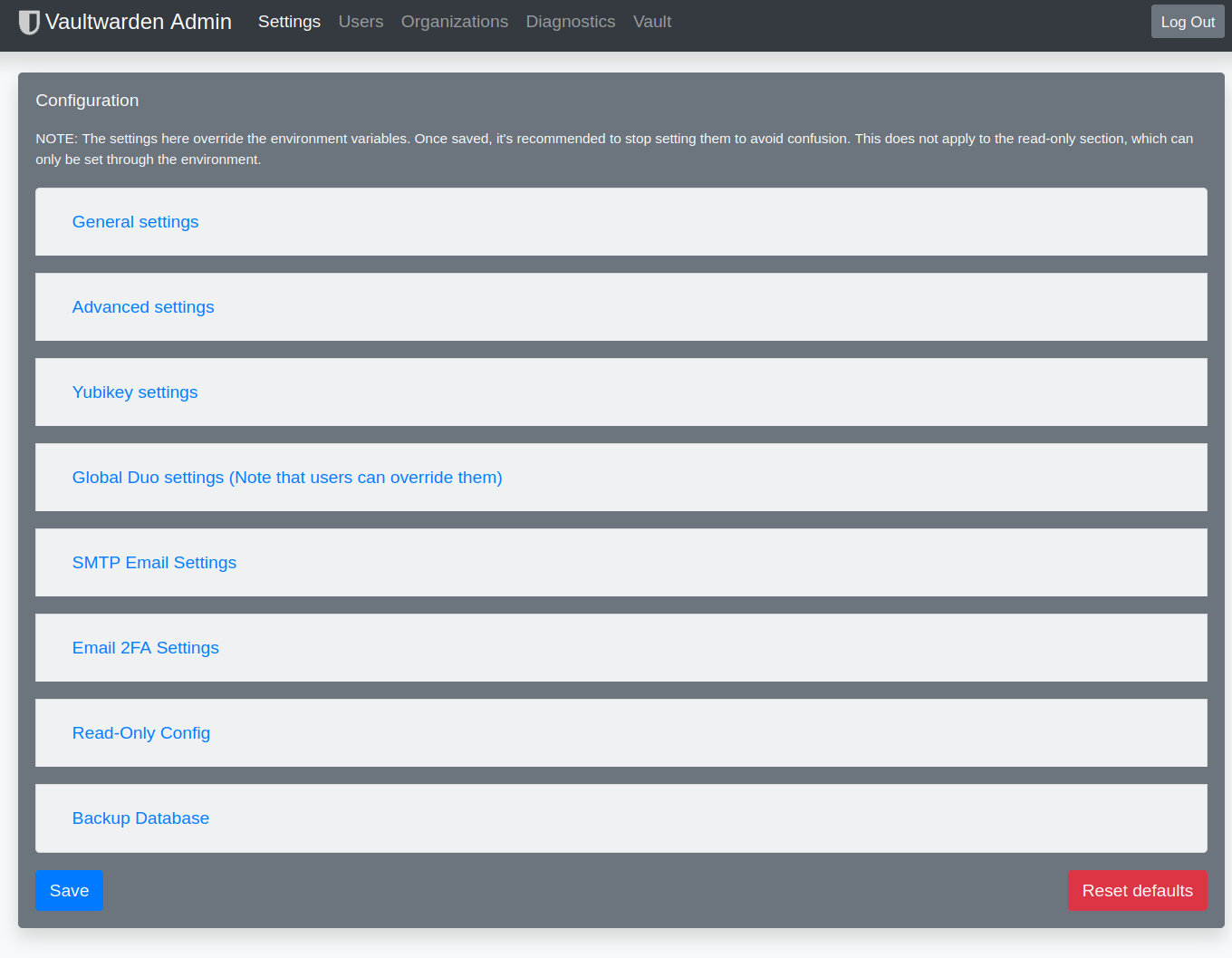

ich wollte auf einem neuen Server Vaultwarden installieren, leider erhalte ich folgende Fehlermeldung:

Das Laden der konfigurierten Datei »main/binary-arm64/Packages« wird übersprungen, da das Depot »http://bitwarden-deb.tech-network.de buster InRelease« die Architektur »arm64« nicht unterstützt.Gibt es dafür eine Lösung?

-

Hallo @hase567

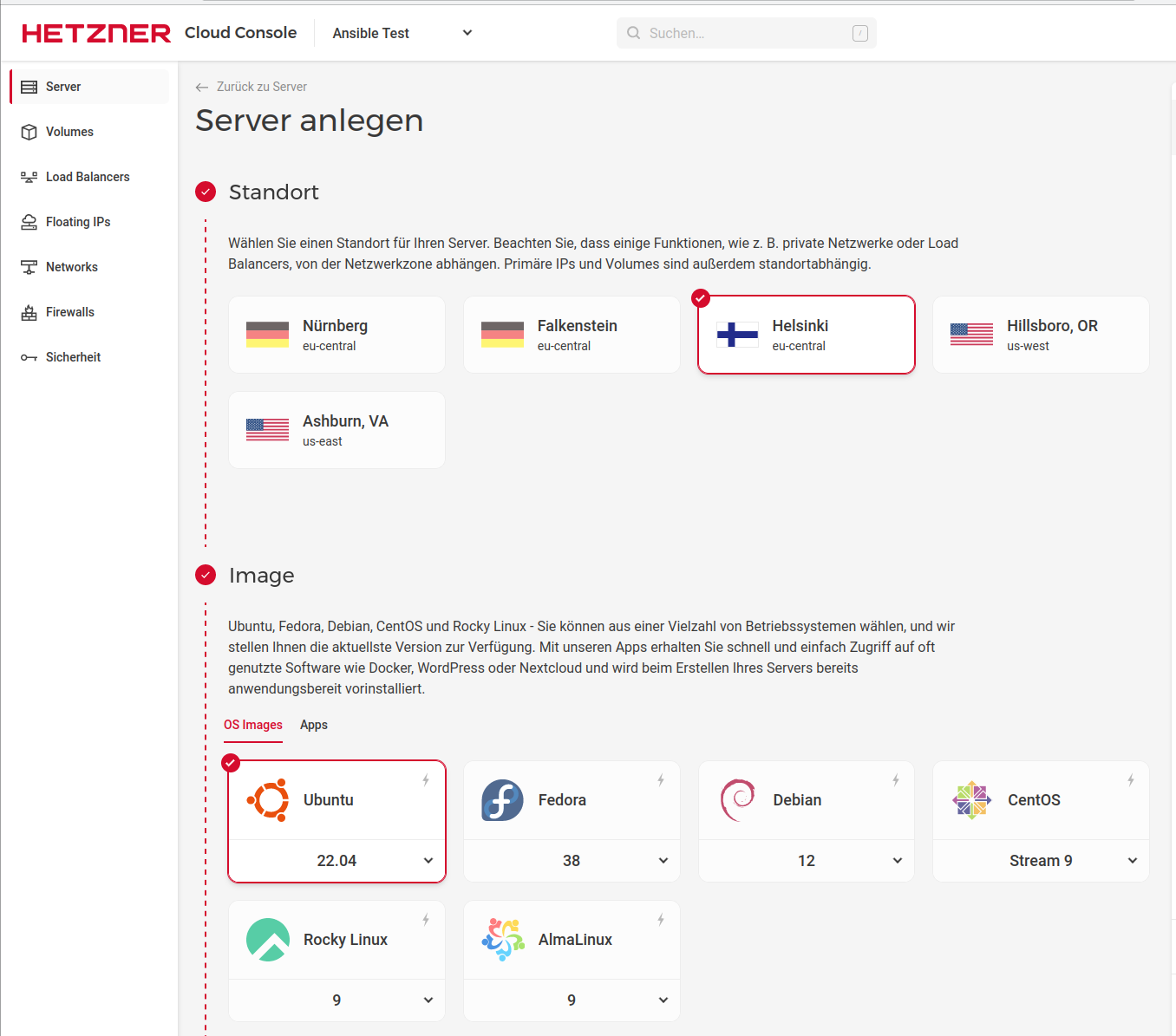

du hast einen Server auf ARM Basis (eine der neuen Hetzner Ampere Altra Instanzen?) und das Paket ist aktuell ausschließlich für x86/amd64 gebaut.

Aktuell gibt es dafür keine Lösung. Ich kann mir bei Gelegenheit gerne mal anschauen, was es an Aufwand bedeutet, ein arm64 Paket zu bauen. Ich bitte dafür allerdings noch um etwas Geduld. -

Hallo @hase567

du hast einen Server auf ARM Basis (eine der neuen Hetzner Ampere Altra Instanzen?) und das Paket ist aktuell ausschließlich für x86/amd64 gebaut.

Aktuell gibt es dafür keine Lösung. Ich kann mir bei Gelegenheit gerne mal anschauen, was es an Aufwand bedeutet, ein arm64 Paket zu bauen. Ich bitte dafür allerdings noch um etwas Geduld. -

Immerhin habe ich es jetzt endlich geschafft Support für neuere Distributionen einzubauen.

Debian 12 (bookworm) und Ubuntu 22.04 werden nun ebenfalls unterstützt!Es muss lediglich die Distribution in der vaultwarden.list/sources.list von "buster" auf "bookworm" geändert werden, wenn man Debian 12 oder Ubuntu 22.04 einsetzt.

Wie das funktioniert, steht in der aktualisierten Anleitung auf der Webseite des Repositories:

bitwarden-deb.tech-network.deBei Fragen oder Problemen gerne melden!

-

Immerhin habe ich es jetzt endlich geschafft Support für neuere Distributionen einzubauen.

Debian 12 (bookworm) und Ubuntu 22.04 werden nun ebenfalls unterstützt!Es muss lediglich die Distribution in der vaultwarden.list/sources.list von "buster" auf "bookworm" geändert werden, wenn man Debian 12 oder Ubuntu 22.04 einsetzt.

Wie das funktioniert, steht in der aktualisierten Anleitung auf der Webseite des Repositories:

bitwarden-deb.tech-network.deBei Fragen oder Problemen gerne melden!

-

Hier findest du ein Testpaket der aktuellen Vaultwarden Version für arm64:

https://bitwarden-deb.tech-network.de/testing/arm64/Einfach herunterladen und mittels dpkg -i <Dateiname> installieren.

Ich freue mich wie immer über Feedback.Achtung: Es handelt sich um eine Testversion.

Wenn die Version wie erwartert funktioniert, kann ich diese gerne regelmäßig bauen. -

Hier findest du ein Testpaket der aktuellen Vaultwarden Version für arm64:

https://bitwarden-deb.tech-network.de/testing/arm64/Einfach herunterladen und mittels dpkg -i <Dateiname> installieren.

Ich freue mich wie immer über Feedback.Achtung: Es handelt sich um eine Testversion.

Wenn die Version wie erwartert funktioniert, kann ich diese gerne regelmäßig bauen. -

"Safe" im Sinne von sicher? Ja, ich habe es aus dem gleichen Sourcecode gebaut wie die anderen Versionen.

"Safe" im Sinne von fehlerfrei? Vermutlich. Da ich das gerade zwischendurch "mal so" gebastelt habe, teste ich aber selbst noch einmal ausgiebig, bevor ich es offiziell mit ins Repository aufnehme.

Freut mich zu hören, dass es bei dir funktioniert!

-

Hi,

der vaultwarden-Status des ARM-Paket zeigt mir folgende Meldung:

[rocket::server::_][WARN] Responding with registered (not_found) 404 catcher -

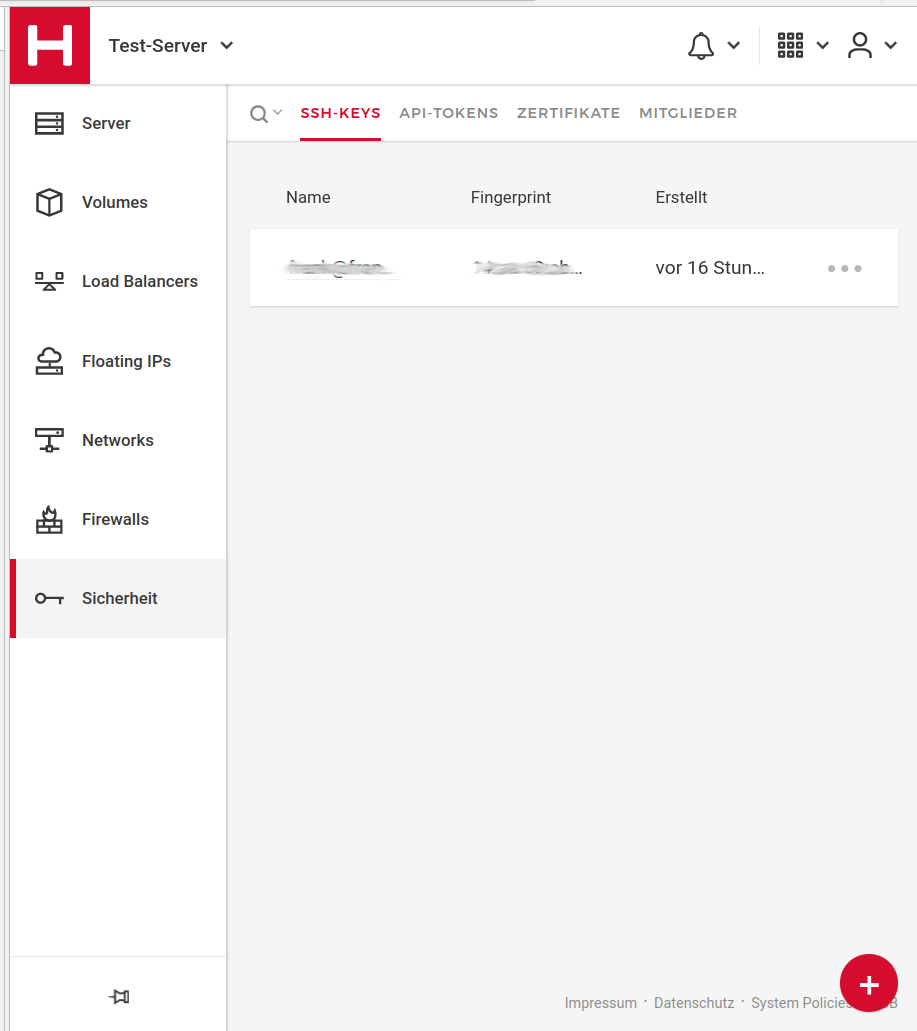

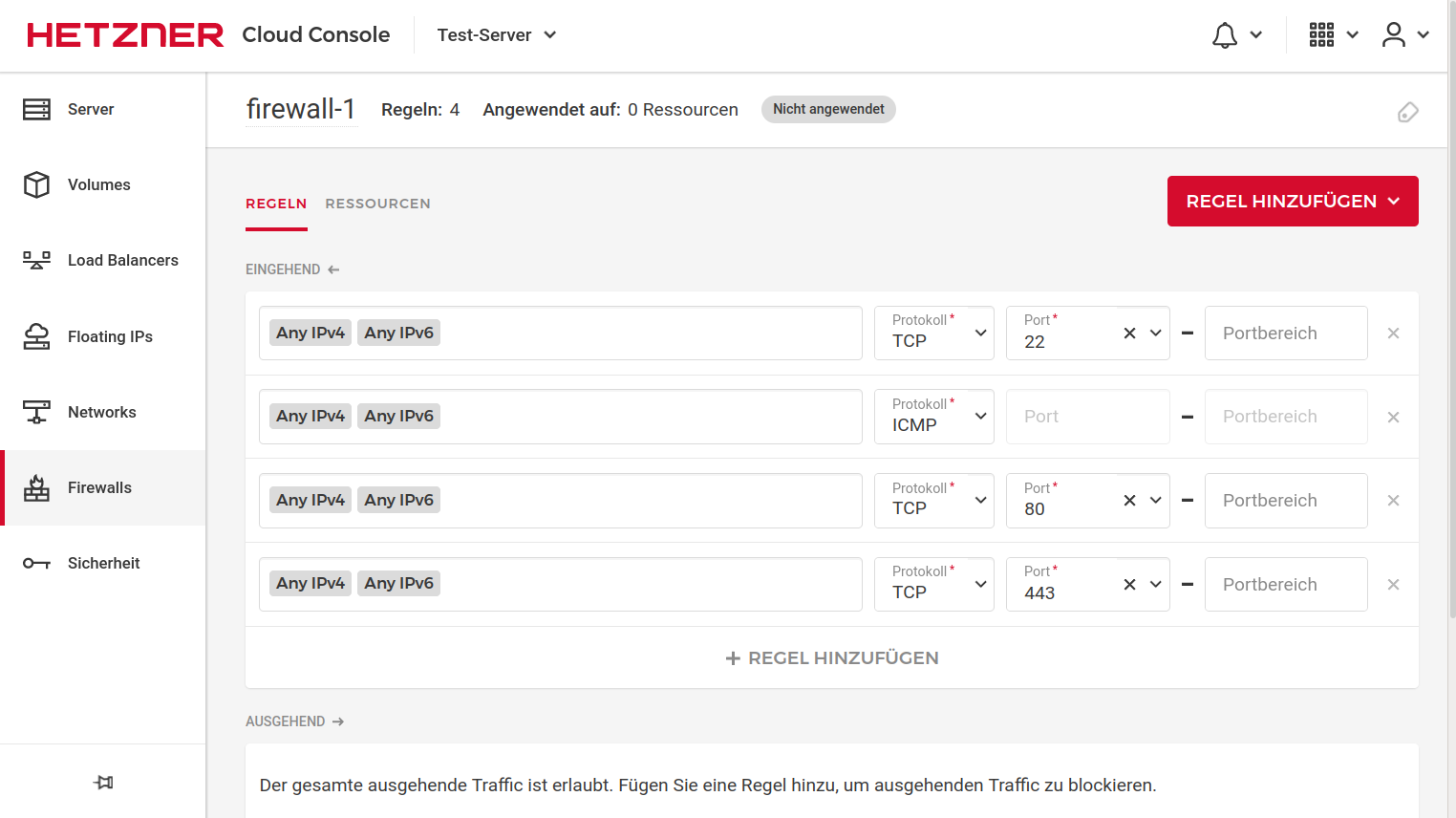

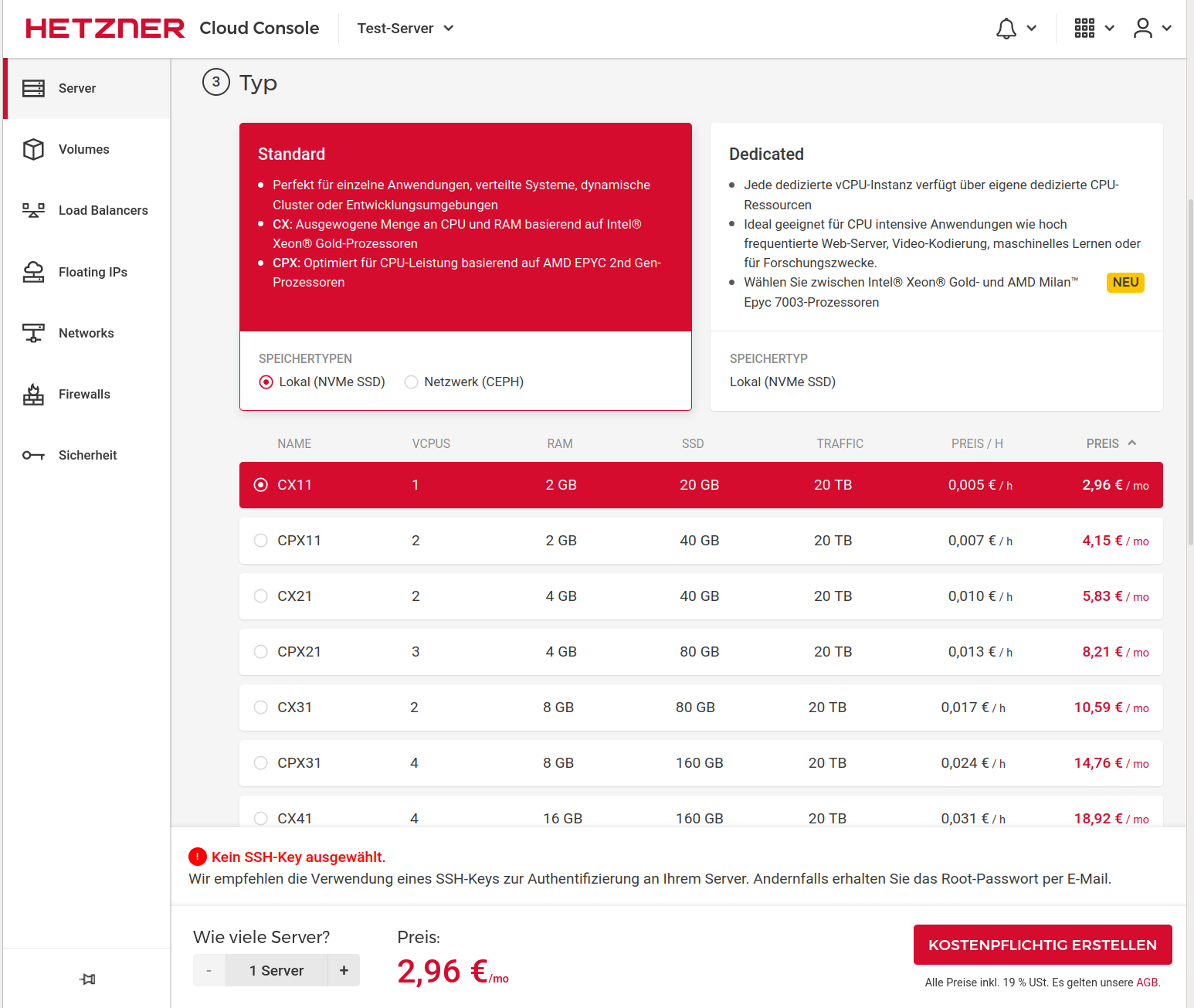

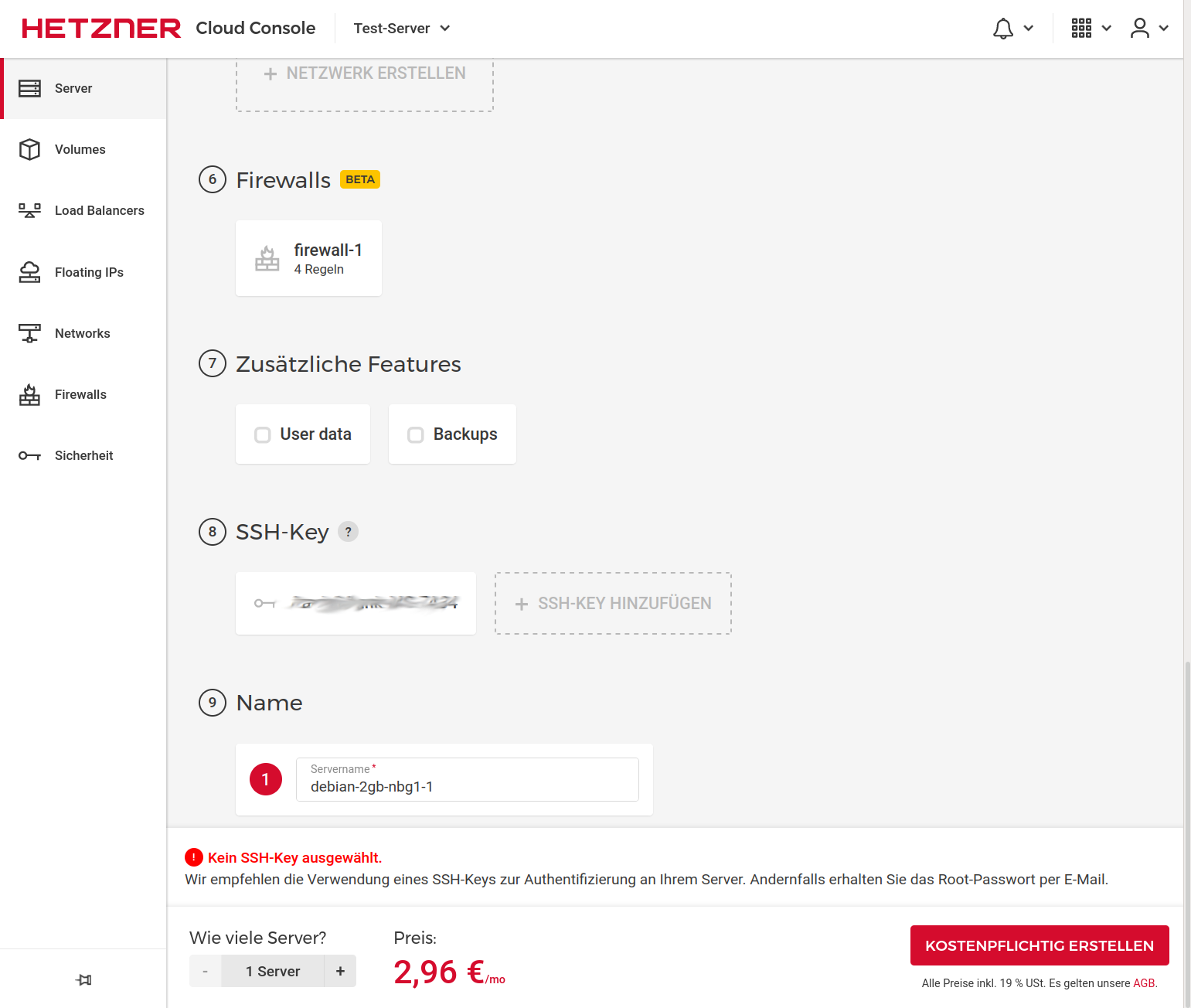

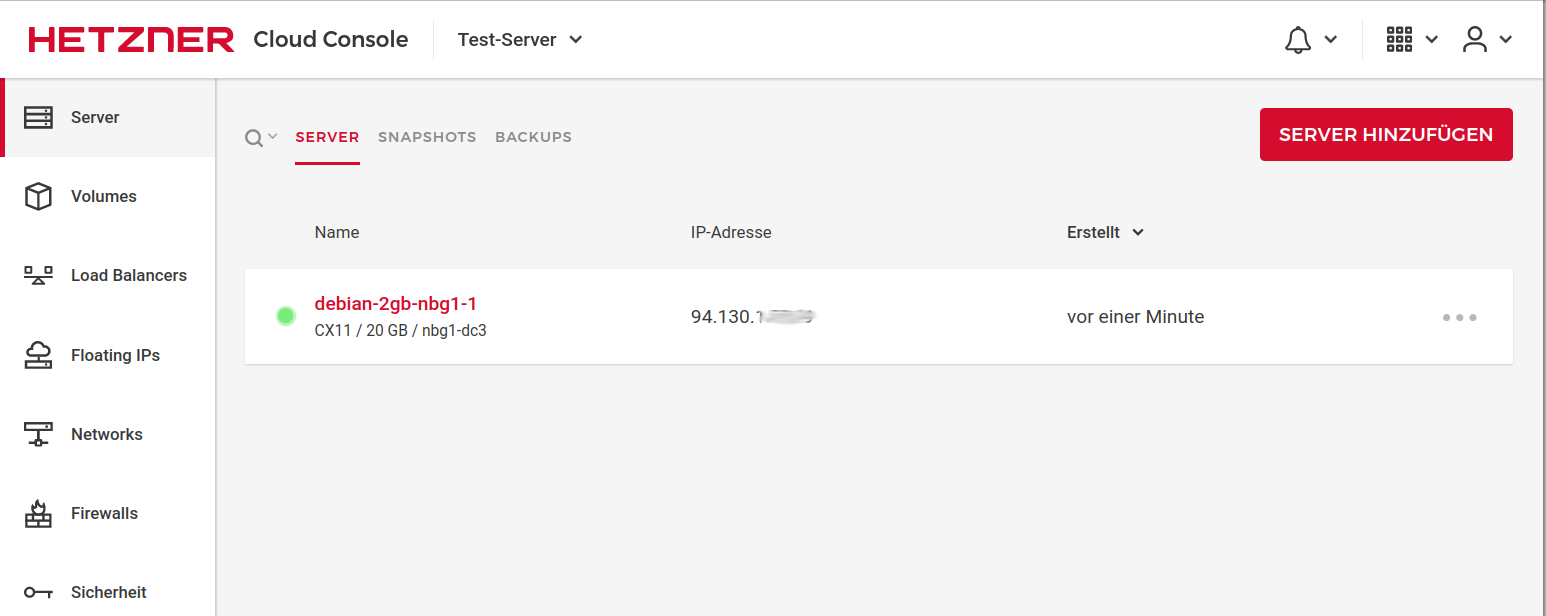

@hase567 Ich steige voraussichtlich am Wochenende ins Testen mit ein. Server bei Hetzner läuft schon. Bist Du auf Deb 11 oder 12?

-

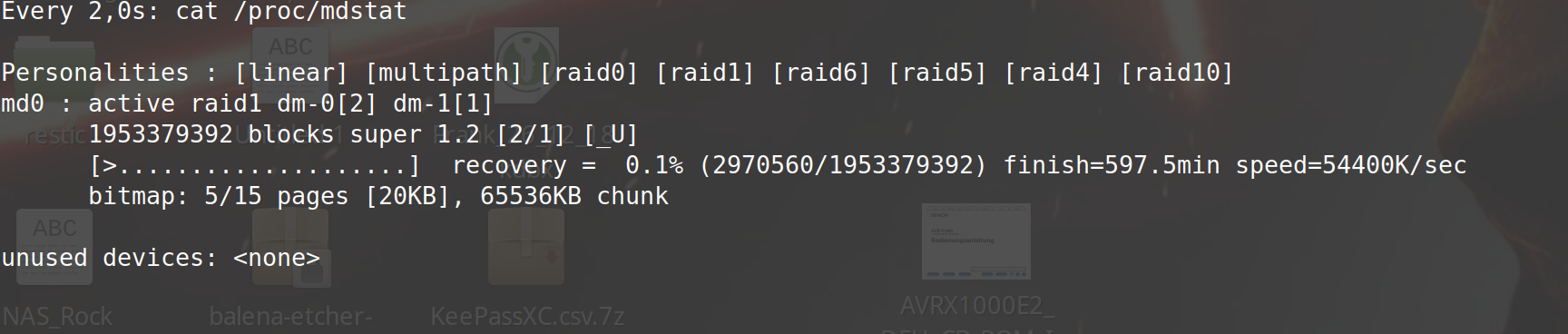

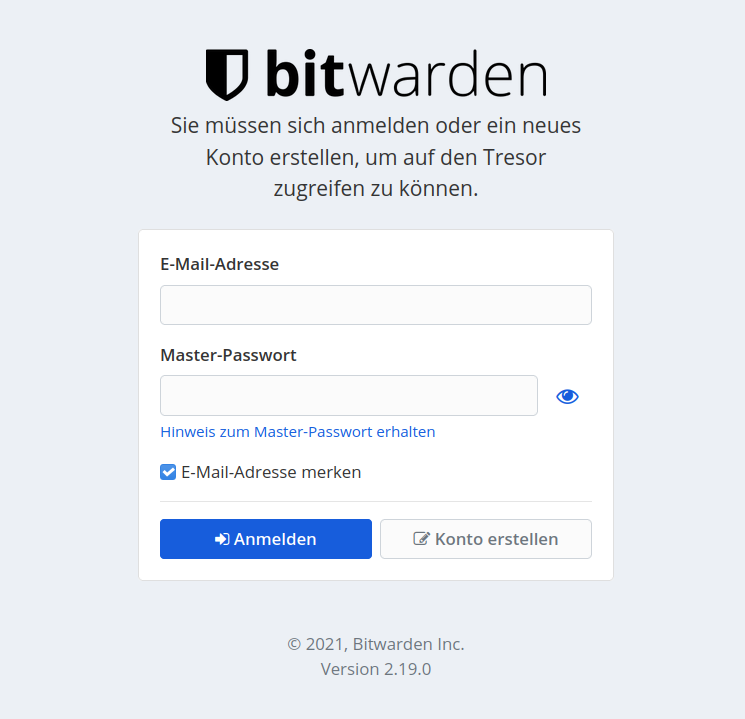

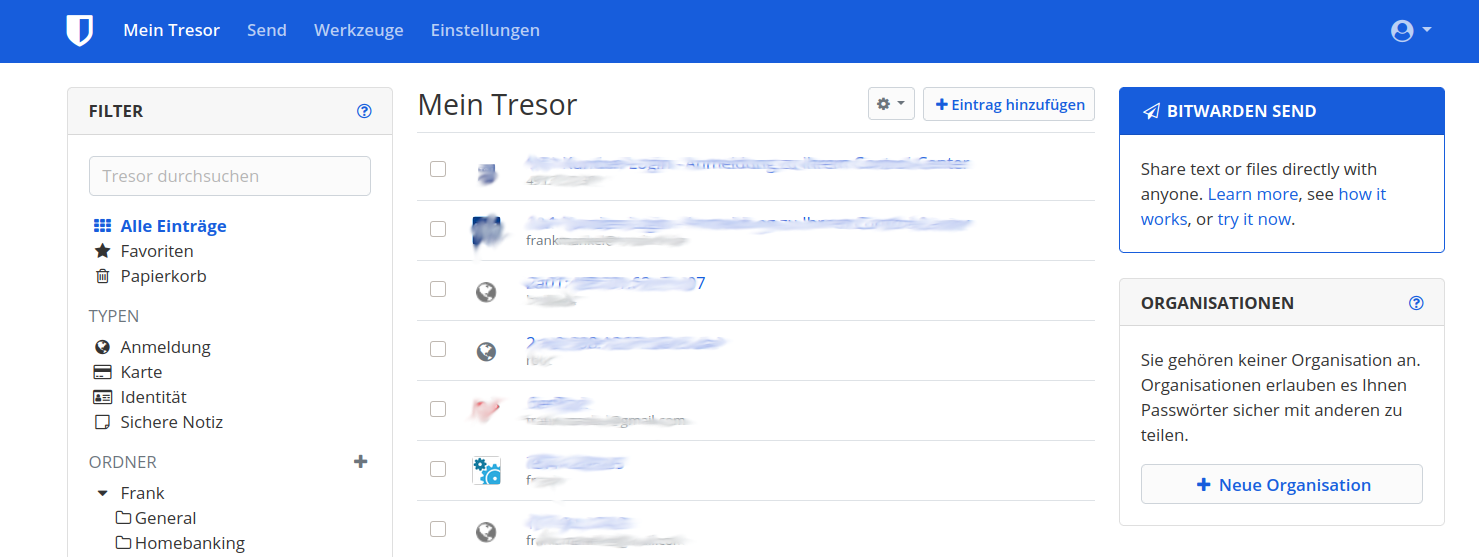

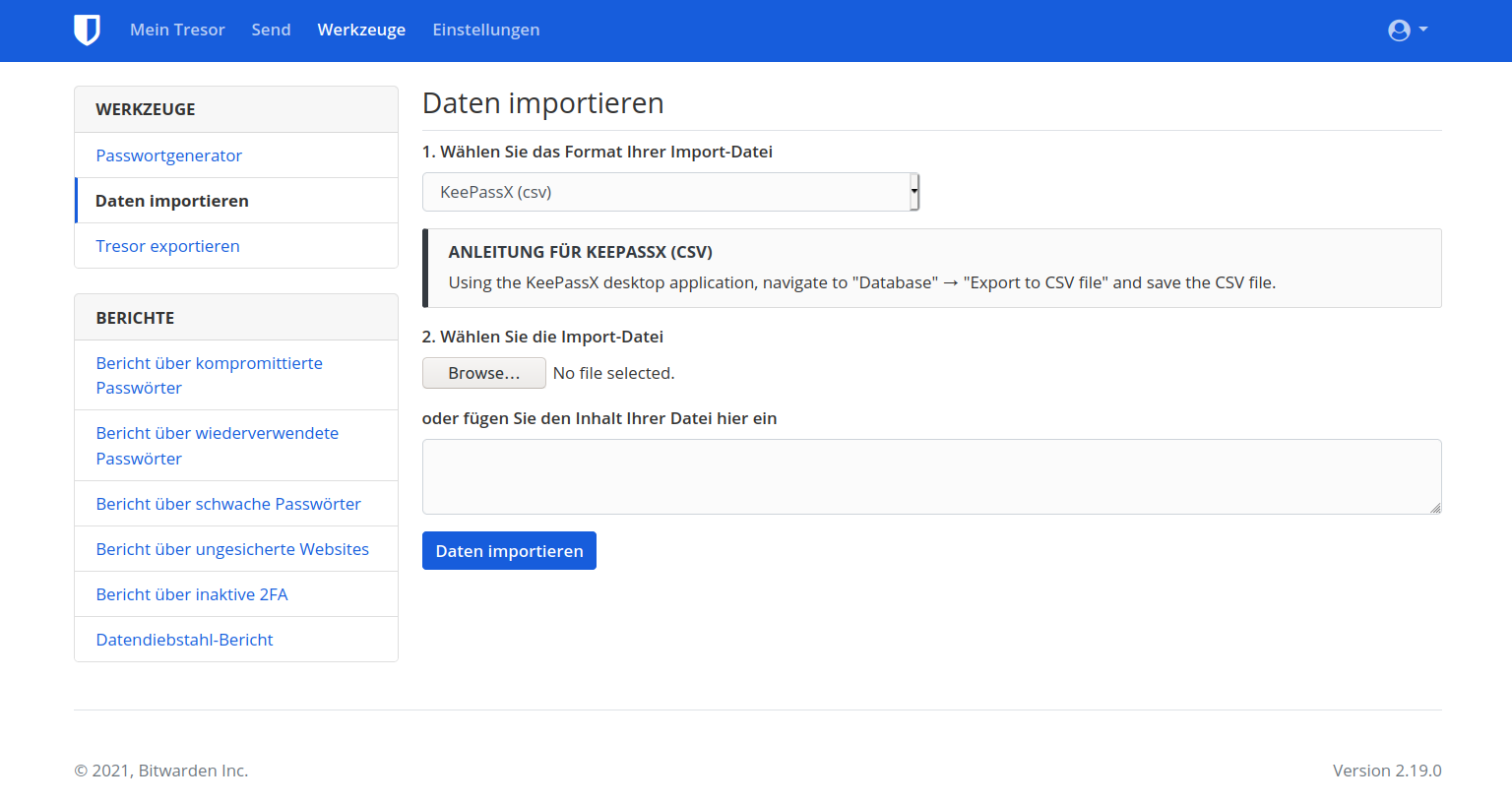

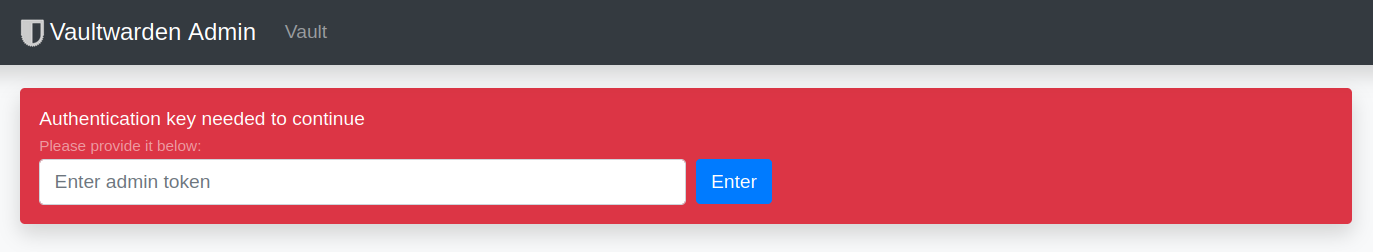

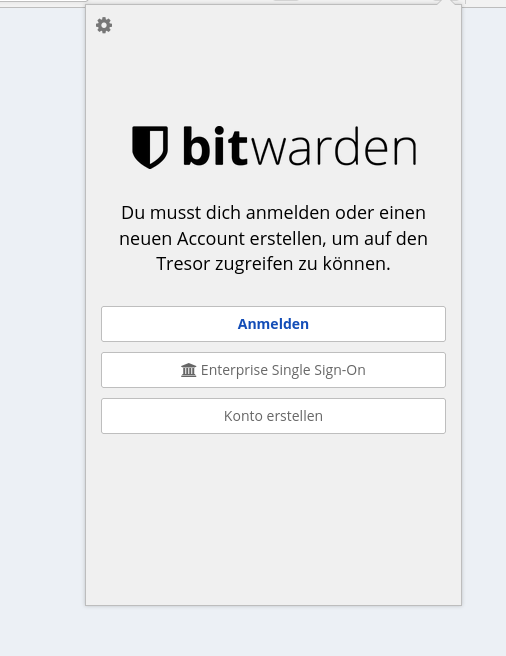

Der Vaultwarden läuft jetzt auf einem Arm64 Server (CAX11) von Hetzner - bis jetzt ohne Probleme. Habe jetzt auch den Vault im FF umgestellt um ihn produktiv zu nutzen / testen.

Bei der Installation des Debian Paketes kam das hier

Adding new group `vaultwarden' (GID 113) ... configuration error - unknown item 'NONEXISTENT' (notify administrator) configuration error - unknown item 'PREVENT_NO_AUTH' (notify administrator) Adding new user `vaultwarden' (UID 106) with group `vaultwarden' ... configuration error - unknown item 'NONEXISTENT' (notify administrator) configuration error - unknown item 'PREVENT_NO_AUTH' (notify administrator) Creating home directory `/var/lib/vaultwarden' ...Das hat sich aber, zumindestens bis jetzt, nicht negativ ausgewirkt.

Kernel Version

root@vaultwarden:~# uname -a Linux vaultwarden-4gb-fsn1-1 6.1.0-7-arm64 #1 SMP Debian 6.1.20-2 (2023-04-08) aarch64 GNU/LinuxDebian Version

root@vaultwarden:/etc# cat debian_version 12.0Anmerkung

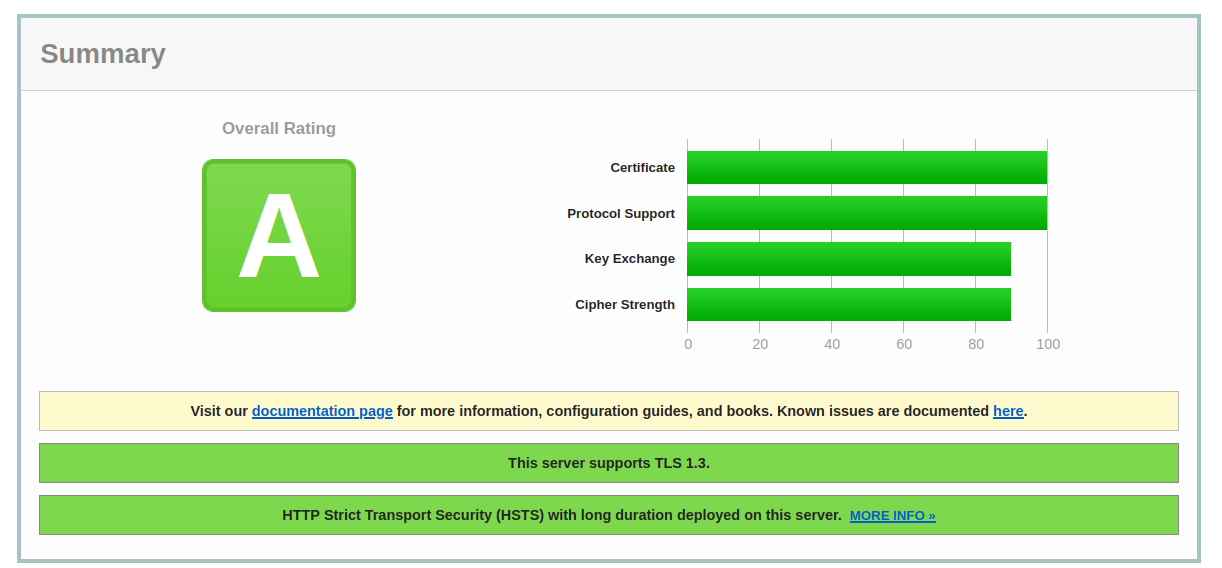

NGINX ist noch aus dem Debian Repo installiert. Normalerweise installiere ich von der NGINX Seite den Stable Release. Aber für Bookworm stand noch nichts zur Verfügung. Kommt dann sicherlich im Juni, wenn der Release von Debian Bookworm 12 ist.

Warnung

Debian Bookworm 12 ist noch nicht für den produktiven Einsatz vorgesehen! Also, auf eigenes Risiko testen!!

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

arm64 wird jetzt offiziell unterstützt!

Einfach die bekannte Anleitung befolgen: https://bitwarden-deb.tech-network.de/arm64 wird ebenfalls für die bekannten Plattformen (Debian 10 bis 12 und Ubuntu 20.04 sowie 22.04) bereitgestellt.

-

Ich hatte ja das Testpaket installiert. Vorgehensweise

apt remove vaultwarden apt install vaultwardenBei mir war danach alles wie vorher. Config, DB, alles noch vorhanden.

root@:/var/lib/vaultwarden# apt remove vaultwarden Reading package lists... Done Building dependency tree... Done Reading state information... Done The following packages will be REMOVED: vaultwarden 0 upgraded, 0 newly installed, 1 to remove and 0 not upgraded. After this operation, 0 B of additional disk space will be used. Do you want to continue? [Y/n] (Reading database ... 42444 files and directories currently installed.) Removing vaultwarden (1.28.1-1-buster) ... root@:/var/lib/vaultwarden# apt install vaultwarden Reading package lists... Done Building dependency tree... Done Reading state information... Done The following NEW packages will be installed: vaultwarden 0 upgraded, 1 newly installed, 0 to remove and 0 not upgraded. Need to get 14.6 MB of archives. After this operation, 0 B of additional disk space will be used. Get:1 http://bitwarden-deb.tech-network.de bookworm/main arm64 vaultwarden arm64 1.28.1-1-bookworm [14.6 MB] Fetched 14.6 MB in 0s (96.2 MB/s) Selecting previously unselected package vaultwarden. (Reading database ... 42145 files and directories currently installed.) Preparing to unpack .../vaultwarden_1.28.1-1-bookworm_arm64.deb ... Unpacking vaultwarden (1.28.1-1-bookworm) ... Setting up vaultwarden (1.28.1-1-bookworm) ... adduser: Warning: The home dir /var/lib/vaultwarden you specified already exists. The system user `vaultwarden' already exists. Exiting.Danach zur Sicherheit noch den Dienst neugestartet

systemctl restart vaultwardenFertig!

dann ist es Perfekt.

dann ist es Perfekt.