Counter-Strike 2 unter Linux?

-

Heute mal ein wenig Nostalgisches. Ich tauche mal in Zeiten ab, die schon lange vorbei sind. Das letzte Mal, das ich auf einem PC mit Tastatur und Maus gezockt habe, ist schon ein wenig her. Ich bevorzuge heute, ganz entspannt eine PS5. Ok, ich wollte schon lange mal wieder Steam ausprobieren, da lag es nahe, das mit Counter-Strike 2 zu testen

Da ich hier noch einen PC in Standby habe, nehmen wir den mal eben für einen schnellen Test.

Mal flott ein Debian Bookworm 12 drauf geschmissen. Danach bei Steam das .deb Package heruntergeladen. Mit

dpkg -i steam-latest.debinstallieren und den Anweisungen folgen. Einzige Abhängigkeit ist das Paket curl, das muss vorher schon installiert sein. Danach war Steam installiert. Irgendwo hatte ich noch einen uralten Login gefunden.

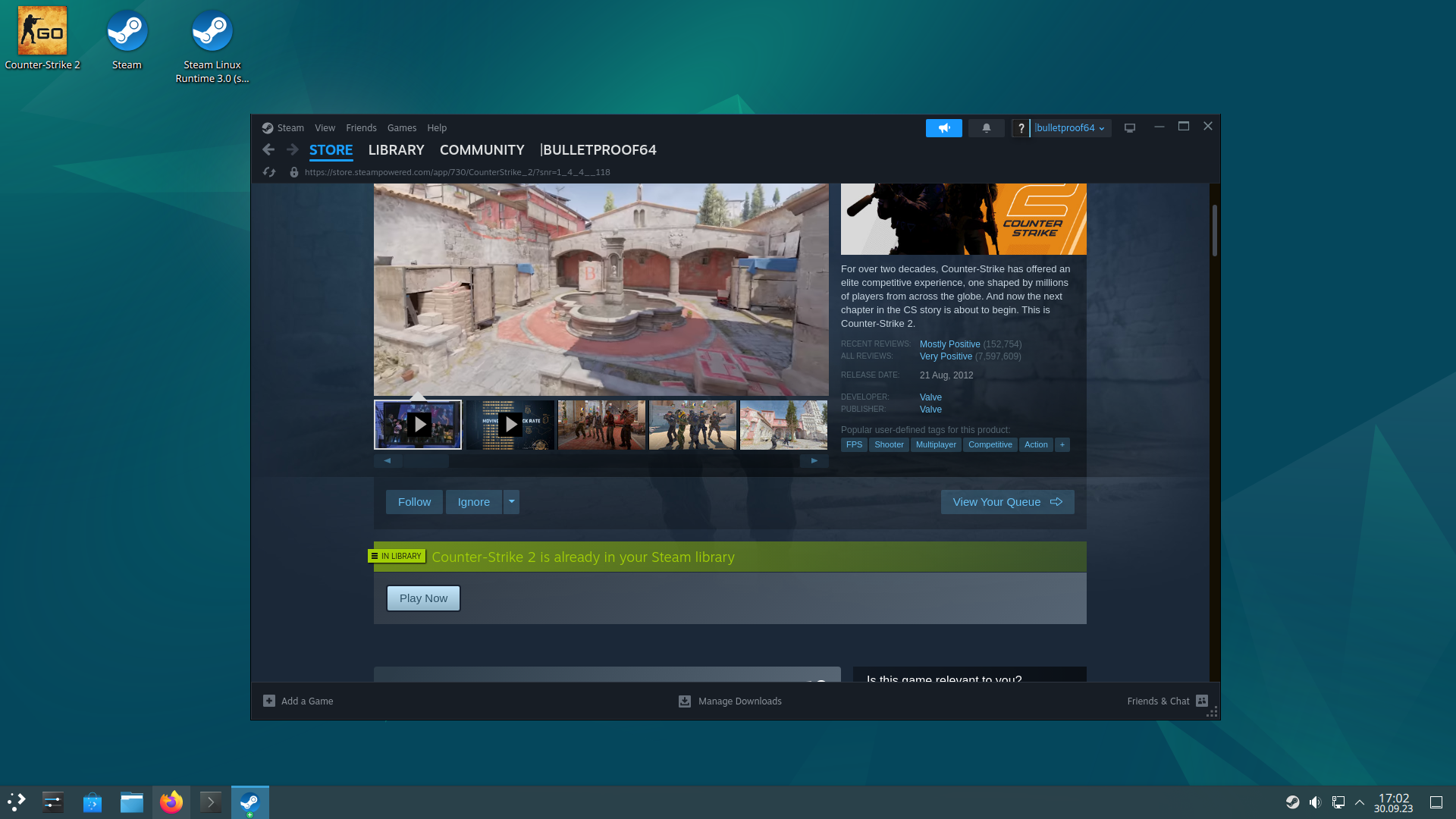

Steam installieren, da kommen dann mal so 33GB(?) Daten. Danach kann man dann eintauchen ins Spiel.

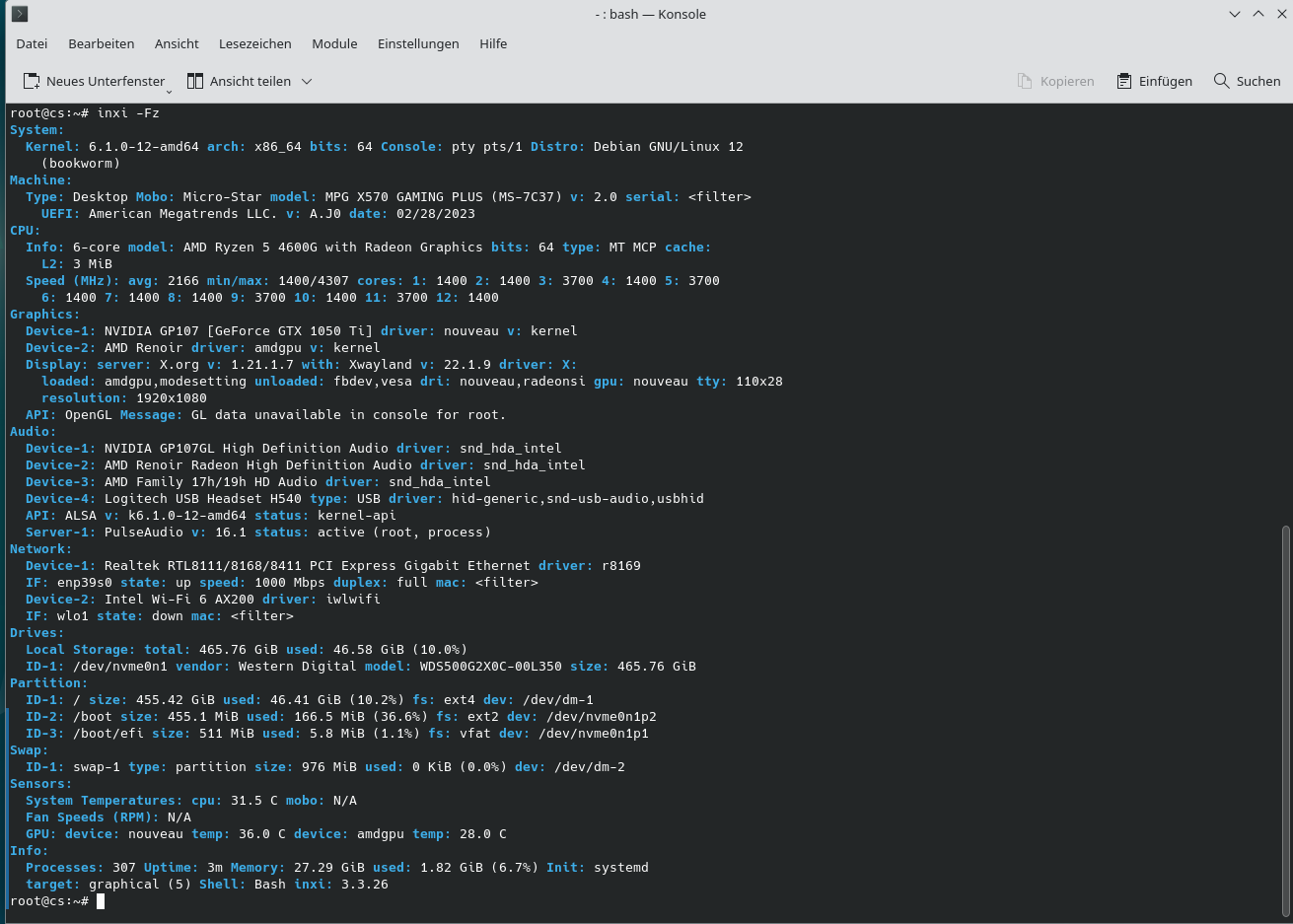

Da ich hier leider nur noch eine ausrangierte NVidia Grafikkarte GTX 1050 Ti liegen hatte, musste diese dran glauben. Nein, das ist nicht konkurrenzfähig. Das Spiel läuft besch..... Aber um mal reinzuschnuppern musste es reichen.

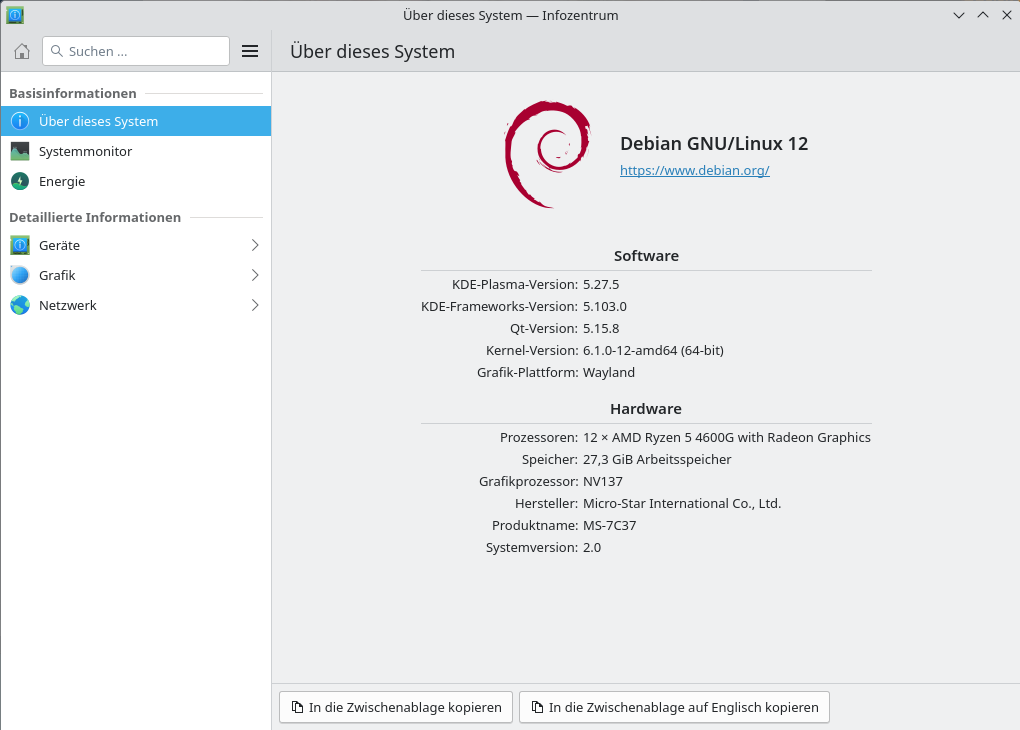

Das Debian was ich installiert habe, wurde mit einem KDE Plasma ausgestattet. Das lief standard mit einer Wayland Session. Interessant Spielen unter Linux ist Dank Steam heute keine große Sache mehr. Ich hatte das schon öfter gelesen, aber noch nicht selber ausprobiert. Es ist wirklich kinderleicht.

Hier noch ein wenig Daten zum System. Und dran denken, nein damit gewinnt man nicht

-

Ergänzungen

Ich hatte Steam auch auf meinem Haupt-PC installiert, da muss es aber wieder runter. Läuft da nicht vernünftig und am PC wird auch nichts geändert. Dafür habe ich ja den anderen eingerichtet. Also, ran ans Aufräumen

Installation

Steam gibt es auch als Flatpak, aber das habe ich nicht getestet. Wenn es läuft, würde ich das empfehlen. Dann bleibt das System sauber.

Deinstallation

Das .deb Paket mit der Software Verwaltung öffnen. Auf Deinstallation klicken.

Danach waren leider alle Daten noch vorhanden, als Handarbeit

rm -R /home/frank/.local/share/Steam

-

-

-

-

-

-

-

-

SSH Login ohne Passwort

Angeheftet Linux