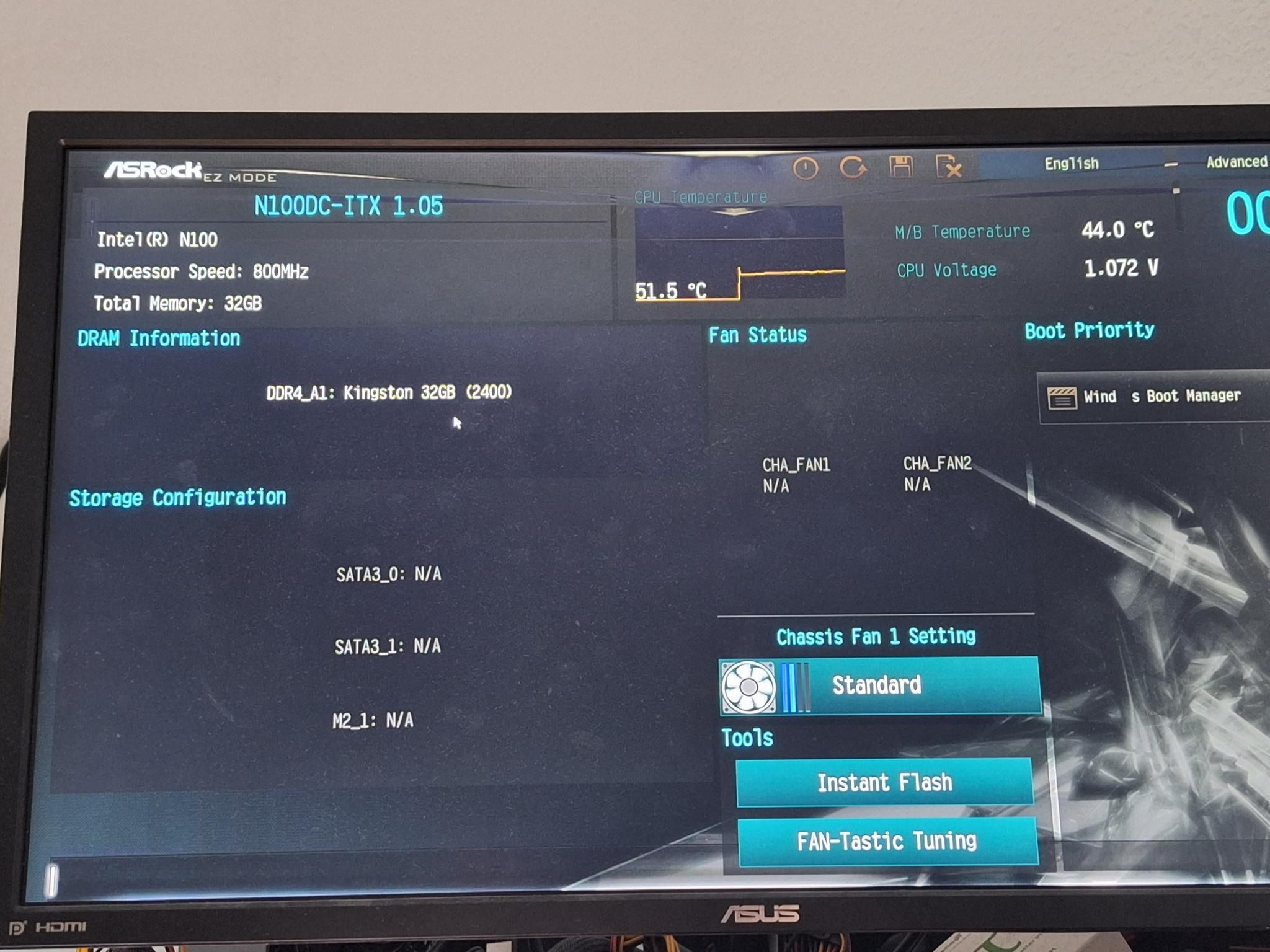

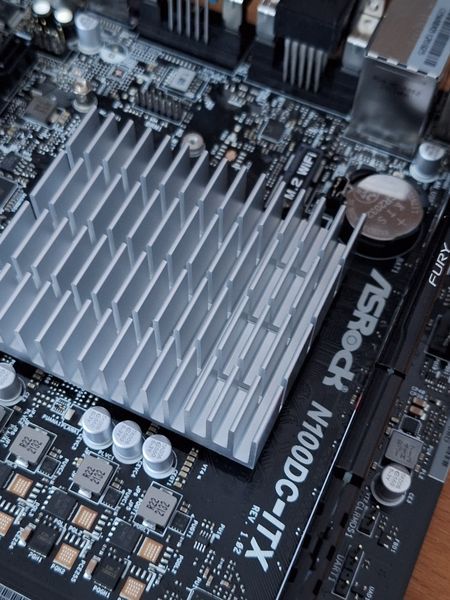

ASRock N100DC-ITX

-

Hier hatten wir uns schon mal mit dem Thema der neuen ASRock Boards beschäftigt.

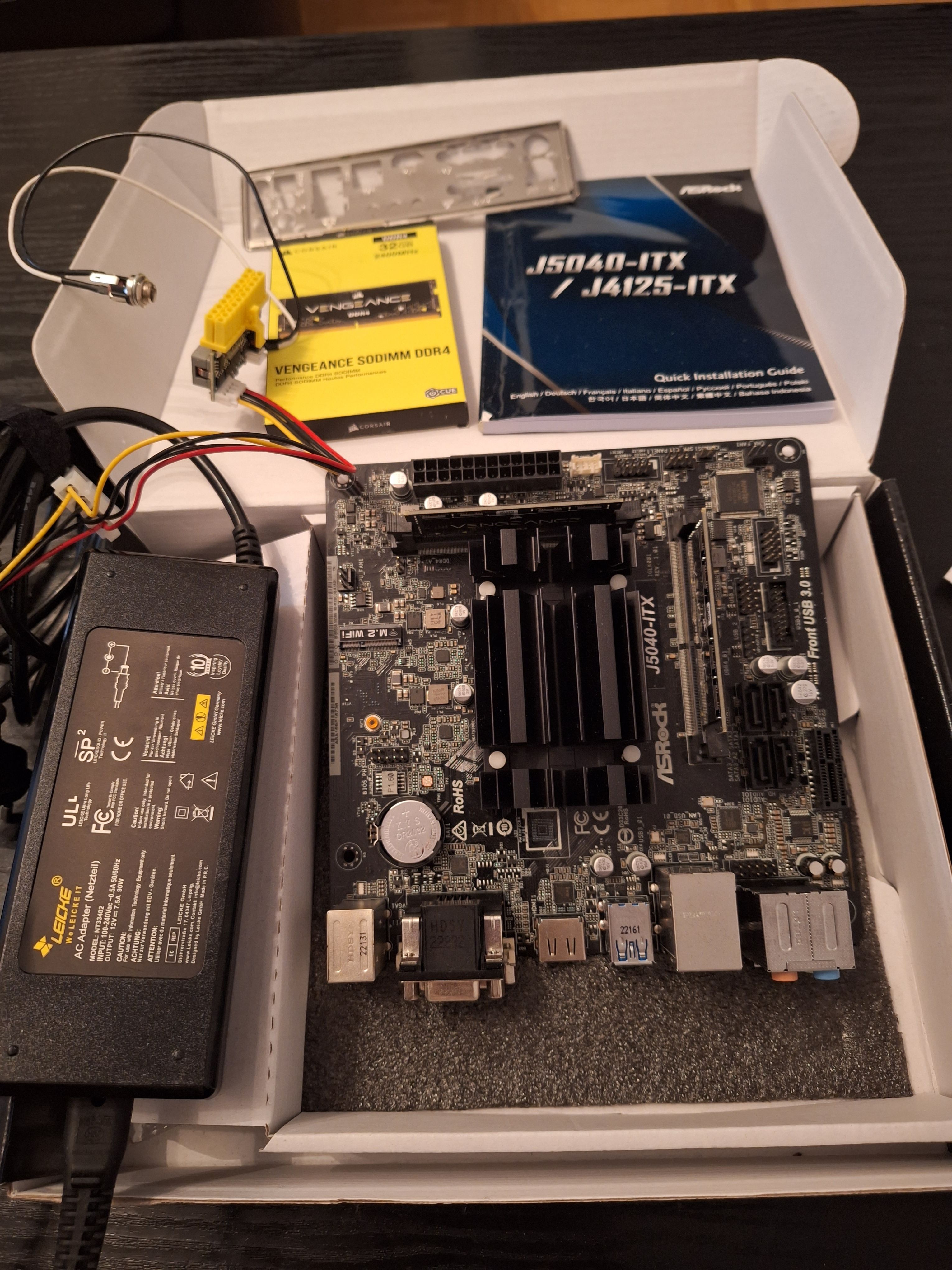

Komponenten

- ASRock N100DC-ITX

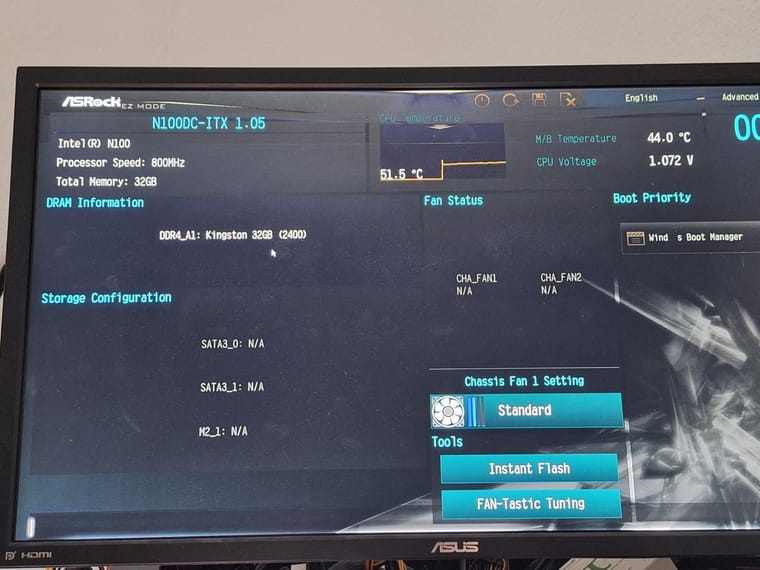

- Kingston Fury DDR4-Ram 32GB (KF432C16BB/32

- Netzteil Leicke Universalnetzteil für HP 19V 4,74A 90W

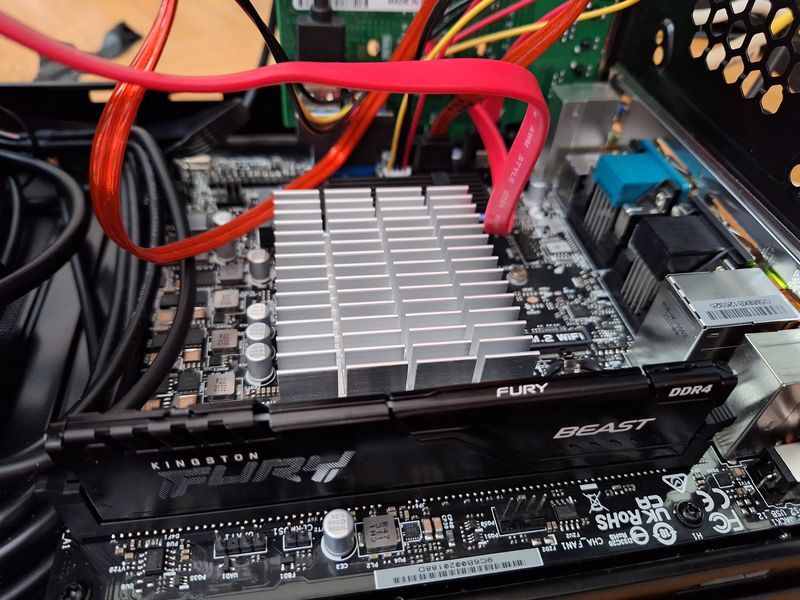

Ich konnte es nicht abwarten, also musste man es zum Leben erwecken.

Hier noch ohne NVMe Riegel. Was mich am Anfang etwas stutzig machte, das Board hat den Speicher nicht richtig erkannt. Ich habe DDR4-3200 gekauft, erkannt wurden nur 2400.

Im BIOS unter OC konnte ich den DDR Speicher auf 3200 festnageln. Mal schauen ob das Board damit stabil läuft.

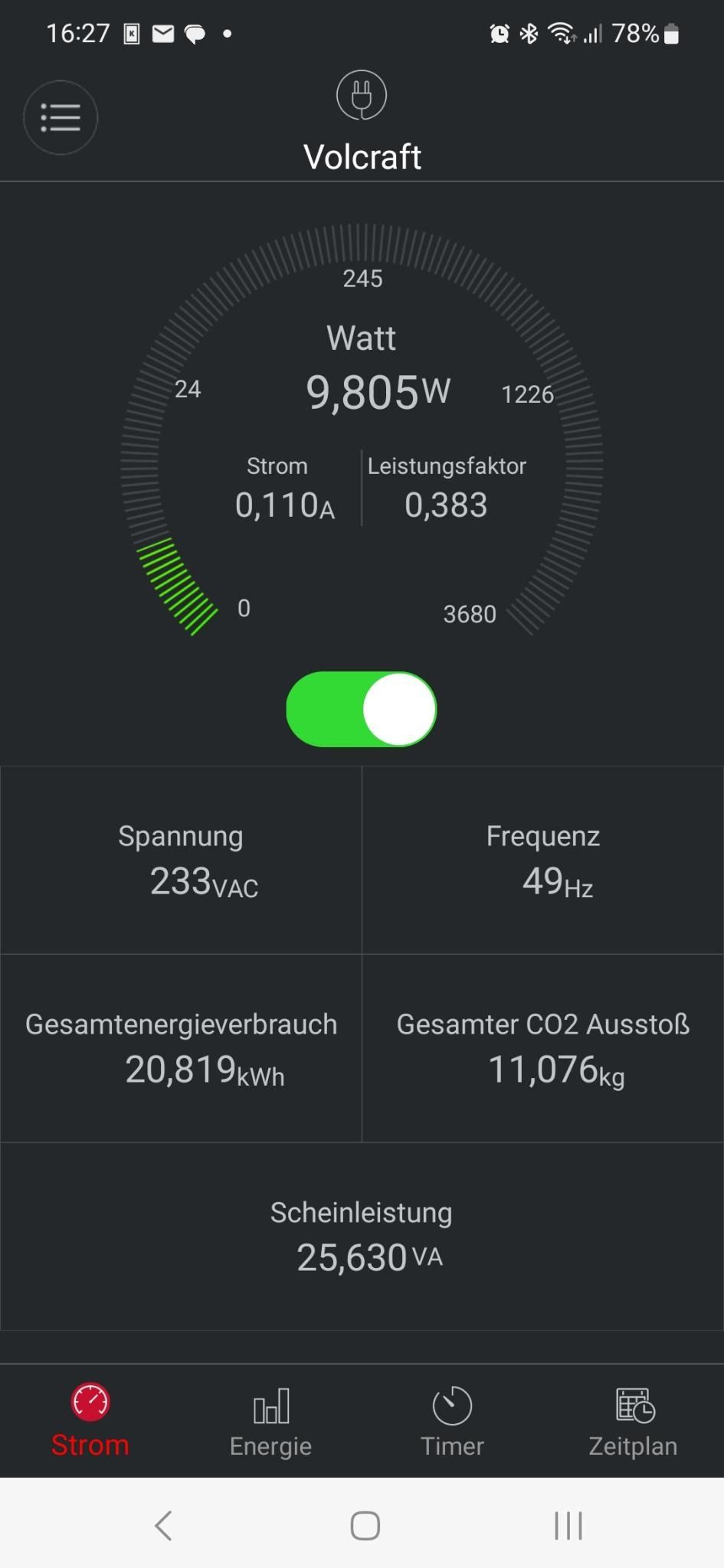

Was ist noch wichtig? Die Stromaufnahme!

Stromaufnahme 9 - 11 Watt im Idle (Proxmox ohne VMs) Nur NVMe, keine Platten verbaut!

Herstellerlink: https://www.asrock.com/MB/Intel/N100DC-ITX/

Hinweis: Ich bezahle die Komponenten selber!

-

NVMe

Die NVMe (Crucial P3 mit 500GB) ist, wenn ich das richtig verstehe, nur mit zwei Lanes an die CPU angebunden. Das macht dann

root@asrock:~# dd if=/dev/zero of=test.img bs=1M count=4096 conv=fdatasync 4096+0 records in 4096+0 records out 4294967296 bytes (4.3 GB, 4.0 GiB) copied, 3.9673 s, 1.1 GB/sFrequenzen

root@asrock:/sys/devices/system/cpu/cpu0/cpufreq# cat cpuinfo_min_freq 700000 root@asrock:/sys/devices/system/cpu/cpu0/cpufreq# cat cpuinfo_max_freq 3400000Aktuelle cpufreq

analyzing CPU 3: driver: intel_pstate CPUs which run at the same hardware frequency: 3 CPUs which need to have their frequency coordinated by software: 3 maximum transition latency: 4294.55 ms. hardware limits: 700 MHz - 3.40 GHz available cpufreq governors: performance, powersave current policy: frequency should be within 700 MHz and 3.40 GHz. The governor "performance" may decide which speed to use within this range. current CPU frequency is 800 MHz.oder auch

analyzing CPU 3: driver: intel_pstate CPUs which run at the same hardware frequency: 3 CPUs which need to have their frequency coordinated by software: 3 maximum transition latency: 4294.55 ms. hardware limits: 700 MHz - 3.40 GHz available cpufreq governors: performance, powersave current policy: frequency should be within 700 MHz and 3.40 GHz. The governor "performance" may decide which speed to use within this range. current CPU frequency is 1.63 GHz.iperf3

root@asrock:/sys/devices/system/cpu/cpu0/cpufreq# iperf3 -s ----------------------------------------------------------- Server listening on 5201 (test #1) ----------------------------------------------------------- Accepted connection from 192.168.3.213, port 50746 [ 5] local 192.168.4.7 port 5201 connected to 192.168.3.213 port 50750 [ ID] Interval Transfer Bitrate [ 5] 0.00-1.00 sec 112 MBytes 938 Mbits/sec [ 5] 1.00-2.00 sec 112 MBytes 941 Mbits/sec [ 5] 2.00-3.00 sec 112 MBytes 942 Mbits/sec [ 5] 3.00-4.00 sec 112 MBytes 940 Mbits/sec [ 5] 4.00-5.00 sec 112 MBytes 941 Mbits/sec [ 5] 5.00-6.00 sec 112 MBytes 941 Mbits/sec [ 5] 6.00-7.00 sec 112 MBytes 941 Mbits/sec [ 5] 7.00-8.00 sec 112 MBytes 941 Mbits/sec [ 5] 8.00-9.00 sec 112 MBytes 941 Mbits/sec [ 5] 9.00-10.00 sec 112 MBytes 939 Mbits/sec [ 5] 10.00-10.01 sec 547 KBytes 885 Mbits/sec - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate [ 5] 0.00-10.01 sec 1.10 GBytes 941 Mbits/sec receiver ----------------------------------------------------------- Server listening on 5201 (test #2) ----------------------------------------------------------- Accepted connection from 192.168.3.213, port 33692 [ 5] local 192.168.4.7 port 5201 connected to 192.168.3.213 port 33694 [ ID] Interval Transfer Bitrate Retr Cwnd [ 5] 0.00-1.00 sec 114 MBytes 959 Mbits/sec 0 600 KBytes [ 5] 1.00-2.00 sec 112 MBytes 939 Mbits/sec 0 628 KBytes [ 5] 2.00-3.00 sec 113 MBytes 948 Mbits/sec 0 659 KBytes [ 5] 3.00-4.00 sec 111 MBytes 933 Mbits/sec 0 768 KBytes [ 5] 4.00-5.00 sec 112 MBytes 944 Mbits/sec 0 768 KBytes [ 5] 5.00-6.00 sec 112 MBytes 944 Mbits/sec 0 768 KBytes [ 5] 6.00-7.00 sec 112 MBytes 944 Mbits/sec 0 768 KBytes [ 5] 7.00-8.00 sec 112 MBytes 944 Mbits/sec 0 768 KBytes [ 5] 8.00-9.00 sec 111 MBytes 933 Mbits/sec 0 823 KBytes [ 5] 9.00-10.00 sec 112 MBytes 944 Mbits/sec 0 823 KBytes - - - - - - - - - - - - - - - - - - - - - - - - - [ ID] Interval Transfer Bitrate Retr [ 5] 0.00-10.00 sec 1.10 GBytes 943 Mbits/sec 0 sender -

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen

-

F FrankM hat dieses Thema am angepinnt

F FrankM hat dieses Thema am angepinnt

-

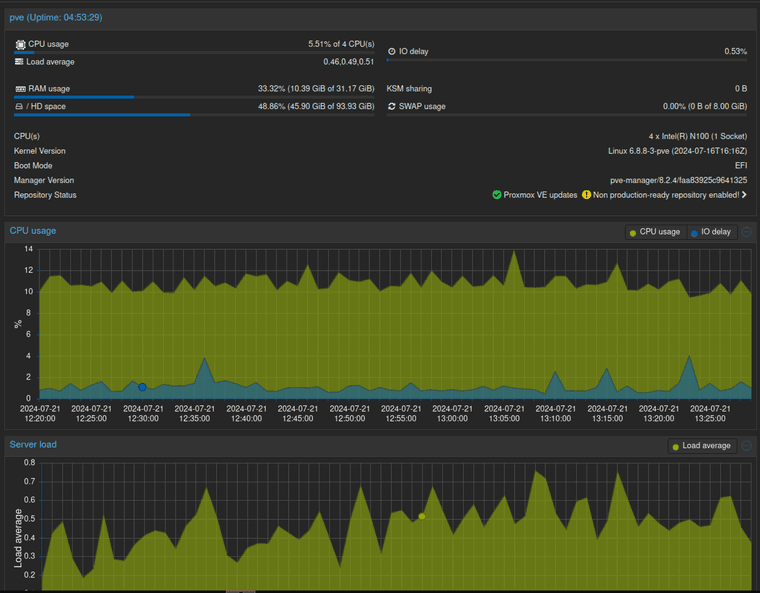

Ich sehe gerade, das ist schon wieder 1 Jahr her. Ich betreibe dieses Board seitdem als Proxmox Server 24/7. Das Ding läuft immer, ab und zu gibt es dann mal einen Reboot wegen neuer Kernel. Ansonsten treibt das Board mittlerweile folgende VMs an.

- pfSense

- Semaphore

- DokuWiki

- DNS (Werbeblocker)

- NAS

- MongoDB

- Home Assistant

- CheckMK

Alle VMs laufen mit Debian 12.

-

F FrankM hat am auf dieses Thema verwiesen

F FrankM hat am auf dieses Thema verwiesen