Storage Box für den REST-Server

-

Ich nutze schon lange einen REST-Server zur Datensicherung. Dazu benutze ich auch schon länger eine Storage Box von Hetzner für die Speicherung der Datensicherungen. Bedingt durch eine Neuinstallation hatte ich ein paar Probleme, die etwas Zeit gekostet haben. Beim Mounten des DAV Laufwerkes kam immer eine kryptische Fehlermeldung, zu der ich auch nicht wirklich was gefunden habe.

Installation

apt install davfs2Danach legt man die Zugangsdaten unter

nano /etc/davfs2/secretsab. Beispiel

https://<Benutzername>.your-storagebox.de <Benutzername> <Passwort>Jetzt muss man das noch unter /etc/fstab mounten. Aus der Hetzner Anleitung.

https://<Benutzername>.your-storagebox.de /MOUNTPOINT davfs rw,uid=<Systemkonto>,gid=<Systemgruppe>,file_mode=0660,dir_mode=0770,_netdev 0 0Ich habe einen angelegten Benutzer, für den REST-Server, der soll auch das DAV Verzeichnis mounten.

Das soll nötig sein, wenn man als User ein DAV Verzeichnis mounten möchte.chmod u+s /usr/sbin/mount.davfs usermod -a -G davfs2 <USER>Nun brauche ich noch die UID des Users, die bekommt man mit

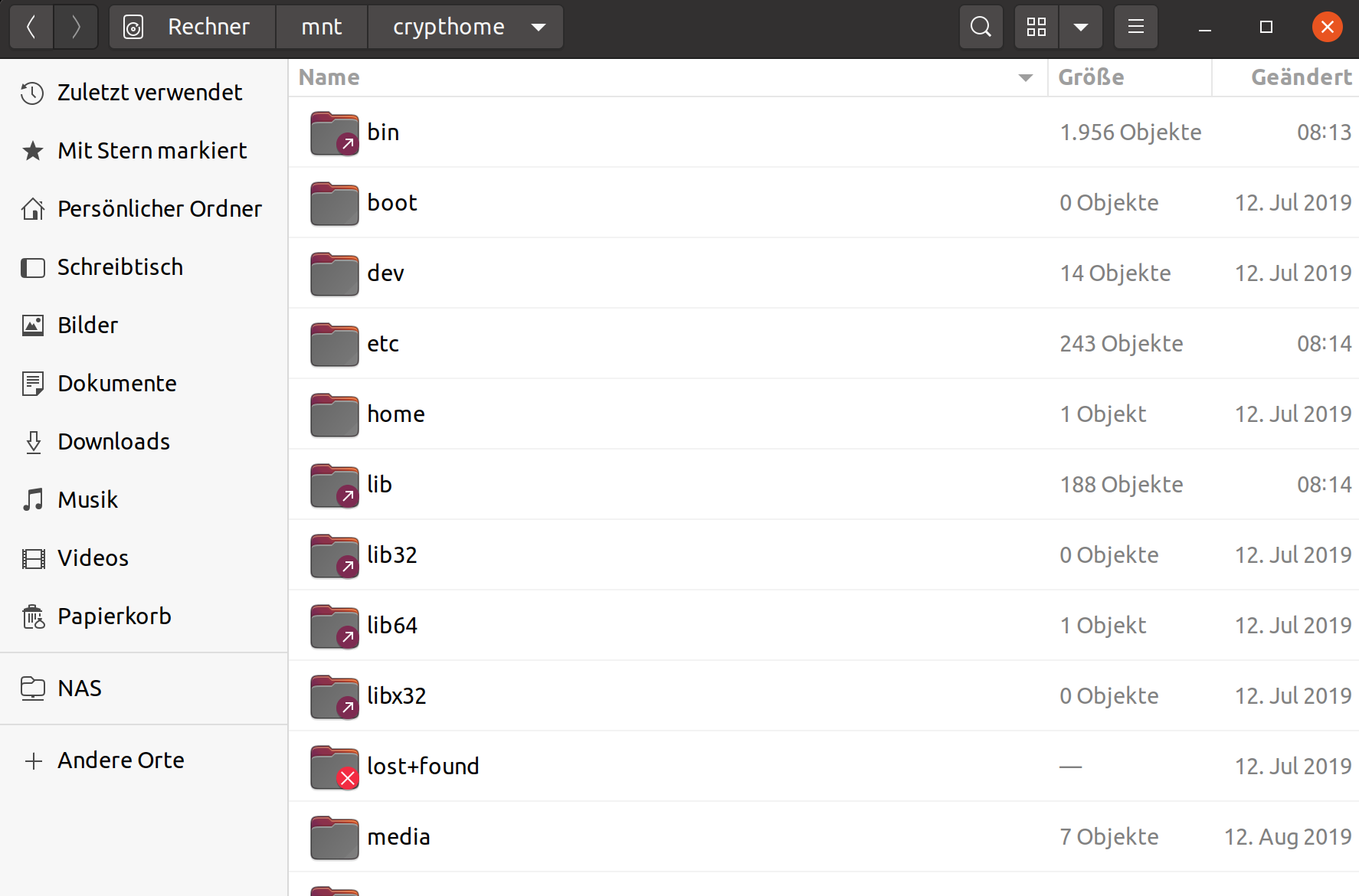

id -u <USER NAME>Bei mir war das Problem gewesen, das ich in meinem Eintrag die falsche UID gesetzt hatte, nach Korrektur klappte alles einwandfrei. Noch ein Problem gibt es. Wenn man den Server mit gemountetem DAV Laufwerk über die Konsole rebootet, mag er das nicht. Ich musste immer, virtuell, den Stecker ziehen. Wenn man vorher, das DAV Verzeichnis entfernt, dann geht es einwandfrei.

umount /mnt/<MOUNT VERZEICHNIS>Quelle: https://docs.hetzner.com/de/robot/storage-box/access/access-webdav

-

-

-

-

-

-

-

Twitter-Beiträge in NodeBB anzeigen

Verschoben NodeBB -

Let's Encrypt installieren

Verschoben Let's Encrypt