It is the #Fedora #Linux 42 day.

-

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.Fedora Linux 42

🔥 Let's check out what's new with Fedora 42 Like, comment, and share to support more content! 📝 Quick Summary of the Video In this video, I review the installation process of Fedora 42, starting wi...

fossHQ (video.fosshq.org)

I have YouTube and Odysee channels too, in case my self-hosted #PeerTube gets overwhelmed. #FedoraLinux #Gnome #KDE

-

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.Fedora Linux 42

🔥 Let's check out what's new with Fedora 42 Like, comment, and share to support more content! 📝 Quick Summary of the Video In this video, I review the installation process of Fedora 42, starting wi...

fossHQ (video.fosshq.org)

I have YouTube and Odysee channels too, in case my self-hosted #PeerTube gets overwhelmed. #FedoraLinux #Gnome #KDE

@darth Installer looks nice. Well done.

-

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.

It is the #Fedora #Linux 42 day. Take a glimpse into the shiny new web installer.Fedora Linux 42

🔥 Let's check out what's new with Fedora 42 Like, comment, and share to support more content! 📝 Quick Summary of the Video In this video, I review the installation process of Fedora 42, starting wi...

fossHQ (video.fosshq.org)

I have YouTube and Odysee channels too, in case my self-hosted #PeerTube gets overwhelmed. #FedoraLinux #Gnome #KDE

@darth Ok i test an instalaltion. I use encrypt for the disk and all went fine but i don't see this Welcome Screen.

And now, when i show your video again i see that the KDE Spin use another installation tool?

-

@darth Ok i test an instalaltion. I use encrypt for the disk and all went fine but i don't see this Welcome Screen.

And now, when i show your video again i see that the KDE Spin use another installation tool?

@FrankM in fedora 42 KDE was promoted to "edition" which makes it "not just a spin" anymore. But you are correct, KDE uses the old Annaconda installer.

-

F frankm@nrw.social shared this topic

F frankm@nrw.social shared this topic

-

-

-

-

-

-

-

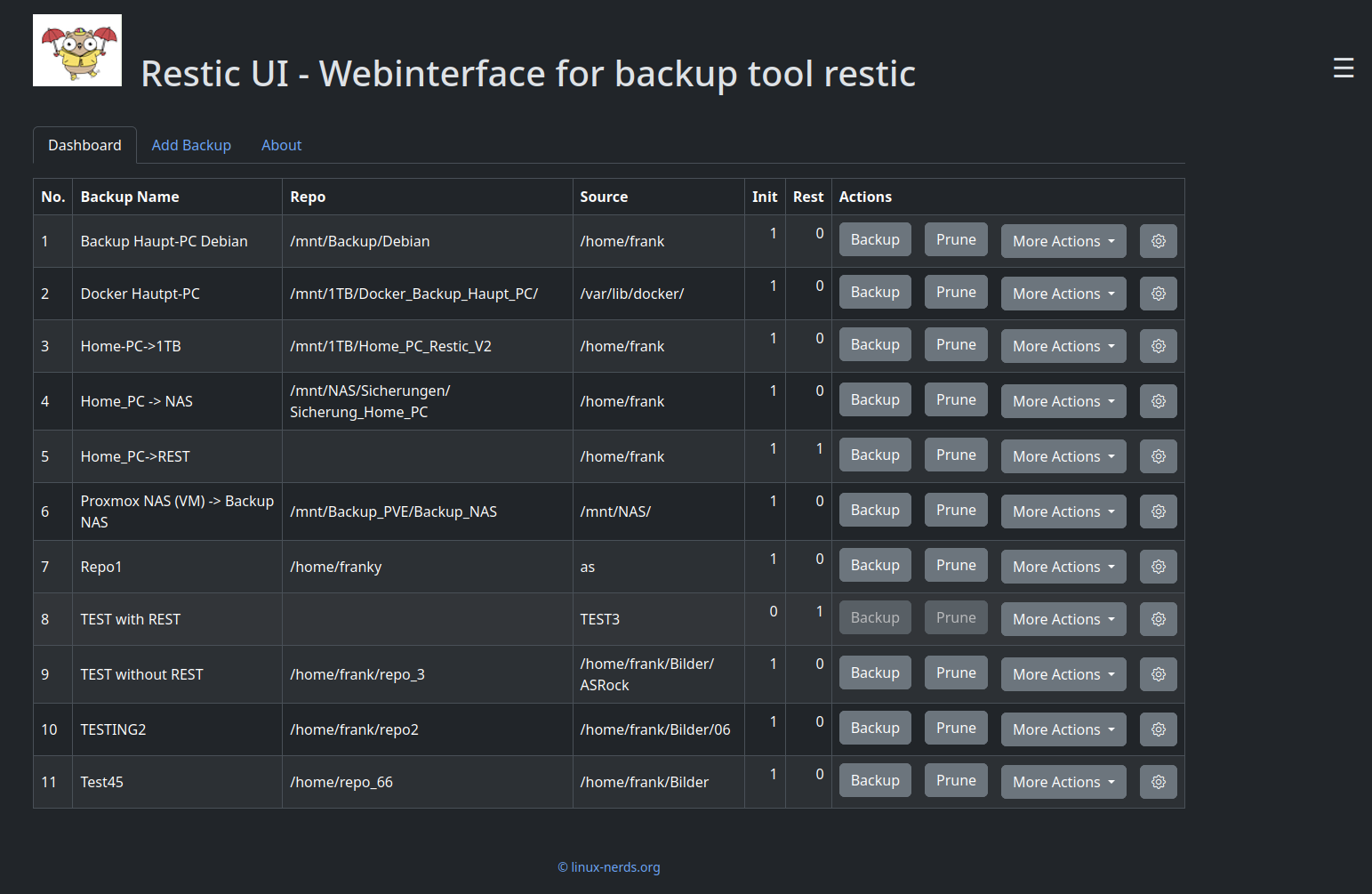

Rest-Server

Verschoben Restic -

checkmk - systemd crasht

Verschoben checkmk