NGINX - Standard .conf

NGINX

3

Beiträge

1

Kommentatoren

446

Aufrufe

-

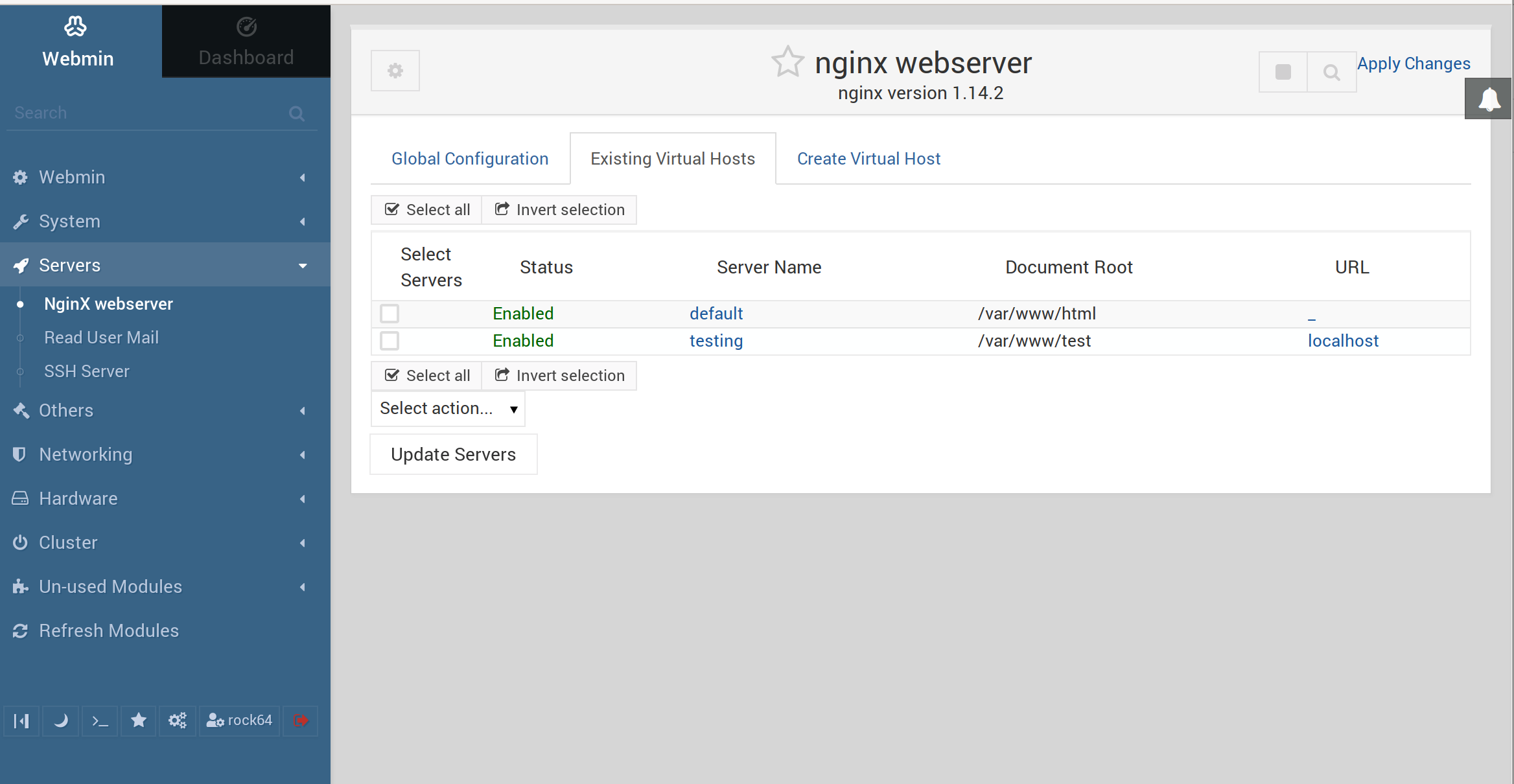

Hier mal meine Standardeinstellungen, die ich so benutze.

#### SSL & Nginx Settings - Begin # Grundeinstellungen ssl_session_timeout 10m; ssl_session_cache shared:SSL:10m; ssl_buffer_size 8k; # OSCP Online Certificate Status Protocol ssl_stapling_verify on; ssl_stapling on; # enables TLSv1.2 & TLSv1.3 ssl_prefer_server_ciphers on; ssl_protocols TLSv1.2 TLSv1.3; ssl_ciphers ECDH+AESGCM:ECDH+CHACHA20:ECDH+AES256:ECDH+AES128:!aNULL:!SHA1; # SSL Certificate ssl_certificate /etc/letsencrypt/live/frank-mankel.de/fullchain.pem; ssl_certificate_key /etc/letsencrypt/live/frank-mankel.de/privkey.pem; ssl_dhparam /etc/nginx/dhparam.pem; # HSTS add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; always"; # Cookie proxy_cookie_path / "/; HTTPOnly; Secure"; # X-Frame-Options add_header X-Frame-Options “SAMEORIGIN”; # Referrer add_header Referrer-Policy “no-referrer”; # Robots add_header X-Robots-Tag all; # X-Download add_header X-Download-Options noopen; # X-Permitted-Cross-Domain-Policies add_header X-Permitted-Cross-Domain-Policies none; # Remove X-Powered-By, which is an information leak fastcgi_hide_header X-Powered-By; # Remove X-Powered-By, which is an information leak fastcgi_hide_header X-Powered-By; #### SSL & Nginx Settings - End -

Da oben habe ich was übersehen. In der Standard Config von Nginx stehen ein paar Sachen schon drin. Das brauchen wir ja dann nicht noch in den Configsfiles der Webseiten.

# disable content type sniffing for more security add_header "X-Content-Type-Options" "nosniff"; # force the latest IE version add_header "X-UA-Compatible" "IE=Edge"; # enable anti-cross-site scripting filter built into IE 8+ add_header "X-XSS-Protection" "1; mode=block";Ich habe die Doppelten im ersten Beitrag gelöscht.

-

Als kleiner Tipp, die meisten Anbieter von Software haben mittlerweile Beispiele, wie man das konfiguriert. Hier mal ein Beispiel von Nextcloud.

-

-

-

-

-

-

-

NodeBB & ads.txt

Verschoben NGINX -